Запуск Iflytek многомодальной модели взаимодействия Iflytek отмечает новую веху в области искусственного интеллекта. Эта модель прорывается через ограничения единого голосового взаимодействия в прошлом, реализует бесшовную интеграцию голосовых, визуальных и цифровых человеческих взаимодействий, приводя пользователей более яркий, более реалистичный и более удобный интерактивный опыт. Его супер-анпоморфные цифровые человеческие технологии могут точно соответствовать голосовому контенту для генерации выражений и действий, и поддерживает супер-антропоморфное взаимодействие, регулировать параметры звука в соответствии с инструкциями и предоставлять персонализированные услуги. Функция мультимодального визуального взаимодействия дает модели возможность «понимать мир и распознавать все», точно воспринимать экологическую информацию и давать более подходящие ответы.

Запуск модели мультимодального взаимодействия Iflytek не только отражает главную позицию Iflytek в области многомодальной технологии взаимодействия, но также предоставляет новые идеи для будущего направления развития приложений искусственного интеллекта. Интегрируя несколько методов взаимодействия, эта модель может лучше понять потребности пользователей и предоставлять более точные и более богатые услуги. Его открытый SDK также предоставляет разработчикам больше возможностей для продвижения популяризации и применения мультимодальной технологии искусственного интеллекта. В будущем мы можем ожидать более инновационных приложений, основанных на этой модели, чтобы повысить эффективность жизненной эффективности людей и ощутить качество.

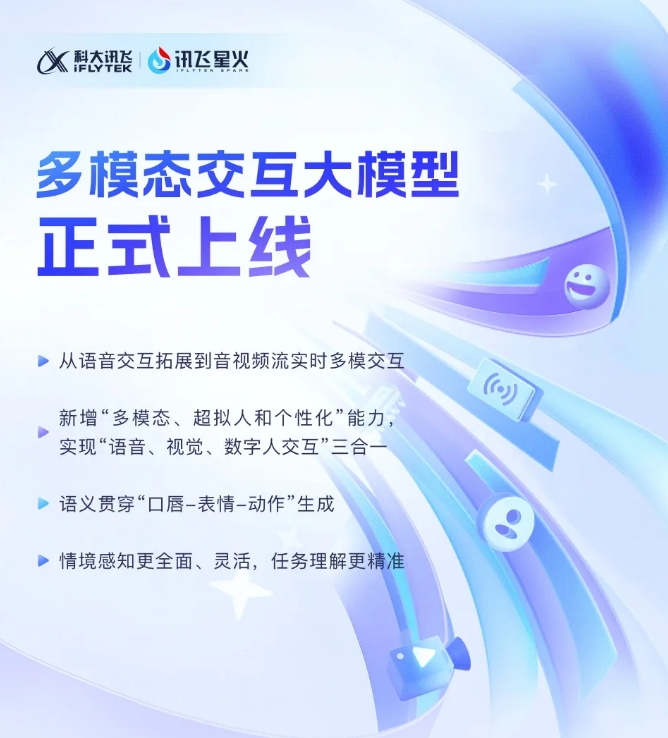

Iflytek недавно объявил, что ее последняя разработка модели мультимодального взаимодействия Iflytek официально была введена в эксплуатацию. Этот технологический прорыв отмечает новый этап в расширении Iflytek от одной технологии голосового взаимодействия до нового этапа мультимодального взаимодействия аудио и видеопотоков в реальном времени. Новая модель интегрирует функции голосового, визуального и цифрового взаимодействия человека, и пользователи могут достичь бесшовной комбинации из трех по одному щелчке.

Запуск модели мультимодального взаимодействия Iflytek впервые ввел супер-антропоморфные цифровые человеческие технологии. настоящий. Интегрируя текст, речь и выражения, новая модель может достичь межмодальной семантической последовательности, что делает эмоциональное выражение более реалистичным и последовательным.

Кроме того, Iflytek Spark поддерживает супер-антропоморфную сверхбыструю технологию взаимодействия, используя единую нейронную сеть для непосредственного реализации сквозного моделирования голоса для голоса, что делает скорость отклика быстрее и более плавнее. Эта технология может широко воспринимать эмоциональные изменения и свободно регулировать ритм, размер и характер звука в соответствии с инструкциями, обеспечивая более персонализированный интерактивный опыт.

С точки зрения мультимодального визуального взаимодействия, Iflytek Spark может «понять мир» и «распознавать все» и полностью воспринимать конкретные фоновые сцены, статус логистики и другую информацию, что делает понимание задачи более точным. Интегрируя различную информацию, такую как голос, жесты, поведение и эмоции, модель может давать соответствующие ответы, предоставляя пользователям более богатый и более точный интерактивный опыт.

Мультимодальное взаимодействие Большая модель SDK: https://www.xfyun.cn/solutions/multimodel

Короче говоря, появление модели мультимодального взаимодействия Iflytek показывает, что технология искусственного интеллекта вступила в новую стадию разработки. С нетерпением жду Iflytek Spark, принесет больше сюрпризов в будущем.