Исследовательская группа Salesforce AI выпустила новейшую мультимодальную языковую модель BLIP-3-Video, направленную на эффективную обработку растущих видеодантеров. Традиционная модель понимания видео неэффективна. Этот шаг решает проблему работы с длинными видео и обеспечивает более сильные возможности для понимания видео для таких отраслей, как автономное вождение и развлечения.

Недавно исследовательская группа Salesforce AI запустила новую мультимодальную языковую модель-BLIP-3-Video. Благодаря быстрому увеличению видеоконтента, как эффективно обрабатывать видеоданные стали неотложной проблемой. Появление этой модели предназначено для повышения эффективности и эффективности понимания видео и подходит для промышленности от автономного вождения до развлечений.

Традиционные модели понимания видео часто обрабатывают видео кадр за кадром, генерируя большое количество визуальной информации. Этот процесс не только потребляет много компьютерных ресурсов, но и значительно ограничивает способность обрабатывать длинные видео. По мере того, как объем видеоданных продолжает расти, этот подход становится все более неэффективным, поэтому крайне важно найти решение, которое отражает критическую информацию видео при одновременном сокращении вычислительного бремени.

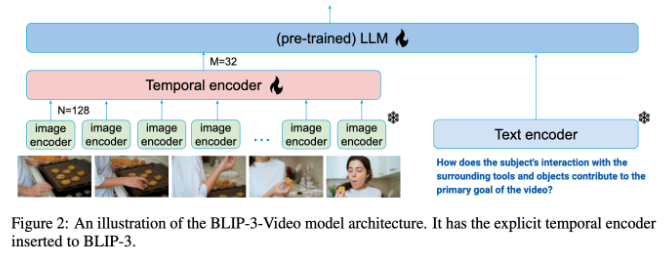

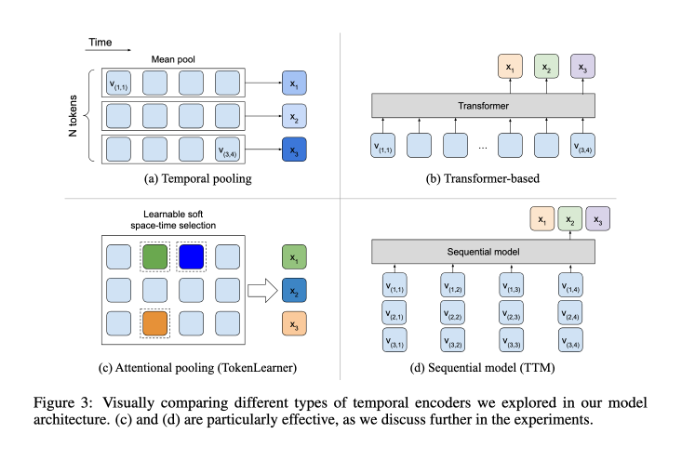

В связи с этим BLIP-3-Video показал довольно хорошо. Внедрив «энкодер последовательности временной последовательности», модель успешно уменьшила объем визуальной информации, необходимой в видео до 16-32 визуальных маркеров. Этот инновационный дизайн значительно повышает эффективность вычислений, позволяя моделям выполнять сложные видео -задачи по более низкой цене. В этом временном кодере используется механизм объединения пространственно -временного внимания, который извлекает наиболее важную информацию из каждого кадра и интегрирует его в компактный набор визуальных маркеров.

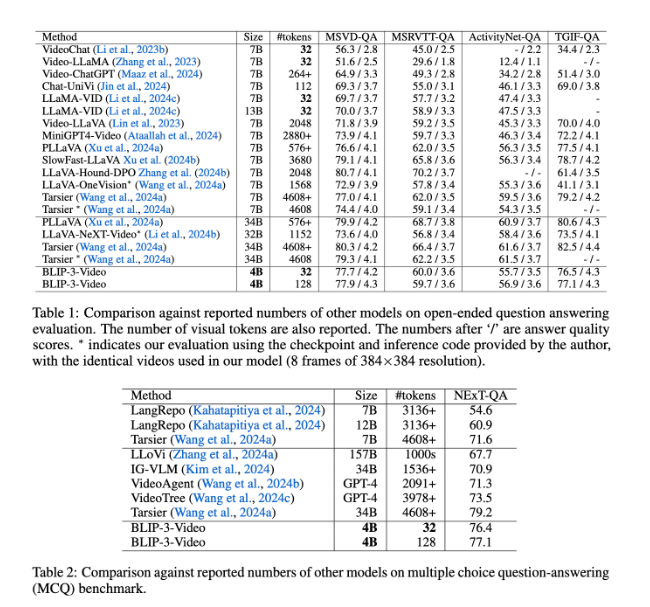

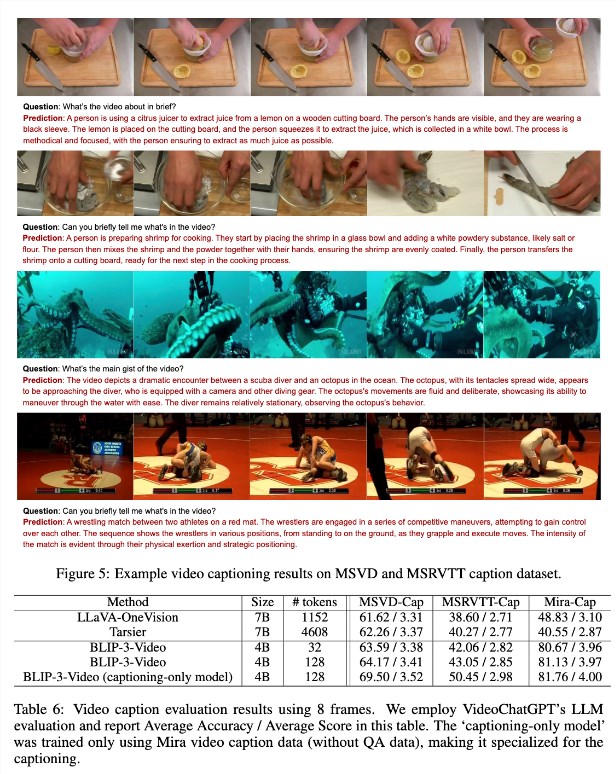

Blip-3-Video также показал очень хорошо. По сравнению с другими крупными моделями, исследование показало, что модель имеет скорость точности сопоставимых лучших моделей в задачах Q & A. Например, модель Tarsier-34B требует 4608 баллов для обработки 8 кадров видео, в то время как BLIP-3-Video требует всего 32 балла для достижения оценки MSVD-QA 77,7%. Это показывает, что BLIP-3-Video значительно снижает потребление ресурсов, сохраняя при этом высокую производительность.

Кроме того, производительность BLIP-3-Video в задачах с несколькими вариантами ответов не следует недооценивать. В наборе данных Next-QA модель достигла высокой оценки 77,1%, в то время как в наборе данных TGIF-QA она также достигла уровня точности 77,1%. Все эти данные указывают на эффективность BLIP-3-Video при решении сложных видео-проблем.

BLIP-3-Video открывает новые возможности в области обработки видео с помощью инновационных кодеров времени. Запуск этой модели не только повышает эффективность понимания видео, но также предоставляет больше возможностей для будущих видео приложений.

Вход в проект: https://www.salesforceairesearch.com/opensource/xgen-mm-vid/index.html

Ключевые моменты:

-** Выпуск новой модели **: Salesforce AI Research запускает BLIP-3-Video, мультимодальную языковую модель, фокусируясь на обработке видео.

- ** Эффективная обработка **: использование временного кодера значительно уменьшает количество необходимых визуальных знаков и значительно повышает эффективность вычислений.

- ** Превосходная производительность **: отличная производительность в задачах Q & A Video Q & A, сохраняют высокую точность, одновременно снижая потребление ресурсов.

Короче говоря, BLIP-3-Video принес значительный прогресс в области понимания видео с его эффективными возможностями обработки и превосходной производительности, а его перспективы применения широкие. Открытый источник этой модели также обеспечивает хорошую основу для дальнейших исследований и применения.