Благодаря быстрой разработке мультимодальной большой языковой модели (MLLM) эффективная обработка сверхдруг-видео стала горячей темой в текущих исследованиях. Существующие модели часто ограничены длиной контекста и вычислительными затратами, что затрудняет эффективное понимание почасовых видео. В ответ на эту задачу, Научно-исследовательский институт Чжиюань и несколько университетов запустили Video-XL, сверхпрочную модель визуального языка, разработанную специально для эффективного понимания видео на часовом уровне.

В настоящее время мультимодальная большая языковая модель (MLLM) добилась значительного прогресса в области понимания видео, но обработка сверх длинных видео остается проблемой. Это связано с тем, что MLLM часто изо всех сил пытаются справиться с тысячами визуальных маркеров, которые превышают максимальную длину контекста и подвержены влиянию ослабления информации, вызванной агрегацией MANK. В то же время большое количество видеотех также принесет высокие затраты на вычислительные средства.

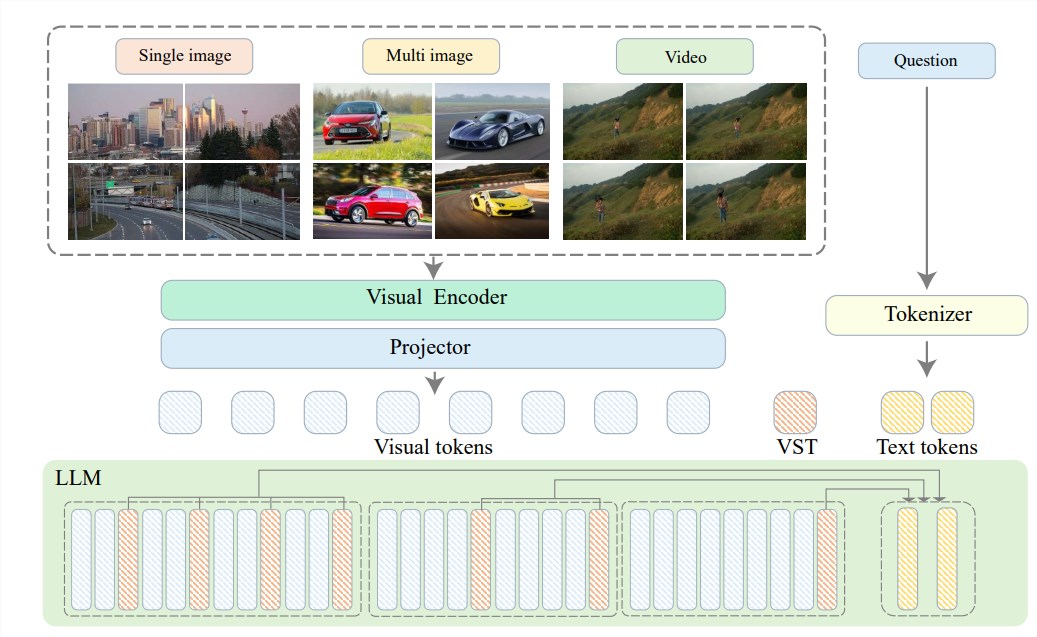

Чтобы решить эти проблемы, Научно-исследовательский институт Чжийюа предложил Video-XL совместно с Университетом Шанхай Джиатонг, Китайским университетом Ренмина, Пекинским университетом и в Пекинском университете постов и телекоммуникациям, сверхпрофильным специализированным для эффективного понимания видео языковая модель. В основе видео-xl лежит в технологии «Сводка потенциала визуального контекста», которая использует возможности моделирования контекста, присущие LLM для эффективного сжатия длинных визуальных представлений в более компактные формы.

Проще говоря, он должен сжать видеоконтент в более упорядоченную форму, как концентрировать целую говядину в миску эссенции говядины, что удобно для переваривания и поглощения модели.

Эта технология сжатия не только повышает эффективность, но и эффективно сохраняет ключевую информацию видео. Вы должны знать, что длинные видео часто заполняются большим количеством избыточной информации, как и переплет для ног старушки, что длинное и вонючие. Video-XL может точно устранить эту бесполезную информацию и сохранить только сущность, которая гарантирует, что модель не потеряет свое направление при понимании длинного видеоконтента.

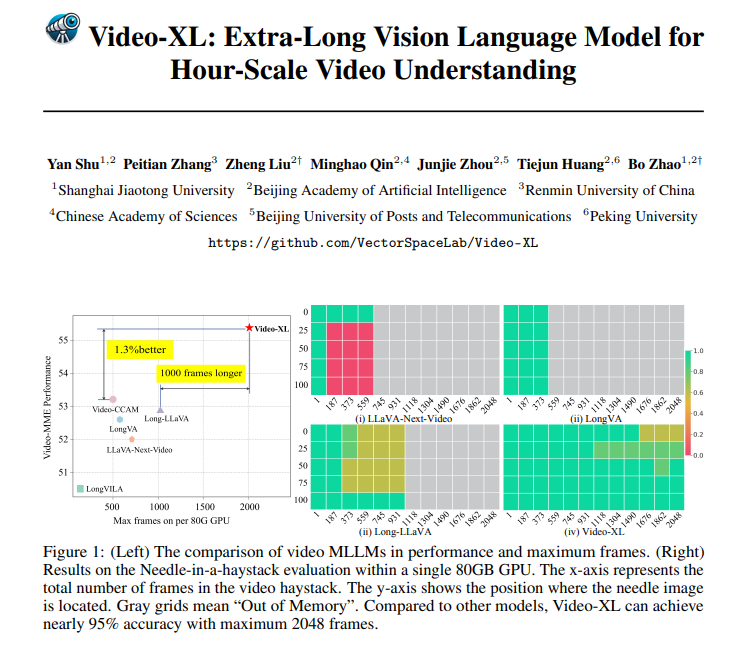

Видео-XL не только очень мощный в теории, но и имеет очень мощные практические способности. Video-XL руководил несколькими длинными показателями понимания видео, особенно в тесте Vnbench, с точностью почти на 10% выше, чем лучшие существующие методы.

Что еще более впечатляет, так это то, что Video-xl наносит удивительный баланс между эффективностью и эффективностью, он может обрабатывать 2048 кадров видео на одном графическом процессоре 80 ГБ, сохраняя при этом почти 95% точность «Найдите иглу в сеносе».

Video-XL имеет очень широкую перспективу приложения. В дополнение к пониманию общих длинных видео, оно также может быть компетентным для определенных задач, таких как краткое изложение фильмов, мониторинг обнаружения аномалий и распознавание рекламных имплантатов.

Это означает, что вам не нужно терпеть длительный сюжет при просмотре фильмов в будущем. События, которые гораздо более эффективны, чем ручное преследование.

Адрес проекта: https://github.com/vectorspacelab/video-xl

Бумага: https://arxiv.org/pdf/2409.14485

Короче говоря, Video-XL добился прорыва в области сверхпрочного понимания видео.