Исследователи из Принстонского университета и Йельского университета провели углубленные исследования по способности «Цепочка мышления» (COT) »на способности крупных языковых моделей (LLM) и выпустили соответствующие отчеты. Исследование взяло на то, чтобы взломать пароль смены в качестве тестовой задачи и выбрало три LLMS GPT-4, Claude3 и Llama3.1 для анализа, направленного на выявление механизма вывода Cot. Исследования показали, что рассуждения LLM в COT не являются простым символическим логическим рассуждением, а результатом сложного взаимодействия нескольких факторов, что обеспечивает для нас новую перспективу для понимания способности LLM.

Исследователи из Принстона и Йельского университета недавно опубликовали отчет о способности «связывания цепочки (COT)» в модели большого языка (LLM), раскрывающего тайну рассуждений COT: это не символические рассуждения, основанные исключительно на логических правилах, но, но Он сочетает в себе память, вероятность и шумовые рассуждения.

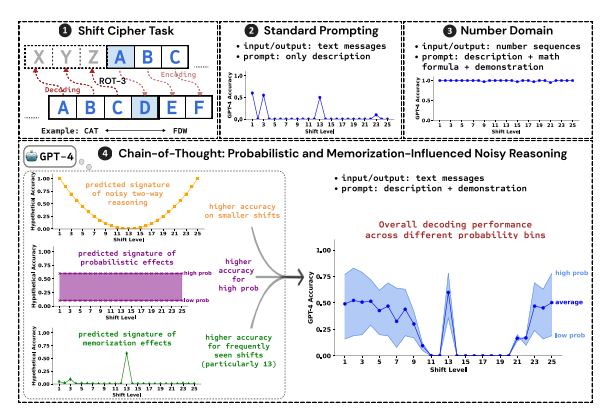

Исследователи использовали трещины пароля смены в качестве испытательного задания для анализа производительности трех LLMS, GPT-4, Claude3 и Llama3.1. Пароли смены - это простой метод кодирования, и каждая буква заменяется буквами, которые движутся вперед в алфавите с фиксированными цифрами. Например, переместите алфавит вперед на 3 цифры, а «кошка» становится «FDW».

Результаты исследований показывают, что три ключевых фактора, влияющие на эффективность вывода COT:

Вероятность: LLM имеет тенденцию генерировать выходы с более высокой вероятностью, даже если шаг вывода указывает на ответы с более низкой вероятностью. Например, если шаг рассуждения указывает на «Staz», но «Stay» - это более распространенное слово, LLM может «исправить себя» и выводить «оставаться».

Память: LLM помнит большой объем текстовых данных во время предварительного обучения, что влияет на точность ее вывода. Например, ROT-13 является наиболее распространенным паролем смены, и LLM имеет значительно более высокую точность на ROT-13, чем другие типы паролей смены.

Рассуждение о шуме: процесс рассуждения LLM не совсем точен, но есть определенная степень шума. По мере увеличения смещения пароля смены промежуточные шаги, необходимые для декодирования, также увеличиваются, и влияние шумового вывода становится более очевидным, что приводит к снижению точности LLM.

Исследователи также обнаружили, что рассуждения LLM в COT опираются на самодостаточность, то есть LLM необходимо явно генерировать текст как контекст для последующих этапов рассуждения. Если LLM поручено «мыслить молча», не выводя какого -либо текста, его способность рассуждать будет значительно снижена. Кроме того, эффективность демонстрационного этапа мало влияет на вывод COT.

Это исследование показывает, что рассуждения LLM не являются идеальными символическими рассуждениями, но объединяет несколько факторов, таких как память, вероятность и шумовые рассуждения. LLM не только показывает характеристики мастера памяти в процессе рассуждений Cot, но и показывает стиль мастера вероятности. Это исследование помогает нам более глубоко понять возможности рассуждений LLM и обеспечить ценную информацию о будущем развитии более мощных систем ИИ.

Бумажный адрес: https://arxiv.org/pdf/2407.01687

Таким образом, это исследование имеет большое значение для понимания механизма рассуждений крупных языковых моделей, а его результаты обеспечивают ценную ссылку на улучшение возможностей рассуждений в будущем и разработки более мощных систем ИИ. В исследовании подчеркивается влияние таких факторов, как вероятность, память и шум на рассуждения LLM, предоставляя новые направления для исследователей в области искусственного интеллекта.