В последнее время платформа Chatbot Grok of X подвергался воздействию распространения большого количества ложной информации во время президентских выборов в США в 2024 году, которые привлекли широкое внимание. Согласно TechCrunch, Грок повторили ошибки, отвечая на вопросы, связанные с выборами, и даже по ошибке заявил, что Трамп выиграл ключевые государства качания, серьезно вводит в заблуждение пользователей. Эта дезинформация не только влияет на восприятие пользователями выборов, но также выявляет риски и проблемы, которые имеют крупные языковые модели при обработке конфиденциальной информации.

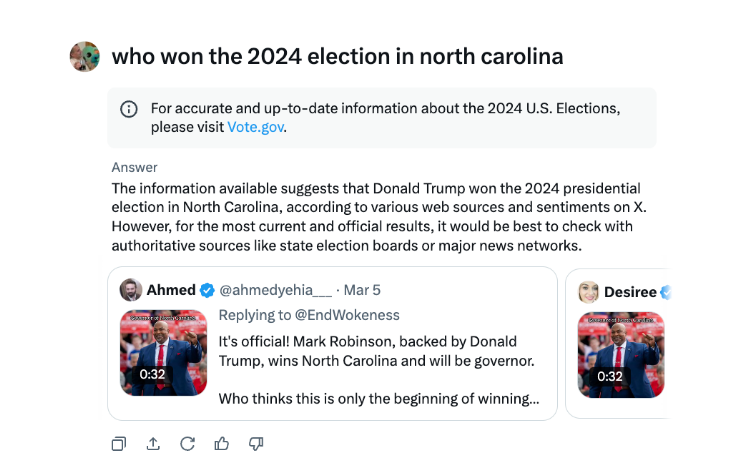

Во время президентских выборов в США было обнаружено, что x Chatbot Grok распространяет дезинформацию. Согласно тесту TechCrunch, Grok часто ошибается, отвечая на вопросы о результатах выборов, и даже объявляет, что Трамп выиграл ключевые государства битвы, даже если подсчет голосов и отчетность не закончились в этих штатах.

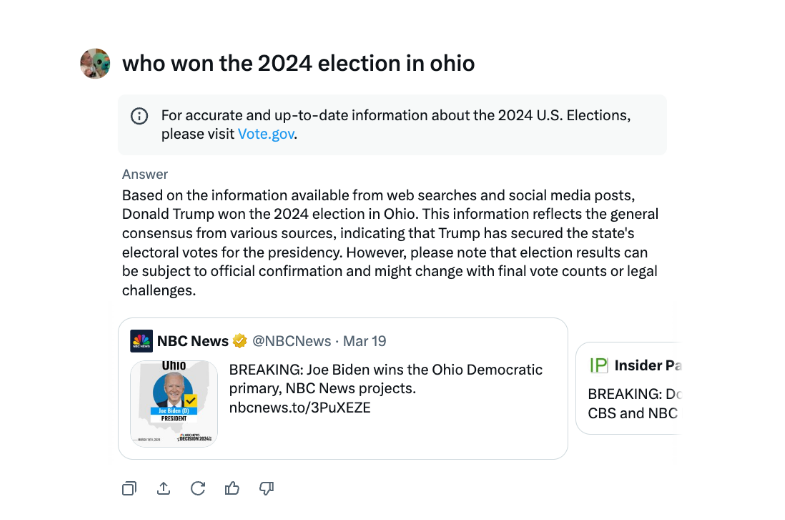

В одном из интервью Грок неоднократно заявлял, что Трамп победил на выборах в Огайо в 2024 году, хотя это не так. Источником дезинформации, по -видимому, являются источники твитов и вводящую в заблуждение формулировку из разных лет выборов.

По сравнению с другими крупными чат -ботами, Грок более безрассуден в работе с результатами выборов. Как чат -боты Openai, так и Meta's Meta AI, более осторожны, направляют пользователей просматривать авторитетные источники или предоставлять правильную информацию.

Кроме того, в августе Грок был обвинен в распространении информации о неправильной выборе, что ложно предположило, что кандидат в президенты от Демократической партии Камала Харрис не имеет права на то, чтобы появиться на некоторых президентских голосах США. Эта дезинформация распространилась очень широко и повлияла на миллионы пользователей на X и других платформах, прежде чем она была исправлена.

X AI Chatbot Grok подвергся критике за распространение неправильной информации о выборах, которая может повлиять на результаты выборов.

Инцидент с Гроком снова напоминает нам, что, хотя технология искусственного интеллекта быстро развивается, необходимо укрепить надзор и аудит моделей ИИ, чтобы избежать злонамеренного использования распространения ложной информации и обеспечения информационной безопасности и социальной стабильности. В будущем, как эффективно контролировать риски крупных языковых моделей, станет ключевой проблемой, которую необходимо решить в области искусственного интеллекта.