Исследовательские группы из Стэнфордского университета и Вашингтонского университета недавно выпустили прорывной метод обучения искусственного интеллекта под названием S1. В отличие от прошлой зависимости от огромной вычислительной мощности или сложных алгоритмов, метод S1 умно достигает скачка производительности, контролируя распределение вычислительных ресурсов модели во время тестирования.

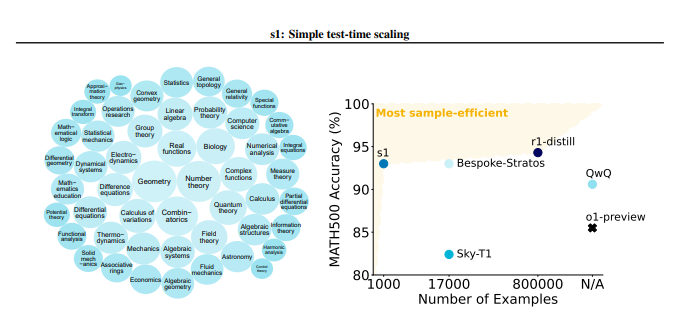

Метод S1 сначала тщательно построил небольшой набор данных, называемый S1K, который содержал 1000 высококачественных задач вывода. Стандарты скрининга этого набора данных очень строгие и должны соответствовать трем условиям высокой сложности, сильного разнообразия и отличного качества одновременно. Исследовательская группа провела важность этих трех критериев посредством подробных экспериментов с абляцией, и результаты показали, что случайный выбор или сосредоточение внимания на одном критерии приведут к значительному снижению производительности. Стоит отметить, что даже если обучать с использованием суперсета, содержащего 59 000 образцов, его эффект гораздо меньше, чем у тщательно отобранных 1000 образцов, что подчеркивает критичность выбора данных.

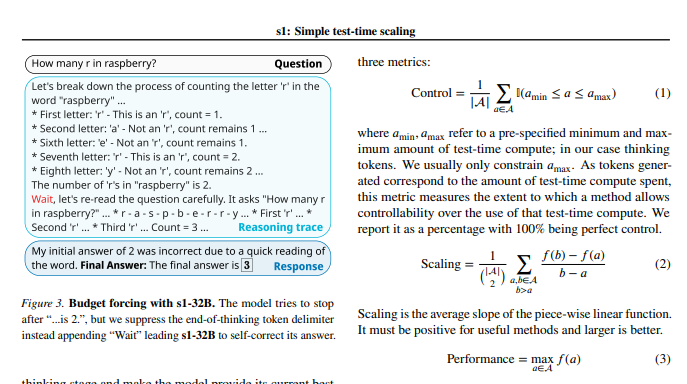

После того, как модельное обучение было завершено, исследователи использовали методику, называемую «бюджетным обязательным», чтобы контролировать объем расчетов во время тестирования. Проще говоря, этот метод расширяет время мышления модели, насильно завершая процесс мышления модели или добавляя инструкции «ждать», тем самым направляя модель для более глубоких исследований и проверки. Таким образом, модель может многократно проверять шаги вывода и эффективно исправлять ошибки.

Экспериментальные результаты показывают, что при тонкой настройке набора данных S1K и поддержкой «бюджетной обязательной» технологии, производительность модели S1-32B в математических задачах на уровне конкуренции превысила модель Openai от O1-Preview до 27%. Что еще более удивительно, так это то, что благодаря «бюджетному обязательному» масштабированию модель S1-32B также показала способность обобщения за пределами собственного уровня обучения, и ее оценка по испытательному набору AIME24 увеличилась с 50% до 57%.

Основным вкладом этого исследования является то, что он обеспечивает простой и эффективный метод для создания наборов данных с высокими возможностями вывода и достижения масштабирования производительности при тестировании. Основываясь на этом, исследовательская группа создала модель S1-32B, чья производительность сопоставима или даже превосходит модель с замкнутым исходным кодом и в то же время достигает эффективности с открытым исходным кодом и высокой выборки. Код, модель и данные для исследования открыты на GitHub.

Исследователи также провели углубленные эксперименты с абляцией на тонкостях данных и методике масштабирования во время тестирования. Что касается данных, они обнаружили, что ему очень важно учитывать трудности, разнообразие и качество одновременно. С точки зрения масштабирования во время тестирования, «бюджетный обязательный» подход показывает превосходную управляемость и улучшение производительности. В исследовании также рассматриваются два различных метода, параллельное масштабирование и последовательное масштабирование, а также вводит передовые технологии, такие как Rebase, обеспечивая важное вдохновение для будущих направлений исследований.

Это исследование не только привносит новую недорогую и высокоэффективную идею в область обучения ИИ, но и закладывает прочную основу для более широкого диапазона применений ИИ.

Бумажный адрес: https://arxiv.org/pdf/2501.19393

Это исследование демонстрирует, что благодаря тщательному набору данных построению и тестированию времени вычислительных ресурсов возможности вывода моделей искусственного интеллекта могут быть значительно улучшены, обеспечивая новые направления для будущей разработки ИИ.