Недавно команда Vita-MLLM выпустила свои последние результаты исследования Vita-1,5. Vita-1.5 не только поддерживает два языка: английский и китайский, но и достигает качественного скачка в нескольких показателях производительности, что приносит пользователям более плавный и более эффективный интерактивный опыт.

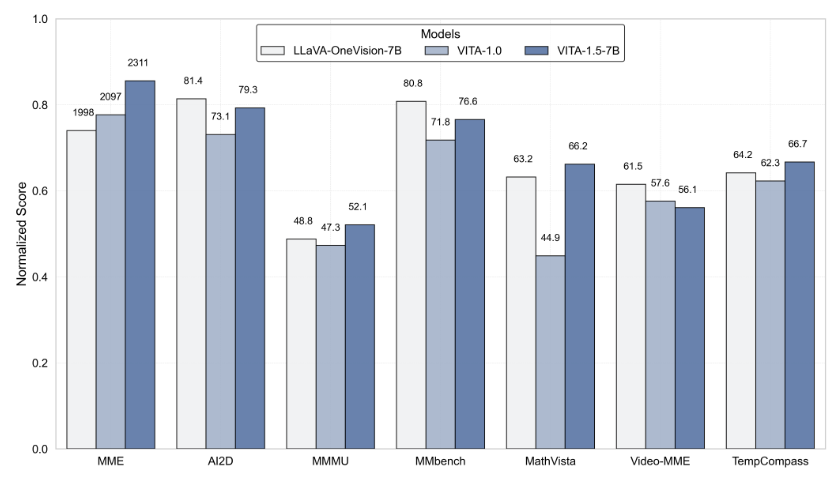

VITA-1,5 сделала серьезный прорыв в задержке взаимодействия, значительно сократив первоначальную 4-секундную задержку до 1,5 секунды. Это улучшение позволяет пользователям почти не задержать во время голосового взаимодействия, значительно улучшая пользовательский опыт. Кроме того, VITA-1,5 также значительно улучшил мультимодальную производительность.

С точки зрения обработки голоса, Vita-1,5 также была глубоко оптимизирована. Частота ошибок системы автоматического распознавания речи (ASR) упала с 18,4 до 7,5, что значительно повысило точность понимания и отклика голосовых команд. В то же время, Vita-1.5 представляет новый сквозной модуль текста в речь (TTS), который может напрямую получать встраивания от больших языковых моделей (LLM) в качестве входных данных, значительно улучшая естественность и когерентность синтеза речи. Полем

Чтобы обеспечить баланс мультимодальных возможностей, Vita-1,5 принимает стратегию прогрессивного обучения, которая сводит к минимуму влияние вновь добавленного модуля речи на производительность визуального языка, а производительность понимания изображений лишь немного снизилось с 71,3 до 70,8. Благодаря этим технологическим инновациям VITA-1.5 дополнительно способствует границам визуальных и голосовых взаимодействий в реальном времени, закладывая прочную основу для будущих интеллектуальных применений взаимодействия.

Для разработчиков Vita-1,5 очень удобен в использовании. Разработчики могут быстро начать работу с простыми операциями командной строки, а команда также предоставляет базовые интерактивные демонстрации в реальном времени, чтобы помочь пользователям лучше понять и использовать систему. Чтобы еще больше улучшить интерактивный опыт в реальном времени, пользователи должны подготовить некоторые необходимые модули, такие как модуль обнаружения голосовой активности (VAD). Кроме того, Кодекс VITA-1.5 будет полностью открытым исходным кодом, что позволит разработчикам участвовать и вносить свой вклад, а также содействовать продвижению этой технологии.

Запуск VITA-1,5 отмечает еще одну важную веху в области интерактивной мультимодальной большой языковой модели, демонстрируя неослабную преследование команды Vita-MLLM в области технологических инноваций и пользовательского опыта. Выпуск этой версии не только приносит пользователям более интеллектуальный интерактивный опыт, но и указывает на направление будущей разработки мультимодальной технологии.

Вход в проект: https://github.com/vita-mllm/vita?tab=readme-ov-file

Ключевые моменты:

Vita-1,5 значительно снижает латентность взаимодействия, сокращая от 4 секунд до 1,5 секунды, значительно улучшая пользовательский опыт.

Мультимодальная производительность улучшилась, причем средняя производительность множества тестов увеличилась с 59,8 до 70,8.

Возможность обработки голоса повышается, частота ошибок ASR упала с 18,4 до 7,5, а распознавание речи более точное.