อังกฤษ | 中文 | 日本語

ชุดข้อมูล | เกณฑ์มาตรฐาน | - โมเดล | - กระดาษ

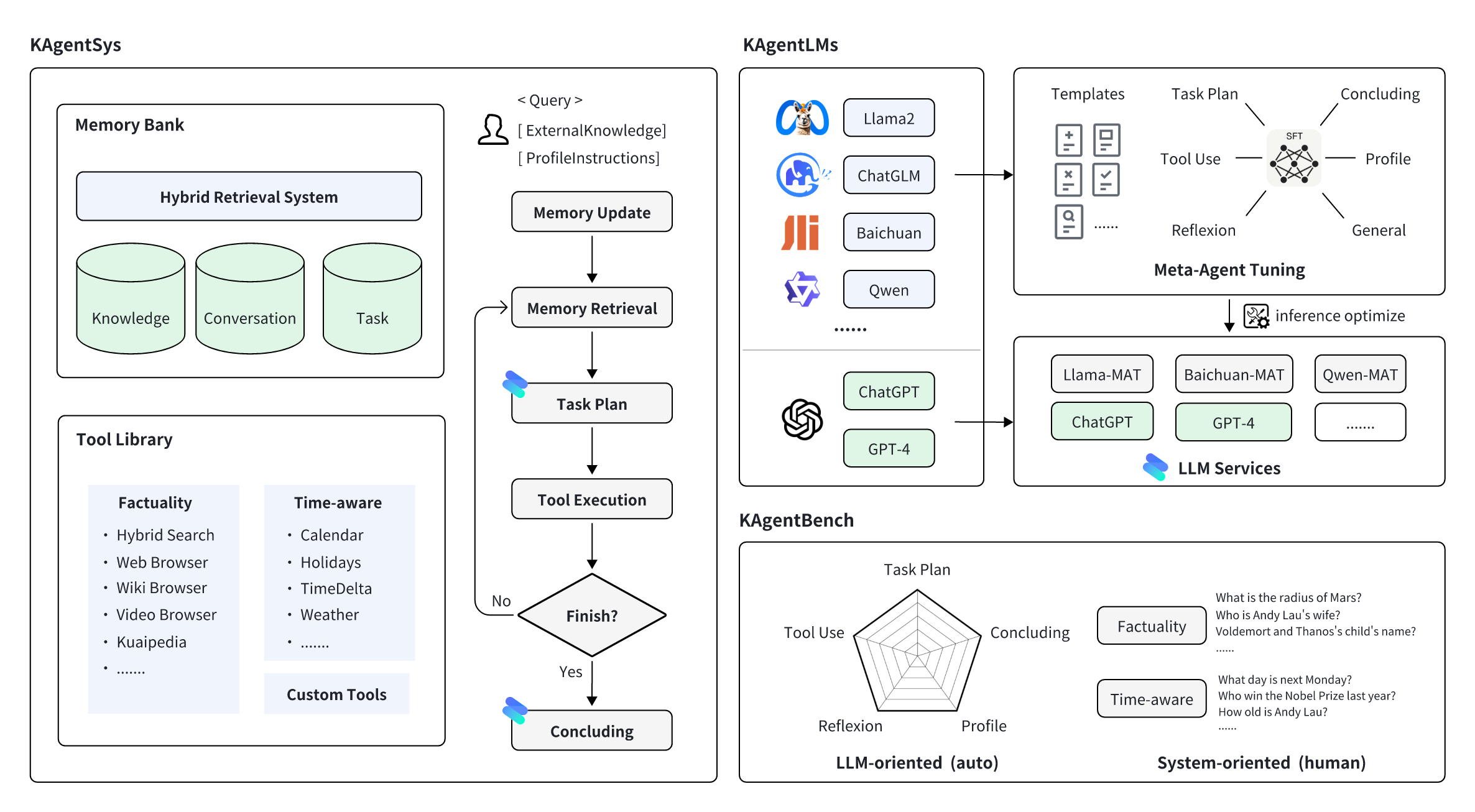

KwaiAgents คือชุดผลงานที่เกี่ยวข้องกับเอเจนต์ซึ่งจัดทำโดย KwaiKEG จาก Kuaishou Technology เนื้อหาโอเพ่นซอร์สประกอบด้วย:

| พิมพ์ | โมเดล | ข้อมูลการฝึกอบรม | ข้อมูลมาตรฐาน |

| เกว็น | เควน-7B-MAT เควน-14B-MAT Qwen-7B-MAT-cpp Qwen1.5-14B-MAT | KAgentInstruct | KAgentBench |

| ไป๋ชวน | ไป๋ชวน2-13B-MAT |

| มาตราส่วน | การวางแผน | การใช้เครื่องมือ | การสะท้อนกลับ | สรุป | ประวัติโดยย่อ | คะแนนรวม | |

|---|---|---|---|---|---|---|---|

| GPT-3.5-เทอร์โบ | - | 18.55 | 26.26 | 8.06 | 37.26 | 35.42 | 25.63 |

| ลามะ2 | 13B | 0.15 | 0.44 | 0.14 | 16.60 | 17.73 | 5.30 |

| แชท GLM3 | 6B | 7.87 | 11.84 | 7.52 | 30.01 | 30.14 | 15.88 |

| เกว็น | 7B | 13.34 | 18.00 น | 7.91 | 36.24 | 34.99 | 21.17 |

| ไป๋ชวน2 | 13B | 6.70 | 16.10 | 6.76 | 24.97 | 19.08 | 14.89 |

| เครื่องมือลามะ | 7B | 0.20 | 4.83 | 1.06 | 15.62 | 10.66 | 6.04 |

| เอเจนท์LM | 13B | 0.17 | 0.15 | 0.05 | 16.30 น | 15.22 | 4.88 |

| Qwen-MAT | 7B | 31.64 | 43.30 น | 33.34 | 44.85 | 44.78 | 39.85 |

| ไป๋ชวน2-MAT | 13B | 37.27 | 52.97 | 37.00 น | 48.01 | 41.83 | 45.34 |

| Qwen-MAT | 14B | 43.17 | 63.78 | 32.14 | 45.47 | 45.22 | 49.94 |

| Qwen1.5-MAT | 14B | 42.42 | 64.62 | 30.58 | 46.51 | 45.95 | 50.18 |

| มาตราส่วน | ไม่มีตัวแทน | ตอบสนอง | อัตโนมัติ-GPT | เคเจนท์ซิส | |

|---|---|---|---|---|---|

| GPT-4 | - | 57.21% (3.42) | 68.66% (3.88) | 79.60% (4.27) | 83.58% (4.47) |

| GPT-3.5-เทอร์โบ | - | 47.26% (3.08) | 54.23% (3.33) | 61.74% (3.53) | 64.18% (3.69) |

| เกว็น | 7B | 52.74% (3.23) | 51.74% (3.20) | 50.25% (3.11) | 54.23% (3.27) |

| ไป๋ชวน2 | 13B | 54.23% (3.31) | 55.72% (3.36) | 57.21% (3.37) | 58.71% (3.54) |

| Qwen-MAT | 7B | - | 58.71% (3.53) | 65.67% (3.77) | 67.66% (3.87) |

| ไป๋ชวน2-MAT | 13B | - | 61.19% (3.60) | 66.67% (3.86) | 74.13% (4.11) |

ติดตั้ง miniconda สำหรับสภาพแวดล้อมการสร้างก่อน จากนั้นสร้าง build env ก่อน:

conda create -n kagent python=3.10

conda activate kagent

pip install -r requirements.txtเราขอแนะนำให้ใช้ vLLM และ FastChat เพื่อปรับใช้บริการการอนุมานแบบจำลอง ขั้นแรก คุณต้องติดตั้งแพ็คเกจที่เกี่ยวข้อง (สำหรับการใช้งานโดยละเอียด โปรดดูเอกสารประกอบของทั้งสองโปรเจ็กต์):

pip install vllm

pip install " fschat[model_worker,webui] "pip install " fschat[model_worker,webui] "

pip install vllm==0.2.0

pip install transformers==4.33.2หากต้องการปรับใช้ KAgentLM คุณต้องเริ่มคอนโทรลเลอร์ในเทอร์มินัลเดียวก่อน

python -m fastchat.serve.controllerประการที่สอง คุณควรใช้คำสั่งต่อไปนี้ในเทอร์มินัลอื่นสำหรับการปรับใช้บริการการอนุมาน GPU เดียว:

python -m fastchat.serve.vllm_worker --model-path $model_path --trust-remote-code โดยที่ $model_path คือพาธในเครื่องของโมเดลที่ดาวน์โหลด หาก GPU ไม่รองรับ Bfloat16 คุณสามารถเพิ่ม --dtype half ลงในบรรทัดคำสั่งได้

ประการที่สาม เริ่มต้นเซิร์ฟเวอร์ REST API ในเทอร์มินัลที่สาม

python -m fastchat.serve.openai_api_server --host localhost --port 8888สุดท้าย คุณสามารถใช้คำสั่ง curl เพื่อเรียกใช้โมเดลที่เหมือนกับรูปแบบการโทร OpenAI นี่คือตัวอย่าง:

curl http://localhost:8888/v1/chat/completions

-H " Content-Type: application/json "

-d ' {"model": "kagentlms_qwen_7b_mat", "messages": [{"role": "user", "content": "Who is Andy Lau"}]} ' ที่นี่ เปลี่ยน kagentlms_qwen_7b_mat เป็นโมเดลที่คุณปรับใช้

llama-cpp-python เสนอเว็บเซิร์ฟเวอร์ซึ่งมีจุดมุ่งหมายเพื่อทำหน้าที่แทนที่ OpenAI API แบบดรอปอิน ซึ่งจะทำให้คุณสามารถใช้โมเดลที่เข้ากันได้กับ llama.cpp กับไคลเอนต์ที่รองรับ OpenAI (ไลบรารีภาษา บริการ ฯลฯ) สามารถดูโมเดลที่แปลงแล้วได้ใน kwaikeg/kagentlms_qwen_7b_mat_gguf

หากต้องการติดตั้งแพ็คเกจเซิร์ฟเวอร์และเริ่มต้น:

pip install " llama-cpp-python[server] "

python3 -m llama_cpp.server --model kagentlms_qwen_7b_mat_gguf/ggml-model-q4_0.gguf --chat_format chatml --port 8888สุดท้าย คุณสามารถใช้คำสั่ง curl เพื่อเรียกใช้โมเดลที่เหมือนกับรูปแบบการโทร OpenAI นี่คือตัวอย่าง:

curl http://localhost:8888/v1/chat/completions

-H " Content-Type: application/json "

-d ' {"messages": [{"role": "user", "content": "Who is Andy Lau"}]} 'ดาวน์โหลดและติดตั้ง KwaiAgents Python ที่แนะนำ>=3.10

git clone [email protected]:KwaiKEG/KwaiAgents.git

cd KwaiAgents

python setup.py develop export OPENAI_API_KEY=sk-xxxxx

export WEATHER_API_KEY=xxxxxx

WEATHER_API_KEY ไม่ได้บังคับ แต่คุณต้องกำหนดค่าเมื่อถามคำถามเกี่ยวกับสภาพอากาศ คุณสามารถรับคีย์ API ได้จากเว็บไซต์นี้ (เหมือนกันสำหรับการใช้งานรุ่นท้องถิ่น)

kagentsys --query= " Who is Andy Lau's wife? " --llm_name= " gpt-3.5-turbo " --lang= " en "หากต้องการใช้โมเดลในเครื่อง คุณต้องปรับใช้บริการโมเดลที่เกี่ยวข้องตามที่อธิบายไว้ในบทที่แล้ว

kagentsys --query= " Who is Andy Lau's wife? " --llm_name= " kagentlms_qwen_7b_mat "

--use_local_llm --local_llm_host= " localhost " --local_llm_port=8888 --lang= " en "อาร์กิวเมนต์คำสั่งแบบเต็ม:

options:

-h, --help show this help message and exit

--id ID ID of this conversation

--query QUERY User query

--history HISTORY History of conversation

--llm_name LLM_NAME the name of llm

--use_local_llm Whether to use local llm

--local_llm_host LOCAL_LLM_HOST

The host of local llm service

--local_llm_port LOCAL_LLM_PORT

The port of local llm service

--tool_names TOOL_NAMES

the name of llm

--max_iter_num MAX_ITER_NUM

the number of iteration of agents

--agent_name AGENT_NAME

The agent name

--agent_bio AGENT_BIO

The agent bio, a short description

--agent_instructions AGENT_INSTRUCTIONS

The instructions of how agent thinking, acting, or talking

--external_knowledge EXTERNAL_KNOWLEDGE

The link of external knowledge

--lang {en,zh} The language of the overall system

--max_tokens_num Maximum length of model input

บันทึก :

browse_website คุณจะต้องกำหนดค่า Chromedriver บนเซิร์ฟเวอร์ของคุณhttp_proxy การใช้งานเครื่องมือที่กำหนดเองสามารถพบได้ใน example/custom_tool_example.py

เราต้องการเพียงสองบรรทัดในการประเมินความสามารถของตัวแทน เช่น:

cd benchmark

python infer_qwen.py qwen_benchmark_res.jsonl

python benchmark_eval.py ./benchmark_eval.jsonl ./qwen_benchmark_res.jsonlคำสั่งดังกล่าวจะให้ผลลัพธ์ดังนี้

plan : 31.64, tooluse : 43.30, reflextion : 33.34, conclusion : 44.85, profile : 44.78, overall : 39.85

โปรดดูเกณฑ์มาตรฐาน/สำหรับรายละเอียดเพิ่มเติม

@article{pan2023kwaiagents,

author = {Haojie Pan and

Zepeng Zhai and

Hao Yuan and

Yaojia Lv and

Ruiji Fu and

Ming Liu and

Zhongyuan Wang and

Bing Qin

},

title = {KwaiAgents: Generalized Information-seeking Agent System with Large Language Models},

journal = {CoRR},

volume = {abs/2312.04889},

year = {2023}

}