In jüngster Zeit hat die Popularität von KI-Anwendungen für große Sprachmodelle (LLM) zu einem harten Wettbewerb im Hardwarebereich geführt. AMD hat seine neueste Strix Point APU-Serie auf den Markt gebracht und seine Ryzen AI-Prozessoren zeigen erhebliche Vorteile bei der Bewältigung von LLM-Aufgaben, wobei die Leistung die von Intels Lunar-Lake-Serie bei weitem übertrifft. Der Herausgeber von Downcodes vermittelt Ihnen einen detaillierten Einblick in die Leistung der Strix Point APU-Serie und die dahinter stehende technologische Innovation.

Kürzlich veröffentlichte AMD seine neueste Strix Point APU-Serie und unterstreicht damit die herausragende Leistung der Serie bei AI-Large-Language-Model-Anwendungen (LLM), die die Prozessoren der Lunar-Lake-Serie von Intel bei weitem übertrifft. Da die Nachfrage nach KI-Workloads weiter wächst, wird der Wettbewerb um Hardware immer härter. Als Reaktion auf den Markt brachte AMD KI-Prozessoren auf den Markt, die für mobile Plattformen entwickelt wurden und auf höhere Leistung und geringere Latenz abzielen.

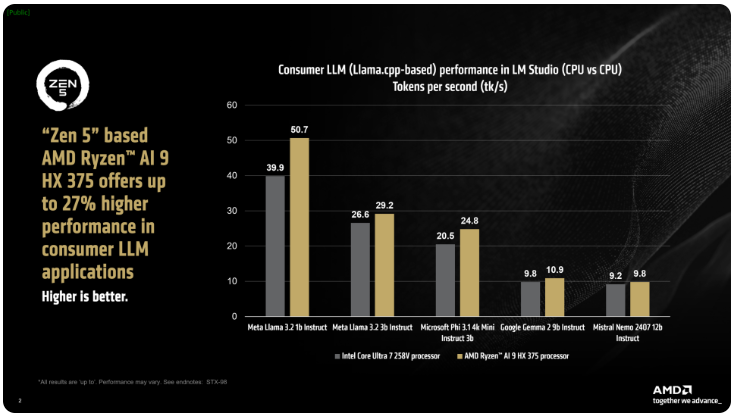

Laut AMD kann der Ryzen AI300-Prozessor der ix Point-Serie die Anzahl der pro Sekunde verarbeiteten Token bei der Verarbeitung von AI-LLM-Aufgaben deutlich steigern. Im Vergleich zu Intels Core Ultra258V hat sich die Leistung des Ryzen AI9375 um 27 % verbessert. Obwohl der Core Ultra7V nicht das schnellste Modell der L-Lake-Serie ist, liegen seine Kern- und Thread-Anzahl nahe an höherwertigen Lunar-Lake-Prozessoren, was die Wettbewerbsfähigkeit von AMD-Produkten in diesem Bereich zeigt.

Das LM Studio-Tool von AMD ist eine verbraucherorientierte Anwendung, die auf dem llama.cpp-Framework basiert und die Verwendung großer Sprachmodelle vereinfachen soll. Das Framework optimiert die Leistung von x86-CPUs. Obwohl für die Ausführung von LLM keine GPU erforderlich ist, kann die Verwendung einer GPU die Verarbeitung weiter beschleunigen. Dem Test zufolge kann Ryzen AI9HX375 im Meta Llama3.21b Instruct-Modell eine 35-mal geringere Latenz erreichen und 50,7 Token pro Sekunde verarbeiten. Im Vergleich dazu sind es beim Core Ultra7258V nur 39,9 Token.

Darüber hinaus ist die Strix Point APU mit einer leistungsstarken integrierten Radeon-Grafikkarte auf Basis der RDNA3.5-Architektur ausgestattet, die Aufgaben über die Ulkan-API auf die iGPU verlagern kann, um die Leistung von LLM weiter zu verbessern. Mithilfe der Variable Graphics Memory (VGM)-Technologie kann der Ryzen AI300-Prozessor die Speicherzuteilung optimieren, die Energieeffizienz verbessern und letztendlich eine Leistungssteigerung von bis zu 60 % erreichen.

In Vergleichstests verwendete AMD die gleichen Einstellungen auf der Intel AI Playground-Plattform und stellte fest, dass der Ryzen AI9HX375 87 % schneller als der Core Ultra7258V auf Microsoft Phi3.1 und 13 % schneller auf dem Mistral7b Instruct0.3-Modell war. Interessanter sind die Ergebnisse jedoch im Vergleich zum Core Ultra9288V, dem Flaggschiff der Lunar-Lake-Serie. Derzeit konzentriert sich AMD darauf, die Verwendung großer Sprachmodelle durch LM Studio populärer zu machen, um mehr technisch nicht versierten Benutzern den Einstieg zu erleichtern.

Die Einführung der AMD Strix Point APU-Serie markiert eine weitere Verschärfung des Wettbewerbs im Bereich der KI-Prozessoren und deutet zudem darauf hin, dass künftige KI-Anwendungen über eine leistungsfähigere Hardwareunterstützung verfügen werden. Seine Verbesserungen bei Leistung und Energieeffizienz werden den Benutzern ein reibungsloseres und leistungsfähigeres KI-Erlebnis bieten. Der Herausgeber von Downcodes wird die neuesten Entwicklungen in diesem Bereich weiterhin im Auge behalten und den Lesern weitere spannende Berichte bringen.