iFlytek hat ein großes multimodales interaktives Modell von iFlytek veröffentlicht und damit einen neuen Meilenstein auf dem Gebiet der künstlichen Intelligenz gesetzt. Dieses Modell durchbricht die Einschränkungen der Interaktion mit nur einer Stimme in der Vergangenheit und erreicht die nahtlose Integration von Sprache, visueller und digitaler menschlicher Interaktion und bietet Benutzern ein lebendigeres, realeres und komfortableres interaktives Erlebnis. Die Herausgeber von Downcodes vermitteln Ihnen ein detailliertes Verständnis der Funktionen und Vorteile dieses erstaunlichen multimodalen Interaktionsmodells und wie es die Art und Weise, wie wir mit künstlicher Intelligenz interagieren, verändern wird.

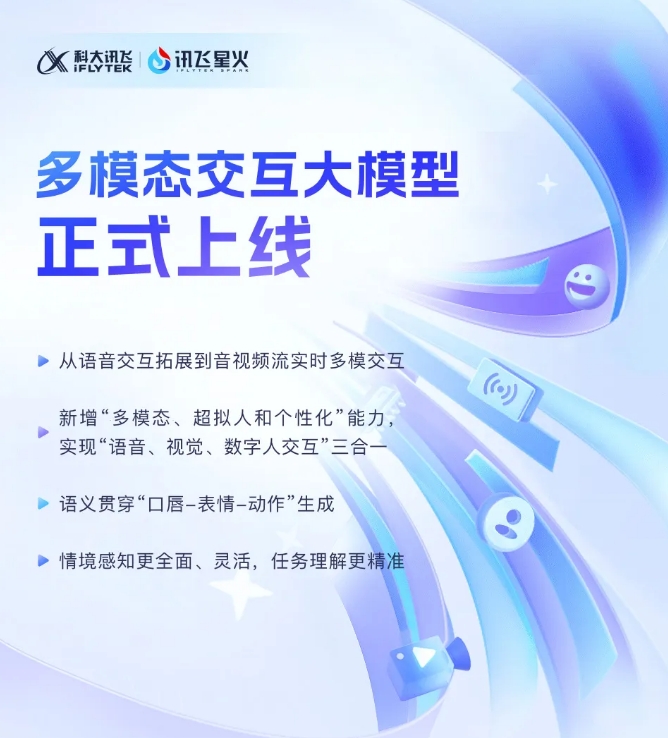

iFlytek gab kürzlich bekannt, dass sein neu entwickeltes multimodales interaktives Großmodell iFlytek Spark offiziell in Betrieb genommen wurde. Dieser technologische Durchbruch markiert die Erweiterung von iFlytek von einer einzigen Sprachinteraktionstechnologie zu einer neuen Stufe der multimodalen Interaktion von Audio- und Videostreams in Echtzeit. Das neue Modell integriert Sprach-, visuelle und digitale menschliche Interaktionsfunktionen, und Benutzer können diese drei mit einem Klick nahtlos integrieren.

Mit der Einführung des multimodalen interaktiven Modells von iFlytek wird erstmals eine superanthropomorphe digitale menschliche Technologie eingeführt. Diese Technologie kann die Bewegungen des Rumpfes und der Gliedmaßen des digitalen Menschen genau mit dem Sprachinhalt in Einklang bringen, schnell Ausdrücke und Bewegungen erzeugen und die Leistung erheblich verbessern Fähigkeiten der KI. Lebendigkeit und Realismus. Durch die Integration von Text, Sprache und Ausdrücken kann das neue Modell eine modalübergreifende semantische Konsistenz erreichen und den emotionalen Ausdruck realistischer und kohärenter machen.

Darüber hinaus unterstützt iFlytek Spark die superanthropomorphe ultraschnelle Interaktionstechnologie und nutzt ein einheitliches neuronales Netzwerk, um eine End-to-End-Modellierung von Stimme zu Stimme direkt zu realisieren, wodurch die Reaktion schneller und reibungsloser erfolgt. Diese Technologie kann emotionale Veränderungen genau wahrnehmen und den Rhythmus, die Größe und die Persönlichkeit des Klangs entsprechend den Anweisungen frei anpassen und so ein personalisierteres interaktives Erlebnis bieten.

Im Hinblick auf die multimodale visuelle Interaktion kann iFlytek Spark „die Welt verstehen“ und „alles erkennen“ und spezifische Hintergrundszenen, Logistikstatus und andere Informationen umfassend wahrnehmen, wodurch das Verständnis von Aufgaben genauer wird. Durch die Integration verschiedener Informationen wie Stimme, Gesten, Verhalten und Emotionen kann das Modell angemessene Antworten geben und Benutzern ein umfassenderes und genaueres interaktives Erlebnis bieten.

Multimodales interaktives Großmodell-SDK: https://www.xfyun.cn/solutions/Multimodel

Das Aufkommen des multimodalen interaktiven Großmodells iFlytek Spark zeigt, dass sich die Technologie der künstlichen Intelligenz in eine intelligentere und humanere Richtung entwickelt. Seine leistungsstarken Funktionen und die komfortable Bedienung werden den Benutzern mit Sicherheit ein neues interaktives Erlebnis und unbegrenzte Möglichkeiten für alle Lebensbereiche bieten. Wir freuen uns darauf, dass iFlytek Spark uns in Zukunft weitere Überraschungen beschert!