Der Herausgeber von Downcodes erfuhr, dass DeepSeek, eine Tochtergesellschaft des chinesischen Private-Equity-Riesen Magic Square Quantitative, kürzlich sein neuestes inferenzorientiertes, groß angelegtes Sprachmodell R1-Lite-Preview veröffentlicht hat. Dieses Modell ist derzeit nur über die Web-Chatbot-Plattform DeepSeek Chat für die Öffentlichkeit zugänglich, und seine Leistung hat große Aufmerksamkeit erregt und kommt sogar dem kürzlich von OpenAI veröffentlichten o1-Preview-Modell nahe oder übertrifft es sogar. DeepSeek ist für seine Beiträge zum Open-Source-KI-Ökosystem bekannt und dieser Start setzt sein Engagement für Zugänglichkeit und Transparenz fort.

DeepSeek, eine Tochtergesellschaft des chinesischen Private-Equity-Riesen Huifang Quantitative, hat kürzlich sein neuestes inferenzorientiertes, groß angelegtes Sprachmodell R1-Lite-Preview veröffentlicht. Das Modell ist der Öffentlichkeit derzeit nur über DeepSeek Chat, einer Web-Chatbot-Plattform, zugänglich.

DeepSeek ist für seine innovativen Beiträge zum Open-Source-KI-Ökosystem bekannt. Diese neue Version zielt darauf ab, der Öffentlichkeit hochrangige Inferenzfunktionen zur Verfügung zu stellen und gleichzeitig das Engagement für Zugänglichkeit und Transparenz aufrechtzuerhalten. Obwohl R1-Lite-Preview derzeit nur in Chat-Anwendungen verfügbar ist, hat es mit einer Leistung, die dem kürzlich veröffentlichten o1-Preview-Modell von OpenAI nahekommt oder es sogar übertrifft, große Aufmerksamkeit erregt.

R1-Lite-Preview nutzt die Argumentation „Kettendenken“, die die unterschiedlichen Denkprozesse aufzeigen kann, die es bei der Beantwortung von Benutzeranfragen durchläuft.

Obwohl einige Gedankenketten für Menschen unsinnig oder falsch erscheinen mögen, sind die Antworten von R1-Lite-Preview insgesamt sehr genau und können sogar die „Fallen“ lösen, auf die einige traditionelle leistungsstarke KI-Modelle wie GPT-4o und die Claude-Serie stoßen. Wie viele R gibt es beispielsweise im Wort „Erdbeere“? „Was ist größer, 9,11 oder 9,9?“

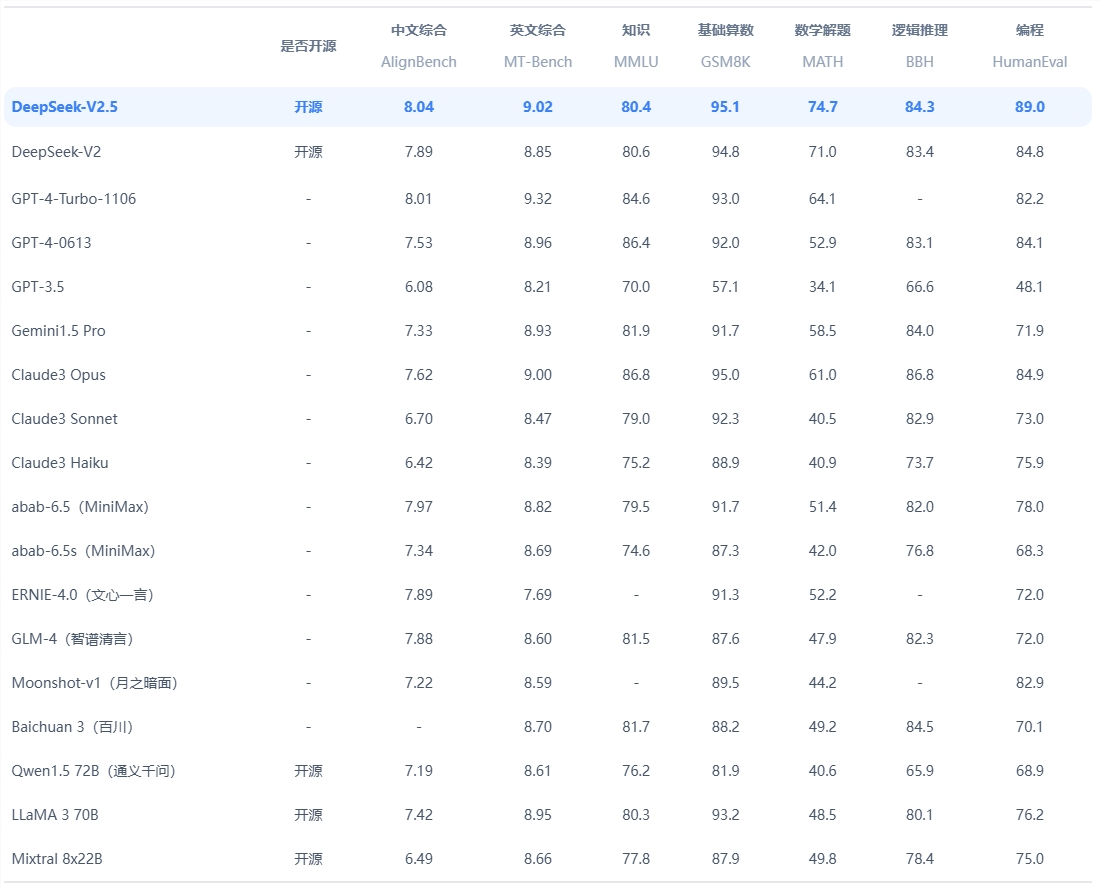

Laut DeepSeek zeichnet sich das Modell bei Aufgaben aus, die logisches Denken, mathematisches Denken und Problemlösung in Echtzeit erfordern. Seine Leistung übertrifft das Niveau von OpenAI o1-preview in etablierten Benchmarks wie AIME (American Invitational Mathematics Examination) und MATH.

Darüber hinaus veröffentlichte DeepSeek erweiterte Daten zum Modell, die eine stetige Verbesserung der Genauigkeit belegen, wenn dem Modell mehr Zeit oder „Denk-Tokens“ zur Lösung des Problems gegeben wird. Die Grafik verdeutlicht, dass sich die Punktzahl des Modells bei Benchmarks wie AIME mit zunehmender Denktiefe verbessert.

Die aktuelle Version von R1-Lite-Preview schneidet in wichtigen Benchmarks gut ab und ist in der Lage, eine Reihe von Aufgaben von komplexer Mathematik bis hin zu Logikszenarien zu bewältigen, wobei die Ergebnisse mit Top-Inferenzmodellen wie GPQA und Codeforces vergleichbar sind. Der transparente Argumentationsprozess des Modells ermöglicht es Benutzern, seine logischen Schritte in Echtzeit zu beobachten, was das Verantwortungsbewusstsein und die Glaubwürdigkeit des Systems stärkt.

Es ist erwähnenswert, dass DeepSeek weder den vollständigen Code für unabhängige Analysen oder Benchmarking durch Dritte veröffentlicht hat, noch eine API-Schnittstelle für unabhängige Tests bereitgestellt hat. Das Unternehmen hat noch keine relevanten Blog-Beiträge oder technischen Dokumente veröffentlicht, die das Training oder Testen beschreiben R1-Lite-Preview-Struktur, die den Ursprung dahinter immer noch voller Zweifel lässt.

R1-Lite-Preview ist derzeit kostenlos über DeepSeek Chat (chat.deepseek.com) verfügbar, der erweiterte „Deep Thought“-Modus ist jedoch auf 50 Nachrichten pro Tag beschränkt, sodass Benutzer seine leistungsstarken Funktionen erleben können. DeepSeek plant die Veröffentlichung von Open-Source-Versionen der Modelle der R1-Serie und zugehörigen APIs, um die Entwicklung der Open-Source-KI-Community weiter zu unterstützen.

DeepSeek treibt weiterhin Innovationen im Open-Source-KI-Bereich voran und die Veröffentlichung von R1-Lite-Preview fügt seiner Inferenz und Skalierbarkeit eine neue Dimension hinzu. Während Unternehmen und Forscher Anwendungen für inferenzintensive KI erforschen, wird DeepSeeks Engagement für Offenheit sicherstellen, dass seine Modelle zu einer wichtigen Ressource für Entwicklung und Innovation werden.

Offizieller Eingang: https://www.deepseek.com/

Alles in allem zeigt R1-Lite-Preview die starke Stärke von DeepSeek im Bereich groß angelegter Sprachmodelle, und auch der Open-Source-Plan ist eine Vorfreude wert. Die fehlende Offenlegung von Code und technischen Dokumenten wirft jedoch auch eine Ebene des Mysteriums über die technischen Details auf. Der Herausgeber von Downcodes wird den weiteren Fortschritt von DeepSeek weiterhin aufmerksam verfolgen.