Meta AI hat überraschenderweise ein grundlegendes multimodales Sprachmodell namens SPIRIT LM veröffentlicht, eine bahnbrechende Errungenschaft, die Text und Sprache frei mischen kann! Es basiert auf einem vorab trainierten Textsprachenmodell mit 7 Milliarden Parametern und erweitert sich durch kontinuierliches Training auf den Sprachmodus, wodurch ein dual-modales Verständnis und die Generierung von Text und Sprache realisiert werden und die beiden sogar gemischt werden können, was zu unerwarteten Anwendungseffekten führt. Der Herausgeber von Downcodes vermittelt Ihnen ein tiefgreifendes Verständnis der leistungsstarken Funktionen von SPIRIT LM und der dahinter stehenden technologischen Durchbrüche.

Meta AI hat kürzlich ein grundlegendes multimodales Sprachmodell namens SPIRIT LM als Open Source veröffentlicht, das Text und Sprache frei mischen kann und so neue Möglichkeiten für multimodale Aufgaben von Audio und Text eröffnet.

SPIRIT LM basiert auf einem vorab trainierten Textsprachmodell mit 7 Milliarden Parametern und erstreckt sich durch kontinuierliches Training an Text- und Spracheinheiten auf Sprachmodalitäten. Es kann Text wie ein großes Textmodell verstehen und generieren, und es kann sogar Text und Sprache miteinander mischen, um verschiedene magische Effekte zu erzeugen und Sprache in sie umzuwandeln Sie können es auch zur Sprachsynthese verwenden, um Text in Sprache umzuwandeln. Sie können es auch zur Sprachklassifizierung verwenden, um zu bestimmen, welche Emotionen eine Rede ausdrückt.

Noch wirkungsvoller ist, dass SPIRIT LM auch besonders gut im „emotionalen Ausdruck“ ist. Es kann eine Vielzahl unterschiedlicher Intonationen und Stile der Stimme erkennen und erzeugen, wodurch die Stimme der KI natürlicher und emotionaler klingt. Sie können sich vorstellen, dass die von SPIRIT LM erzeugte Stimme nicht mehr die kalte Maschinenstimme ist, sondern wie eine echte Person spricht, voller Freude, Wut, Trauer und Freude!

Um KI besser „emotional“ zu machen, haben Meta-Forscher außerdem speziell zwei Versionen von SPIRIT LM entwickelt:

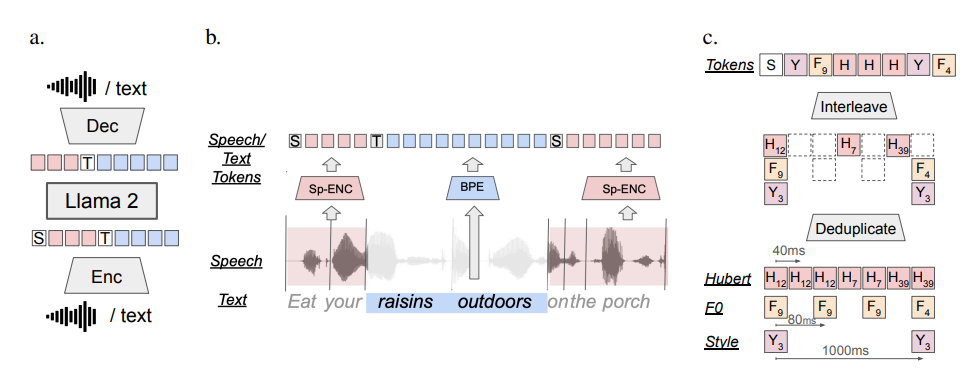

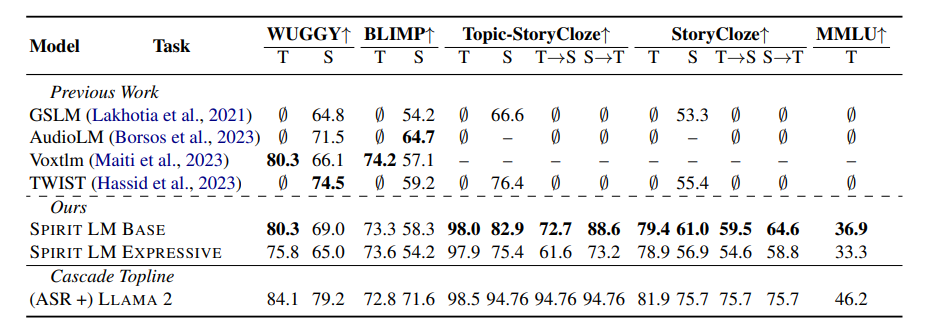

„Basic Edition“ (BASE): Diese Version konzentriert sich hauptsächlich auf die Phoneminformationen der Sprache, die die „Grundzusammensetzung“ der Sprache darstellen.

„Expressive Version“ (EXPRESSIVE): Zusätzlich zu Phoneminformationen fügt diese Version auch Ton- und Stilinformationen hinzu, wodurch die Stimme der KI lebendiger und ausdrucksvoller werden kann.

Wie macht SPIRIT LM das alles?

Einfach ausgedrückt wird SPIRIT LM auf der Grundlage von LLAMA2 trainiert, einem äußerst leistungsstarken Textmodell, das zuvor von Meta veröffentlicht wurde. Die Forscher „fütterten“ LLAMA2 mit einer großen Menge an Text- und Sprachdaten und führten eine spezielle „Interleaved-Training“-Methode ein, damit LLAMA2 gleichzeitig die Regeln von Text und Sprache erlernen kann.

Um die Fähigkeit von SPIRIT LM zum „emotionalen Ausdruck“ zu testen, haben Meta-Forscher außerdem einen neuen Test-Benchmark entwickelt – den „Speech-Text Sentiment Preservation Benchmark“ (STSP). Dieser Testbenchmark enthält eine Vielzahl von Sprach- und Textaufforderungen, die unterschiedliche Emotionen ausdrücken, um zu testen, ob das KI-Modell Sprache und Text mit entsprechenden Emotionen genau erkennen und generieren kann. Die Ergebnisse zeigen, dass die „Ausdrucksversion“ von SPIRIT LM bei der Emotionsspeicherung gut abschneidet und derzeit das erste KI-Modell ist, das emotionale Informationen über Modalitäten hinweg speichern kann!

Natürlich gaben die Meta-Forscher auch zu, dass es bei SPIRIT LM noch viele Verbesserungsmöglichkeiten gibt. Beispielsweise unterstützt SPIRIT LM derzeit nur Englisch und muss in Zukunft auf andere Sprachen ausgeweitet werden. Der Modellmaßstab von SPIRIT LM ist nicht groß genug und es ist notwendig, den Modellmaßstab weiter zu erweitern und die Modellleistung zu verbessern die Zukunft.

SPIRIT LM ist Metas großer Durchbruch auf dem Gebiet der KI. Es öffnet uns die Tür zur „klingenden und emotionalen“ KI-Welt. Ich glaube, dass wir in naher Zukunft weitere interessante Anwendungen sehen werden, die auf SPIRIT LM basieren, sodass KI nicht nur eloquent sprechen, sondern auch Emotionen wie echte Menschen ausdrücken und natürlicher und herzlicher mit uns kommunizieren kann!

Projektadresse: https://speechbot.github.io/spiritlm/

Papieradresse: https://arxiv.org/pdf/2402.05755

Alles in allem hat die Open Source von SPIRIT LM aufregende Fortschritte im Bereich der multimodalen KI gebracht. Ihr Aufkommen lässt darauf schließen, dass die KI auch in Zukunft größere Durchbrüche bei der Sprachinteraktion und dem emotionalen Ausdruck erzielen wird Aufmerksamkeit für diesen Bereich. Bitte bleiben Sie auf dem Laufenden!