Der Herausgeber von Downcodes erfuhr, dass das Allen Institute for Artificial Intelligence (Ai2) kürzlich Molmo veröffentlicht hat, eine neue multimodale Open-Source-KI-Modellfamilie. Ihre Leistung ist erstaunlich und übertrifft in mehreren Benchmark-Tests von Drittanbietern sogar die von OpenAI . Claude3.5Sonnet und Googles Gemini1.5. Molmo analysiert nicht nur von Benutzern hochgeladene Bilder, sondern verbraucht dank seiner einzigartigen Trainingstechniken beim Training auch 1.000 Mal weniger Daten als seine Konkurrenten. Dieser Durchbruch zeigt das Engagement von Ai2 für offene Forschung und stellt Hochleistungsmodelle sowie offene Gewichte und Daten der breiteren Gemeinschaft und Unternehmen zur Verfügung.

Molmo akzeptiert nicht nur von Benutzern hochgeladene Bilder zur Analyse, sondern verwendet dank seiner einzigartigen Trainingstechniken auch „1.000-mal weniger Daten als die Konkurrenz“ für das Training.

Diese Veröffentlichung zeigt das Engagement von Ai2 für offene Forschung und stellt leistungsstarke Modelle mit offenen Gewichten und Daten zur Nutzung durch die breitere Community und Unternehmen bereit. Die Molmo-Familie umfasst vier Hauptmodelle, nämlich Molmo-72B, Molmo-7B-D, Molmo-7B-O und Molmo-72B. Das Flaggschiffmodell ist mit 7,2 Milliarden Parametern besonders herausragend.

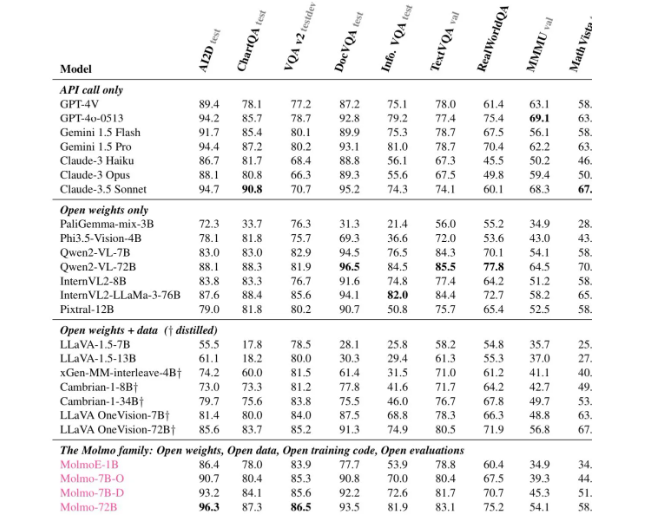

Laut verschiedenen Auswertungen erhielt Molmo-72B Spitzenwerte bei 11 wichtigen Benchmarks und belegte in Bezug auf die Benutzerpräferenz nur den zweiten Platz hinter -4o. Ai2 führte außerdem ein OLMoE-Modell ein, bei dem ein „Kombinationsansatz kleiner Modelle“ zur Verbesserung der Kosteneffizienz zum Einsatz kommt.

Die Architektur von Molmo wurde sorgfältig auf Effizienz und überlegene Leistung ausgelegt. Alle Modelle verwenden das CLIP-Modell ViT-L/14336px von OpenAI als visuellen Encoder, um mehrskalige Bilder in visuelle Befehle zu verarbeiten. Der Teil des Sprachmodells ist der Decoder Transformer, der unterschiedliche Kapazitäten und Offenheit aufweist.

Was das Training angeht, durchläuft Mol zwei Trainingsphasen: erstens das Vortraining mit mehreren Modellen und zweitens die überwachte Feinabstimmung. Im Gegensatz zu vielen modernen Modellen verlässt sich Molmo nicht auf verstärkendes Lernen mit menschlichem Feedback, sondern aktualisiert die Modellparameter durch einen sorgfältig abgestimmten Trainingsprozess.

Molmo schnitt in mehreren Benchmarks gut ab, insbesondere bei komplexen Aufgaben wie dem Lesen von Dokumenten und dem visuellen Denken, und stellte seine starken Fähigkeiten unter Beweis. Ai2 hat diese Modelle und Datensätze auf Hugging Face veröffentlicht und wird in den kommenden Monaten weitere Modelle und erweiterte technische Berichte veröffentlichen, um den Forschern mehr Ressourcen zur Verfügung zu stellen.

Wenn Sie mehr über die Fähigkeiten von Molmo erfahren möchten, sind jetzt öffentliche Demonstrationen auf der offiziellen Website von Molmo verfügbar (https://molmo.allenai.org/).

Highlight:

Das Open-Source-Modell für modale KI von Ai2Molmo übertrifft die Spitzenprodukte der Branche.

? Mol-72B schneidet in mehreren Benchmarks gut ab, nur nach GPT4o.

Es ist sehr offen und Modelle und Datensätze können von Forschern frei verwendet werden.

Alles in allem stellt die Entstehung von Molmo einen großen Fortschritt auf dem Gebiet der multimodalen KI dar, und sein Open-Source-Charakter stellt darüber hinaus wertvolle Ressourcen für Forscher auf der ganzen Welt bereit. Der Herausgeber von Downcodes hofft, dass Molmo in Zukunft weiter verbreitet und weiterentwickelt wird und den kontinuierlichen Fortschritt der KI-Technologie fördert.