Der Herausgeber von Downcodes erfuhr, dass Apple-Forscher einen neuen Benchmark-Test namens GSM-Symbolic für die mathematischen Denkfähigkeiten großer Sprachmodelle (LLM) gestartet haben. Dieser Test basiert auf GSM8K und soll die Argumentationsfähigkeiten von LLM umfassender bewerten, anstatt sich ausschließlich auf den probabilistischen Mustervergleich zu verlassen. Obwohl GSM8K beliebt ist, weist es Probleme wie Datenverschmutzung und Leistungsschwankungen auf. GSM-Symbolic überwindet diese Mängel, indem es vielfältige mathematische Probleme aus symbolischen Vorlagen generiert und so eine genauere Auswertung gewährleistet.

Kürzlich führten Apple-Forscher eine eingehende Untersuchung der mathematischen Denkfähigkeiten großer Sprachmodelle (LLM) durch und führten einen neuen Benchmark namens GSM-Symbolic ein.

Dieser neue Benchmark wurde auf Basis von GSM8K entwickelt, der hauptsächlich zur Bewertung grundlegender Mathematikfähigkeiten verwendet wird. Obwohl sich die Leistung vieler LLMs gegenüber GSM8K verbessert hat, hat die wissenschaftliche Gemeinschaft immer noch Fragen zu den Argumentationsfähigkeiten dieser Modelle und ist der Ansicht, dass die vorhandenen Bewertungsmetriken ihre wahren Fähigkeiten möglicherweise nicht vollständig widerspiegeln. Untersuchungen haben ergeben, dass LLMs häufig eher auf probabilistischem Mustervergleich als auf echtem logischen Denken basieren, wodurch sie sehr empfindlich auf kleine Änderungen in der Eingabe reagieren.

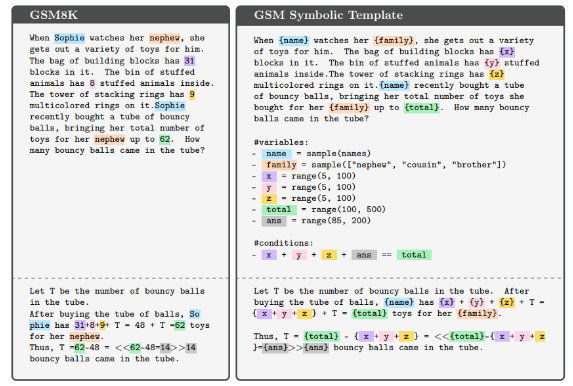

In der neuen Studie verwendeten die Forscher symbolische Vorlagen, um verschiedene mathematische Probleme zu generieren, die zuverlässigere Bewertungen ermöglichen. Experimentelle Ergebnisse zeigen, dass die Leistung von LLM deutlich abnimmt, wenn der numerische Wert oder die Komplexität des Problems zunimmt. Darüber hinaus kann selbst das Hinzufügen von Informationen, die oberflächlich für das Problem relevant, aber nicht wirklich irrelevant sind, zu einer Verschlechterung der Modellleistung um bis zu 65 % führen. Diese Ergebnisse bestätigen einmal mehr, dass LLM beim Denken mehr auf Mustervergleich als auf formal-logisches Denken setzt.

Der GSM8K-Datensatz enthält mehr als 8.000 Mathematikaufgaben auf Klassenebene und seine Beliebtheit birgt mehrere Risiken, wie z. B. Datenkontamination und Leistungsschwankungen aufgrund kleiner Problemänderungen. Um diese Herausforderungen zu bewältigen, ermöglicht die Einführung von GSM-Symbolic die wirksame Beherrschung der Vielfalt der Probleme. Dieser Benchmark bewertet mehr als 20 offene und geschlossene Modelle anhand von 5.000 Stichproben aus 100 Vorlagen und demonstriert die Erkenntnisse und Grenzen der mathematischen Argumentationsfähigkeiten von LLM.

Vorläufige Experimente zeigen, dass die Leistung verschiedener Modelle bei GSM-Symbolic erheblich variiert und die Gesamtgenauigkeit geringer ist als die gemeldete Leistung bei GSM8K. Die Studie untersuchte außerdem die Auswirkungen sich ändernder Variablennamen und -werte auf LLM und die Ergebnisse zeigten, dass Werteänderungen einen größeren Einfluss auf die Leistung hatten. Darüber hinaus wirkt sich die Komplexität des Problems auch direkt auf die Genauigkeit aus, wobei komplexe Probleme zu erheblichen Leistungseinbußen führen. Diese Ergebnisse deuten darauf hin, dass das Modell bei der Bearbeitung mathematischer Probleme möglicherweise mehr auf Mustervergleich als auf echtem logischen Denken beruht.

Diese Studie verdeutlicht die Grenzen aktueller GSM8K-Bewertungen und stellt einen neuen Benchmark, GSM-Symbolic, vor, der die mathematischen Denkfähigkeiten von LLMs bewerten soll. Insgesamt deuten die Ergebnisse darauf hin, dass LLMs ihre logischen Denkfähigkeiten bei der Bewältigung komplexer Probleme noch weiter verbessern müssen.

Papier: https://arxiv.org/abs/2410.05229

Alles in allem bietet der von Apple vorgeschlagene GSM-Symbolic-Benchmark eine neue Perspektive für die Bewertung der mathematischen Argumentationsfähigkeiten großer Sprachmodelle. Er zeigt auch, dass LLM noch Raum für Verbesserungen beim logischen Denken bietet, was den Weg für zukünftige Modellverbesserungen weist. Wir freuen uns auf weitere Forschung in der Zukunft, um die Entwicklung der Argumentationsfähigkeiten von LLM weiter voranzutreiben.