Kürzlich machte der Herausgeber von Downcodes auf eine besorgniserregende Nachricht aufmerksam: Es wurde festgestellt, dass das in der medizinischen Industrie weit verbreitete KI-Transkriptionstool, das auf der Whisper-Technologie von OpenAI basiert, „Halluzinationen“ aufweist und möglicherweise falsche Inhalte generiert. Dies hat Bedenken hinsichtlich der Sicherheit und Zuverlässigkeit der KI-Technologie im medizinischen Bereich geweckt. In diesem Artikel wird dieser Vorfall im Detail analysiert, seine potenziellen Risiken und die Reaktion von OpenAI untersucht.

In letzter Zeit hat ein KI-Transkriptionstool, das auf der Whisper-Technologie von OpenAI basiert, in der medizinischen Industrie an Popularität gewonnen. Viele Ärzte und Gesundheitsorganisationen nutzen dieses Tool, um Patientenkontakte aufzuzeichnen und zusammenzufassen.

Einem Bericht von ABC News zufolge stellten Forscher fest, dass dieses Tool in einigen Fällen „Halluzinationen“ hervorrufen und manchmal sogar Inhalte vollständig fabrizieren kann.

Das von einem Unternehmen namens Nabla entwickelte Transkriptionstool hat mehr als 7 Millionen medizinische Gespräche erfolgreich transkribiert und wird derzeit von mehr als 30.000 Ärzten und 40 Gesundheitssystemen verwendet. Dennoch ist sich Nabla der Möglichkeit einer Halluzination bei Whisper bewusst und sagt, man arbeite daran, das Problem anzugehen.

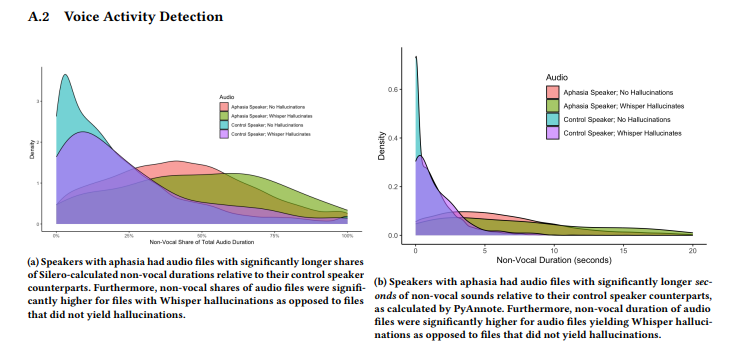

Eine von einem Forscherteam der Cornell University, der University of Washington und anderen durchgeführte Studie ergab, dass Whisper in etwa 1 % seiner Transkriptionen halluzinierte. In diesen Fällen generiert das Tool in den stillen Phasen der Aufnahme nach dem Zufallsprinzip bedeutungslose Phrasen, die manchmal heftige Emotionen zum Ausdruck bringen. Die Forscher sammelten Audioproben der AphasiaBank von TalkBank und stellten fest, dass Stille besonders häufig vorkommt, wenn Menschen mit Sprachstörungen sprechen.

Die Forscherin der Cornell University, Allison Koenecke, teilte in den sozialen Medien einige Beispiele, die den von Whisper erzeugten halluzinatorischen Inhalt zeigen. Die Forscher fanden heraus, dass die vom Tool generierten Inhalte auch erfundene medizinische Begriffe und sogar Sätze wie „Danke fürs Zuschauen!“ enthielten, die wie Wörter aus YouTube-Videos klangen.

Die Forschung wurde im Juni auf der FAccT-Konferenz der Association for Computing Machinery in Brasilien vorgestellt, es ist jedoch unklar, ob sie einem Peer-Review unterzogen wurde. Zu diesem Thema sagte OpenAI-Sprecherin Taya Christianson in einem Interview mit „The Verge“, dass sie dieses Problem sehr ernst nehmen und weiterhin hart daran arbeiten werden, es zu verbessern, insbesondere an der Reduzierung von Halluzinationen. Gleichzeitig erwähnte sie, dass es bei der Verwendung von Whisper auf ihrer API-Plattform klare Nutzungsrichtlinien gibt, die die Verwendung des Tools in bestimmten Entscheidungsumgebungen mit hohem Risiko verbieten.

Highlight:

Das Whisper-Transkriptionstool ist in der medizinischen Industrie weit verbreitet und hat 7 Millionen medizinische Gespräche aufgezeichnet.

⚠️ Untersuchungen haben ergeben, dass Whisper bei etwa 1 % der Transkriptionen „halluziniert“ und manchmal bedeutungslose Inhalte erzeugt.

OpenAI sagt, dass es daran arbeitet, die Leistung des Tools zu verbessern, insbesondere bei der Reduzierung von Halluzinationen.

Alles in allem hat die KI-Technologie breite Anwendungsperspektiven im medizinischen Bereich, steht aber auch vor vielen Herausforderungen. Das Auftreten des „Halluzinations“-Phänomens von Whisper erinnert uns daran, dass wir die KI-Technologie mit Vorsicht behandeln und ihre Sicherheit und Zuverlässigkeit stärker überwachen müssen, um ihre sichere und wirksame Anwendung im medizinischen Bereich zu gewährleisten und die Rechte und Sicherheit der Patienten zu schützen. Der Herausgeber von Downcodes wird die weitere Entwicklung dieses Vorfalls weiterhin aufmerksam verfolgen.