Der „Black-Box“-Charakter großer Sprachmodelle (LLM) war schon immer ein wichtiges Thema im Bereich der künstlichen Intelligenz. Die Uninterpretierbarkeit der Modellausgabeergebnisse macht es schwierig, ihre Zuverlässigkeit und Glaubwürdigkeit zu gewährleisten. Um dieses Problem zu lösen, hat OpenAI eine neue Technologie namens Prover-Verifier Games (PVG) auf den Markt gebracht, die darauf abzielt, die Interpretierbarkeit und Überprüfbarkeit der LLM-Ausgabe zu verbessern. Der Herausgeber von Downcodes erklärt Ihnen diese Technologie ausführlich.

OpenAI hat kürzlich eine neue Technologie namens Prover-Verifier Games (PVG) veröffentlicht, die darauf abzielt, das „Black-Box“-Problem der Modellausgabe künstlicher Intelligenz zu lösen.

Stellen Sie sich vor, Sie haben einen superintelligenten Assistenten, dessen Denkprozess jedoch wie eine Blackbox ist und Sie keine Ahnung haben, wie er zu seinen Schlussfolgerungen gelangt. Klingt das etwas beunruhigend? Ja, das ist das Problem, mit dem derzeit viele große Sprachmodelle (LLM) konfrontiert sind. Obwohl sie leistungsstark sind, lässt sich die Genauigkeit der von ihnen generierten Inhalte nur schwer überprüfen.

Papier-URL: https://cdn.openai.com/prover-verifier-games-improve-legibility-of-llm-outputs/legibility.pdf

Um dieses Problem zu lösen, hat OpenAI die PVG-Technologie eingeführt. Einfach ausgedrückt geht es darum, kleine Modelle (wie GPT-3) die Ausgabe großer Modelle (wie GPT-4) überwachen zu lassen. Es ist, als würde man ein Spiel spielen. Der Prüfer ist für die Generierung von Inhalten verantwortlich, und der Verifizierer ist dafür verantwortlich, festzustellen, ob der Inhalt korrekt ist. Klingt interessant?

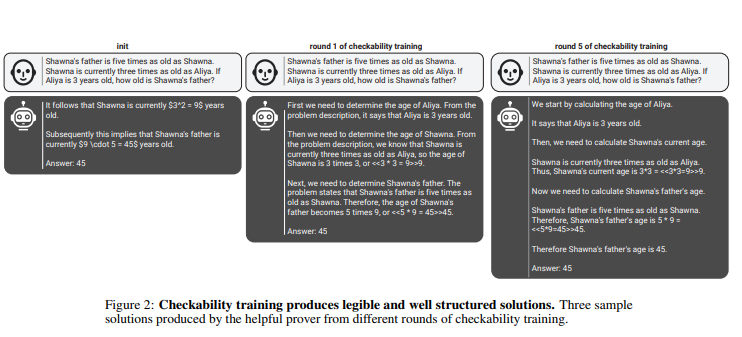

Nach dieser Regel verbessern Prüfer und Prüfer ihre Fähigkeiten kontinuierlich durch mehrere iterative Trainingsrunden. Prüfer nutzen überwachtes Lernen, um die Richtigkeit von Inhalten vorherzusagen, während Prüfer verstärkendes Lernen nutzen, um die von ihnen generierten Inhalte zu optimieren. Noch interessanter ist, dass es zwei Arten von Prüfern gibt: nützliche Prüfer und listige Prüfer. Nützliche Prüfer streben danach, korrekte und überzeugende Inhalte zu generieren, während geschickte Prüfer versuchen, Inhalte zu generieren, die falsch, aber gleichermaßen überzeugend sind, und stellen so das Urteil des Prüfers in Frage.

penAI betont, dass zum Trainieren eines effektiven Prüfmodells eine große Menge realer und genauer Etikettendaten erforderlich ist, um dessen Erkennungsfähigkeiten zu verbessern. Andernfalls besteht selbst bei Verwendung der PVG-Technologie das Risiko einer illegalen Ausgabe des überprüften Inhalts.

Highlight:

?Die PVG-Technologie löst das KI-„Blackbox“-Problem, indem sie die Ausgabe großer Modelle mit kleinen Modellen verifiziert.

?Das Trainings-Framework basiert auf der Spieltheorie und simuliert die Interaktion zwischen dem Prüfer und dem Verifizierer, wodurch die Genauigkeit und Kontrollierbarkeit der Modellausgabe verbessert wird.

? Um das Verifizierermodell zu trainieren, ist eine große Menge realer Daten erforderlich, um sicherzustellen, dass es über ausreichende Urteilskraft und Robustheit verfügt.

Alles in allem bietet die PVG-Technologie von OpenAI eine neue Idee zur Lösung des „Black-Box“-Problems künstlicher Intelligenzmodelle, ihre Wirksamkeit hängt jedoch immer noch von hochwertigen Trainingsdaten ab. Es lohnt sich, auf die zukünftige Entwicklung dieser Technologie zu blicken, da sie die Entwicklung von Modellen der künstlichen Intelligenz in eine zuverlässigere, erklärbarere und vertrauenswürdigere Richtung vorantreiben wird. Der Herausgeber von Downcodes freut sich darauf, weitere ähnliche innovative Technologien zu sehen.