Die Bild-zu-Video-Generierungstechnologie (I2V) entwickelt sich rasant weiter mit dem Ziel, realistischere und kontrollierte Videos zu erstellen. Der Herausgeber von Downcodes wird heute ein neues Framework namens Motion-I2V vorstellen, das durch explizite Bewegungsmodellierung einen bedeutenden Durchbruch im Bereich der I2V-Erzeugung erzielt hat. Dieses von Forschern wie Xiaoyu Shi und Zhaoyang Huang entwickelte Framework ist insofern innovativ, als es den Bild-zu-Video-Konvertierungsprozess in zwei Phasen zerlegt und Bewegungsfeldvorhersage- und Bewegungsverbesserungs-Timing-Ebenen geschickt kombiniert, um eine höhere Qualität, Konsistenz und Zuverlässigkeit zu erzielen steuerbare Videogenerierung.

Mit der rasanten Entwicklung der Technologie der künstlichen Intelligenz ist die Bild-zu-Video-Generierungstechnologie (I2V) zu einem heißen Forschungsthema geworden. Kürzlich stellte ein Team bestehend aus Forschern wie Xiaoyu Shi und Zhaoyang Huang ein neues Framework namens Motion-I2V vor, das durch explizite Bewegungsmodellierung eine konsistentere und kontrollierbarere Bild-zu-Video-Generierung erreicht. Dieser technologische Durchbruch verbessert nicht nur die Qualität und Konsistenz der Videoerzeugung, sondern bietet Benutzern auch ein beispielloses Steuerungserlebnis.

Im Bereich der Bild-zu-Video-Generierung war es schon immer ein technisches Problem, die Kohärenz und Kontrollierbarkeit der generierten Videos aufrechtzuerhalten. Herkömmliche I2V-Methoden erlernen direkt die komplexe Zuordnung von Bildern zu Videos, während das Motion-I2V-Framework diesen Prozess auf innovative Weise in zwei Phasen zerlegt und in beiden Phasen eine explizite Bewegungsmodellierung einführt.

In der ersten Phase schlägt Motion-I2V einen diffusionsbasierten Bewegungsfeldprädiktor vor, der sich auf die Ableitung der Trajektorien von Referenzbildpixeln konzentriert. Der Schlüssel zu dieser Phase besteht darin, die Bewegungsfeldkarte zwischen dem Referenzbild und allen zukünftigen Bildern anhand der Referenzbild- und Texthinweise vorherzusagen. Die zweite Stufe ist für die Weitergabe des Inhalts des Referenzbilds an den zusammengesetzten Frame verantwortlich. Durch die Einführung einer neuartigen bewegungsergänzten zeitlichen Schicht wird die eindimensionale zeitliche Aufmerksamkeit verbessert, das zeitliche Rezeptionsfeld erweitert und die Komplexität des direkten Lernens komplexer räumlich-zeitlicher Muster verringert.

Im Vergleich zu bestehenden Methoden zeigt Motion-I2V klare Vorteile. Ob in Szenarien wie „ein sich schnell bewegender Panzer“, „ein blauer BMW, der schnell fährt“, „drei klare Eiswürfel“ oder eine „kriechende Schnecke“, Motion-I2V erzeugt konsistentere Videos, selbst in hoher Qualität bleibt auch bei einer Vielzahl von Bewegungs- und Betrachtungswinkeländerungen erhalten.

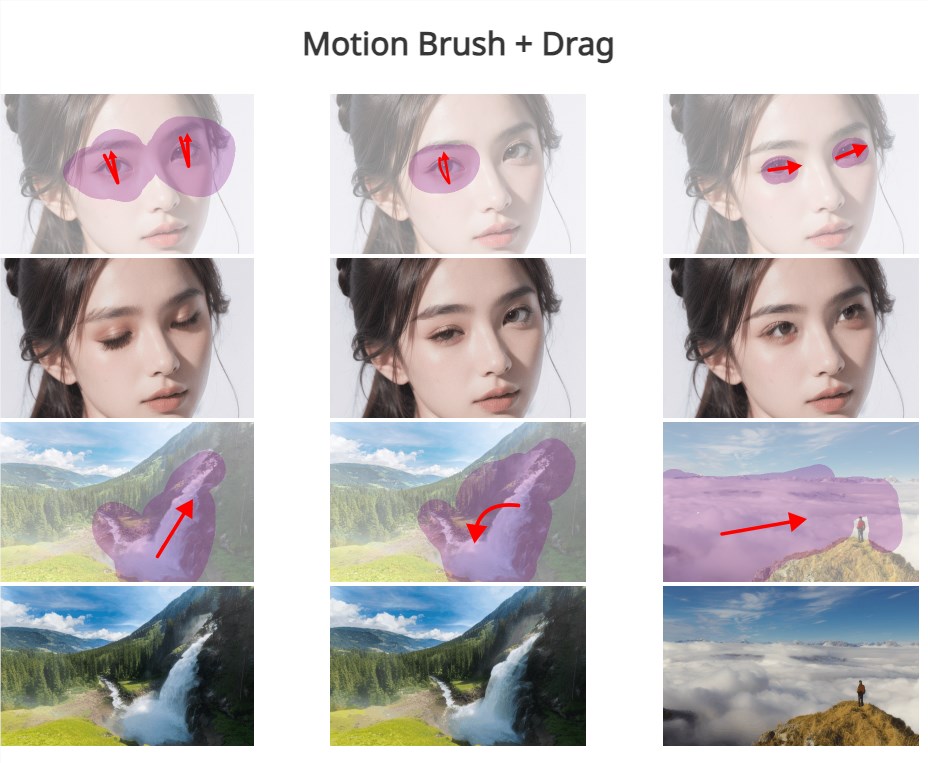

Darüber hinaus unterstützt Motion-I2V Benutzer bei der präzisen Steuerung von Bewegungstrajektorien und Bewegungsbereichen durch spärliche Trajektorien und Bereichsanmerkungen und bietet so mehr Steuerungsmöglichkeiten, als sich ausschließlich auf Textanweisungen zu verlassen. Dies verbessert nicht nur das interaktive Erlebnis des Benutzers, sondern bietet auch die Möglichkeit zur Anpassung und Personalisierung der Videogenerierung.

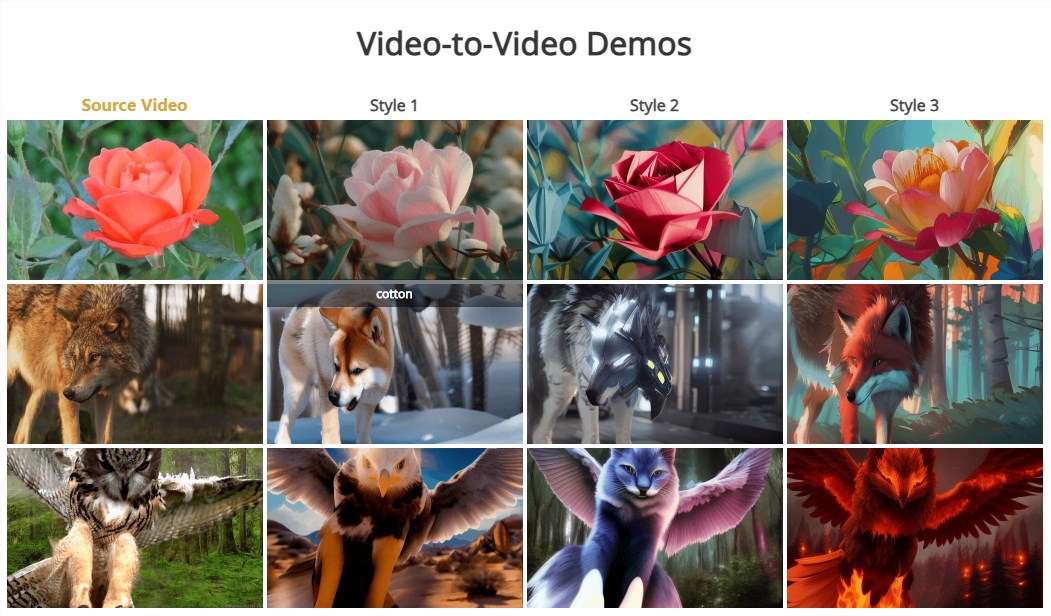

Es ist erwähnenswert, dass die zweite Stufe von Motion-I2V natürlich auch die Zero-Sample-Video-zu-Video-Konvertierung unterstützt, was bedeutet, dass die Videokonvertierung verschiedener Stile oder Inhalte ohne Trainingsbeispiele erreicht werden kann.

Die Einführung des Motion-I2V-Frameworks markiert eine neue Stufe in der Bild-zu-Video-Generierungstechnologie. Es erzielt nicht nur deutliche Verbesserungen bei Qualität und Konsistenz, sondern zeigt auch großes Potenzial bei der Benutzersteuerung und Personalisierung. Da die Technologie immer weiter ausgereift und verbessert wird, haben wir Grund zu der Annahme, dass Motion-I2V eine wichtige Rolle in der Film- und Fernsehproduktion, der virtuellen Realität, der Spieleentwicklung und anderen Bereichen spielen und den Menschen ein reichhaltigeres und lebendigeres visuelles Erlebnis bieten wird.

Dokumentadresse: https://xiaoyushi97.github.io/Motion-I2V/

Github-Adresse: https://github.com/GUN/Motion-I2V

Das Aufkommen des Motion-I2V-Frameworks hat der I2V-Technologie neue Möglichkeiten eröffnet, und seine Verbesserungen in der Qualität, Konsistenz und Benutzerkontrolle der Videoerzeugung sind es wert, gespannt zu sein. Ich glaube, dass Motion-I2V mit der Weiterentwicklung der Technologie in Zukunft in mehr Bereichen eingesetzt werden und uns ein aufregenderes visuelles Erlebnis bescheren wird. Freuen Sie sich auf weitere innovative Anwendungen, die auf diesem Framework basieren.