In letzter Zeit hat die Benutzererfahrung des KI-Chatbots Claude von Anthropic für hitzige Diskussionen gesorgt. Auf Reddit gab es zahlreiche Rückmeldungen von Benutzern, die besagten, dass Claudes Leistung nachgelassen habe, was sich insbesondere in Gedächtnisverlust und nachlassenden Programmierfähigkeiten bemerkbar machte. Dieser Vorfall löste weitreichende Diskussionen über Leistungsbewertung und Benutzererfahrung großer Sprachmodelle aus und verdeutlichte einmal mehr die Herausforderungen, denen sich KI-Unternehmen bei der Aufrechterhaltung der Modellstabilität gegenübersehen.

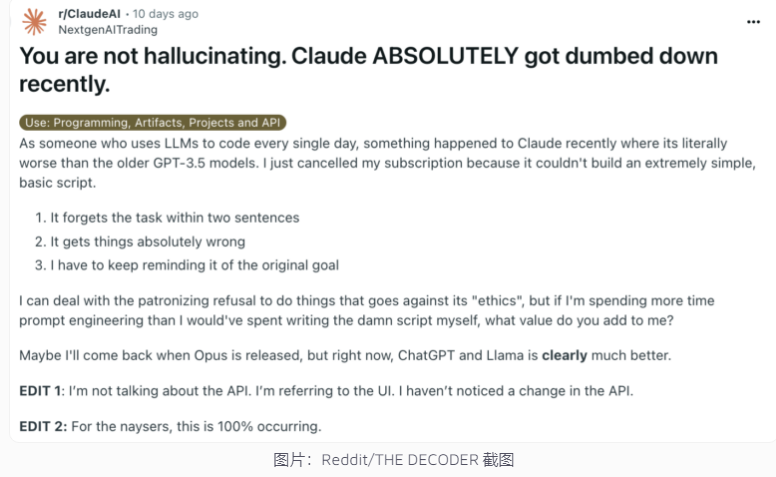

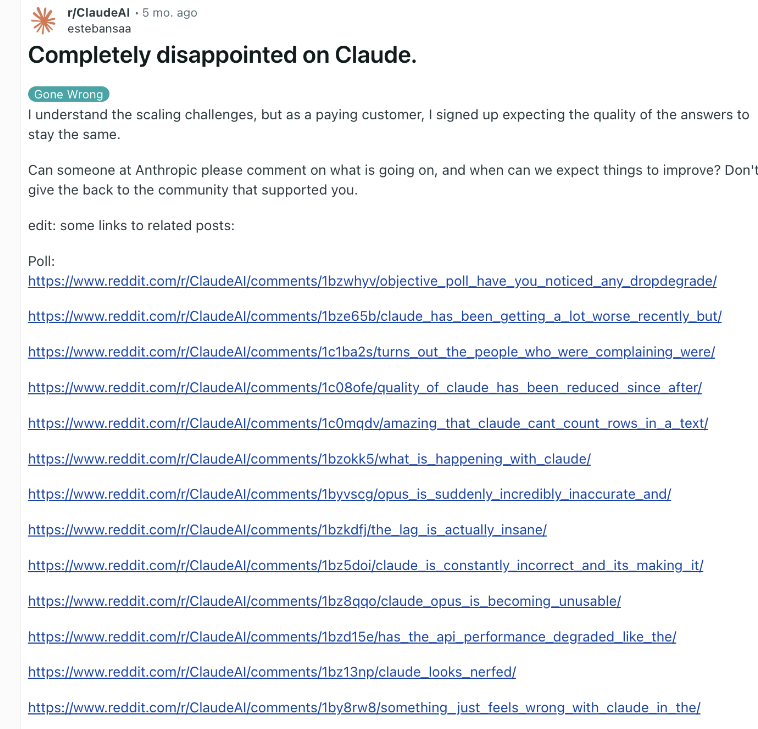

Kürzlich war der KI-Chatbot Claude von Anthropic erneut in eine Leistungskontroverse verwickelt. Ein Beitrag auf Reddit, in dem behauptet wurde, Claude sei viel dümmer geworden, erregte kürzlich große Aufmerksamkeit. Viele Benutzer berichteten, dass sie einen Rückgang von Claudes Fähigkeiten erlebt hätten, einschließlich Gedächtnisverlust und einer Verschlechterung der Programmierfähigkeiten.

Als Reaktion darauf antwortete Alex Albert, Geschäftsführer von Anthropic, dass die Untersuchung des Unternehmens keine allgemeinen Probleme festgestellt habe und bestätigte, dass keine Änderungen am Claude3.5Sonnet-Modell oder der Inferenzpipeline vorgenommen wurden. Um die Transparenz zu verbessern, hat Anthropic die Systemaufforderungen des Claude-Modells auf seiner offiziellen Website veröffentlicht.

Dies ist nicht das erste Mal, dass Benutzer eine Verschlechterung der KI melden, das Unternehmen hat dies jedoch dementiert. Ende 2023 sah sich auch ChatGPT von OpenAI mit ähnlichen Zweifeln konfrontiert. Laut Brancheninsidern können die Gründe für dieses Phänomen sein: mit der Zeit steigende Benutzererwartungen, natürliche Veränderungen in der KI-Ausgabe, vorübergehende Einschränkungen der Rechenressourcen usw.

Diese Faktoren können jedoch auch dann zu einer vom Benutzer wahrgenommenen Leistungsverschlechterung führen, selbst wenn das zugrunde liegende Modell keinen wesentlichen Änderungen unterliegt. OpenAI hat einmal darauf hingewiesen, dass das KI-Verhalten selbst unvorhersehbar ist und die Aufrechterhaltung und Bewertung der generativen KI-Leistung im großen Maßstab eine große Herausforderung darstellt.

Anthropic sagte, man werde weiterhin auf das Feedback der Benutzer achten und hart daran arbeiten, die Leistungsstabilität von Claude zu verbessern. Der Vorfall verdeutlicht die Herausforderungen, vor denen KI-Unternehmen bei der Aufrechterhaltung der Modellkonsistenz stehen, sowie die Bedeutung einer erhöhten Transparenz bei der Bewertung und Kommunikation der KI-Leistung.

Die Kontroverse um die Leistung von Claude spiegelt die Komplexität der Entwicklung und Bereitstellung großer Sprachmodelle sowie die Kluft zwischen Benutzererwartungen und tatsächlichen Anwendungen wider. Künftig müssen KI-Unternehmen die Modellstabilität weiter verbessern und eine effektivere Kommunikation mit den Benutzern aufrechterhalten, um sicherzustellen, dass die KI-Technologie den Benutzern weiterhin zuverlässig Dienste bereitstellen kann.