Die Anthropic API führt eine lang erwartete neue Funktion ein – Hinweis-Caching, die die Effizienz und Wirtschaftlichkeit von Claude-Modellen erheblich verbessern wird. Mit dieser Funktion können Entwickler häufig verwendete Kontextinformationen zwischen API-Aufrufen zwischenspeichern und so redundante Berechnungen sowie Kosten und Latenz reduzieren. Für Anwendungsszenarien, die große Mengen an Kontextinformationen verarbeiten müssen, wie z. B. Konversationsagenten, Codierungsassistenten und die Verarbeitung großer Dokumente, bringt das Zwischenspeichern von Hinweisen enorme Leistungsverbesserungen. Dieses Update ist derzeit in der öffentlichen Betaversion für Claude3.5 Sonnet und Claude3 Haiku verfügbar, eine Erweiterung auf Claude3 Opus ist geplant.

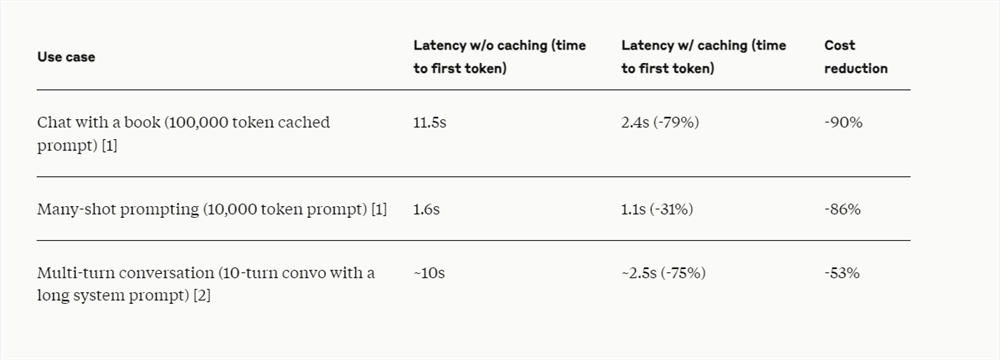

Die Anthropic API hat kürzlich das Prompt-Caching eingeführt, sodass Entwickler nun häufig verwendete Kontextinformationen zwischen API-Aufrufen zwischenspeichern können. Durch das Hint-Caching können Kunden Claude-Modellen mehr Hintergrundwissen und Beispielausgaben zur Verfügung stellen und gleichzeitig die Kosten für lange Hinweise erheblich senken, die Gebühren um bis zu 90 % senken und die Latenz um bis zu 85 % reduzieren.

Diese Funktion ist derzeit in öffentlichen Betaversionen von Claude3.5Sonnet und Claude3Haiku verfügbar und wird in Zukunft auch Claude3Opus unterstützen.

Die Funktion zum Zwischenspeichern von Eingabeaufforderungen ist besonders nützlich in Szenarien, in denen in mehreren Anforderungen wiederholt auf eine große Anzahl von Eingabeaufforderungskontexten verwiesen werden muss, z. B. in Konversations-Proxys, um die Kosten und die Latenz langer Konversationen zu reduzieren, insbesondere wenn komplexe Anweisungen oder Dokument-Uploads enthalten sind Die automatische Vervollständigung des Assistenten und die Fragen und Antworten zur Codebasis können verbessert werden, indem bei der Arbeit mit großen Dokumenten eine zusammengefasste Version der Codebasis beibehalten wird. Der Prompt-Cache ermöglicht das Einbetten von vollständigem Langformmaterial, ohne die Antwortzeiten zusätzlich zu erhöhen Tool-Aufrufe und Iterationen Veränderte Proxy-Such- und Tool-Nutzungsszenarien, Prompt-Caching kann auch die Leistung erheblich verbessern.

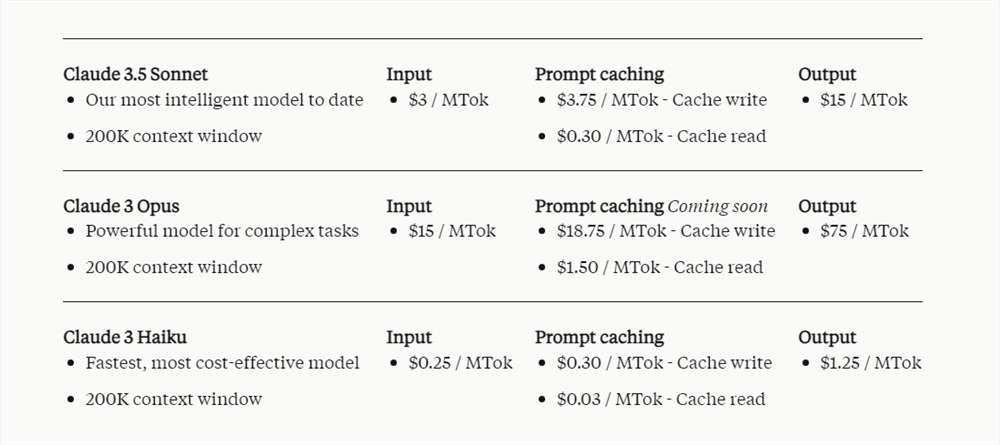

Die Preise für den Trinkgeld-Cache hängen von der Anzahl der zwischengespeicherten Eingabe-Tokens und der Häufigkeit der Nutzung ab. Das Schreiben in den Cache kostet 25 % mehr als der Basis-Input-Token-Preis, während die Verwendung von zwischengespeicherten Inhalten mit nur 10 % des Basis-Input-Token-Preises deutlich weniger kostet.

Es wird berichtet, dass Notion als Kunde von Anthropic API die Prompt-Caching-Funktion in seinen künstlichen Intelligenzassistenten Notion AI integriert hat. Durch die Reduzierung der Kosten und die Erhöhung der Geschwindigkeit optimiert Notion interne Abläufe und bietet Benutzern ein fortschrittlicheres und schnelleres Erlebnis.

Die Einführung der Prompt-Caching-Funktion spiegelt die Bemühungen von Anthropic wider, die Leistung des Claude-Modells zu optimieren und die Benutzerkosten zu senken, Entwicklern kostengünstigere KI-Lösungen bereitzustellen und die Praktikabilität des Claude-Modells in verschiedenen Anwendungsszenarien weiter zu verbessern. Die Erfolgsgeschichten von Notion beweisen auch den praktischen Wert dieser Funktion.