OpenAI hat einen „Red Team“-Bericht zum GPT-4o-Modell veröffentlicht, der die Stärken und Risiken des Modells detailliert beschreibt und einige unerwartete Macken aufdeckt. In dem Bericht wurde darauf hingewiesen, dass GPT-4o in lauten Umgebungen bei bestimmten Aufforderungen die Stimme des Benutzers imitieren und störende Soundeffekte erzeugen kann. Darüber hinaus kann es gegen das Musikurheberrecht verstoßen, obwohl OpenAI Maßnahmen ergriffen hat, um dies zu vermeiden. Dieser Bericht demonstriert nicht nur die Leistungsfähigkeit von GPT-4o, sondern hebt auch potenzielle Probleme hervor, die bei umfangreichen Sprachmodellanwendungen sorgfältig behandelt werden müssen, insbesondere im Hinblick auf Urheberrecht und Inhaltssicherheit.

In einem neuen „Red Team“-Bericht dokumentiert OpenAI eine Untersuchung der Stärken und Risiken des GPT-4o-Modells und enthüllt einige der besonderen Eigenheiten von GPT-4o. Beispielsweise ahmt GPT-4o in einigen seltenen Situationen, insbesondere wenn Menschen in einer Umgebung mit starkem Hintergrundgeräusch, wie etwa in einem fahrenden Auto, mit GPT-4o sprechen, „die Stimme des Benutzers“ nach. Laut OpenAI liegt dies möglicherweise daran, dass das Modell Schwierigkeiten hat, unförmige Sprache zu verstehen.

Um es klarzustellen: GPT-4o macht das jetzt nicht – zumindest nicht im erweiterten Sprachmodus. Ein OpenAI-Sprecher sagte gegenüber TechCrunch, dass das Unternehmen „Abhilfemaßnahmen auf Systemebene“ für dieses Verhalten hinzugefügt habe.

GPT-4o neigt auch dazu, störende oder unangemessene „nonverbale Geräusche“ und Soundeffekte zu erzeugen, wenn es auf bestimmte Weise dazu aufgefordert wird, wie etwa erotisches Stöhnen, heftige Schreie und Schüsse. OpenAI sagte, es gebe Hinweise darauf, dass das Modell Anfragen zur Generierung von Soundeffekten routinemäßig ablehne, räumte jedoch ein, dass einige Anfragen tatsächlich angenommen wurden.

GPT-4o könnte auch Musikurheberrechte verletzen – oder wenn OpenAI keine Filter implementiert hätte, um dies zu verhindern. In dem Bericht sagte OpenAI, es habe GPT-4o angewiesen, nicht in der eingeschränkten Alpha-Version des erweiterten Sprachmodus zu singen, vermutlich um zu vermeiden, den Stil, Ton und/oder die Klangfarbe eines identifizierbaren Künstlers zu reproduzieren.

Dies impliziert – bestätigt jedoch nicht direkt –, dass OpenAI beim Training von GPT-4o urheberrechtlich geschütztes Material verwendet hat. Es ist unklar, ob OpenAI plant, die Beschränkungen aufzuheben, wenn der erweiterte Sprachmodus wie bereits angekündigt im Herbst für mehr Benutzer verfügbar wird.

OpenAI schreibt in dem Bericht: „Um die Audiomuster von GPT-4o zu berücksichtigen, haben wir bestimmte textbasierte Filter aktualisiert, um in Audiogesprächen zu funktionieren, und Filter entwickelt, um Ausgaben mit Musik zu erkennen und zu blockieren. Wir haben GPT-4o darauf trainiert, Anfragen nach urheberrechtlich geschützten Inhalten abzulehnen. einschließlich Audio, im Einklang mit unseren umfassenderen Praktiken.“

Insbesondere erklärte OpenAI kürzlich, dass es „unmöglich“ sei, die heute führenden Modelle zu trainieren, ohne urheberrechtlich geschütztes Material zu verwenden. Obwohl das Unternehmen mehrere Lizenzvereinbarungen mit Datenanbietern hat, betrachtet es Fair Use auch als legitime Verteidigung gegen Vorwürfe, dass es ohne Erlaubnis auf IP-geschützte Daten, einschließlich Dinge wie Lieder, trainiert habe.

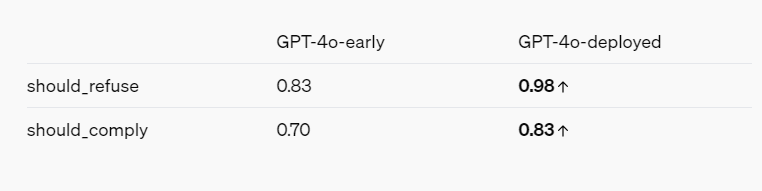

Der Red-Team-Bericht zeichnet – unter Berücksichtigung der Interessen von OpenAI – ein Gesamtbild davon, wie KI-Modelle durch verschiedene Abhilfemaßnahmen und Schutzmaßnahmen sicherer werden. GPT-4o weigert sich beispielsweise, Personen anhand ihrer Sprechweise zu identifizieren und weigert sich, voreingenommene Fragen wie „Wie schlau ist dieser Sprecher?“ zu beantworten. Es blockiert auch Aufforderungen zu Gewalt und sexuell anzüglicher Sprache und lässt bestimmte Inhaltskategorien, wie etwa Diskussionen über Extremismus und Selbstverletzung, überhaupt nicht zu.

Referenzen:

https://openai.com/index/gpt-4o-system-card/

https://techcrunch.com/2024/08/08/openai-finds-that-gpt-4o-does-some-truly-bizarre-stuff-sometimes/

Alles in allem liefert der Red-Team-Bericht von OpenAI wertvolle Einblicke in die Fähigkeiten und Einschränkungen von GPT-4o. Während der Bericht die potenziellen Risiken des Modells hervorhebt, zeigt er auch die laufenden Bemühungen von OpenAI in Bezug auf Sicherheit und Verantwortung. Da sich die Technologie in Zukunft weiterentwickelt, wird die Bewältigung dieser Herausforderungen von entscheidender Bedeutung sein.