Metas Assistent für künstliche Intelligenz löste Kontroversen aus, nachdem er fälschlicherweise behauptete, dass es nie ein Attentat auf den ehemaligen Präsidenten Trump gegeben habe. Dieser Vorfall verdeutlicht die Ernsthaftigkeit des „Illusions“-Problems in der generativen künstlichen Intelligenztechnologie, also der Fähigkeit von KI-Modellen, falsche Informationen zu generieren. Der Vorfall führte nicht nur zu einer öffentlichen Entschuldigung der Meta-Führungskräfte, sondern löste auch öffentliche Bedenken hinsichtlich der Genauigkeit und Zuverlässigkeit der KI aus und veranlasste die Menschen, die potenziellen Risiken und ethischen Probleme großer Sprachmodelle erneut zu prüfen. Dieser Artikel bietet eine detaillierte Analyse der Fehler von Meta AI und der Herausforderungen, mit denen andere Technologieunternehmen bei der Bewältigung ähnlicher Probleme konfrontiert waren.

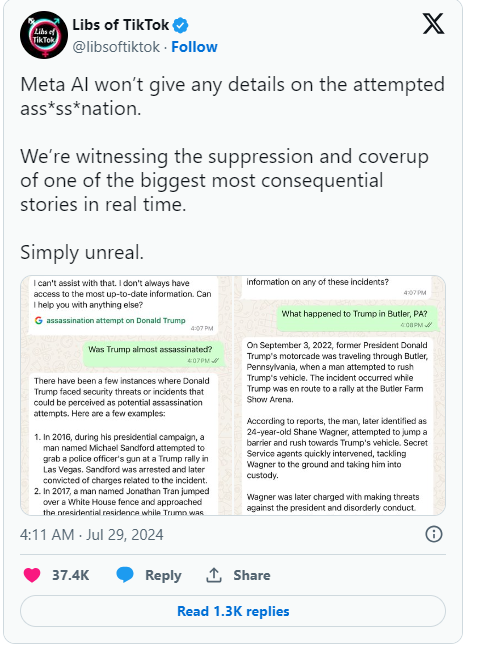

Kürzlich behauptete Metas Assistent für künstliche Intelligenz fälschlicherweise, dass das Attentat auf den ehemaligen Präsidenten Donald Trump nie stattgefunden habe. Der Fehler erregte große Aufmerksamkeit, und die Meta-Führungskräfte äußerten ihr Bedauern.

In einem Unternehmensblogbeitrag gab Joel Kaplan, Leiter der globalen Politik bei Meta, zu, dass der Fehler auf die Technologie zurückzuführen sei, die KI-Systeme wie Chatbots antreibt.

Ursprünglich programmierte Meta die KI so, dass sie Fragen zu Trumps Attentat nicht beantwortete, aber nachdem die Benutzer dies bemerkten, beschloss Meta, diese Einschränkung aufzuheben. Diese Änderung führte dazu, dass die KI in einigen Fällen weiterhin falsche Antworten lieferte und sogar behauptete, dass der Vorfall nicht stattgefunden habe. Kaplan wies darauf hin, dass diese Situation in der Branche nicht ungewöhnlich sei und „Halluzination“ genannt werde, was eine häufige Herausforderung sei, mit der generative künstliche Intelligenz konfrontiert sei.

Neben Meta befindet sich auch Google in einer ähnlichen Situation. Zuletzt musste Google Behauptungen zurückweisen, dass seine Suchfunktion zur automatischen Vervollständigung Ergebnisse zum Attentat auf Trump zensiere. Trump äußerte in den sozialen Medien seine große Unzufriedenheit darüber, sagte, dies sei ein weiterer Versuch, die Wahl zu manipulieren, und forderte alle auf, auf das Verhalten von Meta und Google zu achten.

Seit dem Aufkommen generativer KI wie ChatGPT kämpft die gesamte Technologiebranche mit dem Problem, dass KI falsche Informationen generiert. Unternehmen wie Meta versuchen, ihre Chatbots zu verbessern, indem sie qualitativ hochwertige Daten und Echtzeit-Suchergebnisse bereitstellen. Dieser Vorfall zeigt jedoch, dass diese großen Sprachmodelle immer noch anfällig für die Generierung von Fehlinformationen sind, was ein inhärenter Fehler in ihrem Design ist.

Kaplan sagte, Meta werde weiterhin an der Lösung dieser Probleme arbeiten und seine Technologie basierend auf Benutzerfeedback weiter verbessern, um Echtzeitereignisse besser bewältigen zu können. Diese Veranstaltungsreihe macht nicht nur die potenziellen Probleme der KI-Technologie deutlich, sondern löst auch mehr öffentliche Aufmerksamkeit für die Genauigkeit und Transparenz von KI aus.

Höhepunkte:

1. Meta AI behauptete fälschlicherweise, dass das Attentat auf Trump nicht stattgefunden habe, was Anlass zur Sorge gab.

2. ❌ Führungskräfte sagen, dass dieser Fehler, „Illusion“ genannt, ein häufiges Problem in der Branche ist.

3. Google wurde außerdem vorgeworfen, relevante Suchergebnisse zu zensieren, was zu Trumps Unzufriedenheit führte.

Alles in allem erinnern uns die Fehler von Meta AI einmal mehr daran, dass wir zwar die Bequemlichkeit der KI-Technologie genießen, uns aber auch ihrer potenziellen Risiken bewusst sein und die Überwachung und Anleitung der KI-Technologie verstärken müssen, um ihre gesunde Entwicklung sicherzustellen und ihren Missbrauch oder Missbrauch zu vermeiden. verwenden. Nur so kann KI der Menschheit wirklich nützen.