Das neueste Open-Source-RWKV-CLIP-Modell von Green Deep Learning hat mit seinem innovativen Design, das Transformer und RNN-Architektur integriert, eine starke Leistung im Bereich des Lernens visueller Sprachdarstellungen gezeigt. Dieses Modell löst effektiv das Problem verrauschter Daten und verbessert die Robustheit des Modells und die Leistung nachgelagerter Aufgaben erheblich, indem es eine Doppelturmarchitektur, räumliche Misch- und Kanalmischmodule sowie ein vielfältiges Beschreibungsgenerierungs-Framework geschickt kombiniert. Es hat bahnbrechende Fortschritte beim Bild-Text-Abgleich und -Verstehen erzielt und eine neue Richtung für die Erforschung und Anwendung visueller Sprachmodelle vorgegeben.

Gelingshentong hat das RWKV-CLIP-Modell als Open-Source-Modell bereitgestellt, einen visuellen Sprachrepräsentations-Lerner, der die Vorteile von Transformer und RNN kombiniert. Das Modell verbessert die Leistung bei visuellen und sprachlichen Aufgaben erheblich, indem es den Datensatz um Bild-Text-Paare erweitert, die von Websites durch Bild- und Text-Vortrainingsaufgaben erhalten wurden.

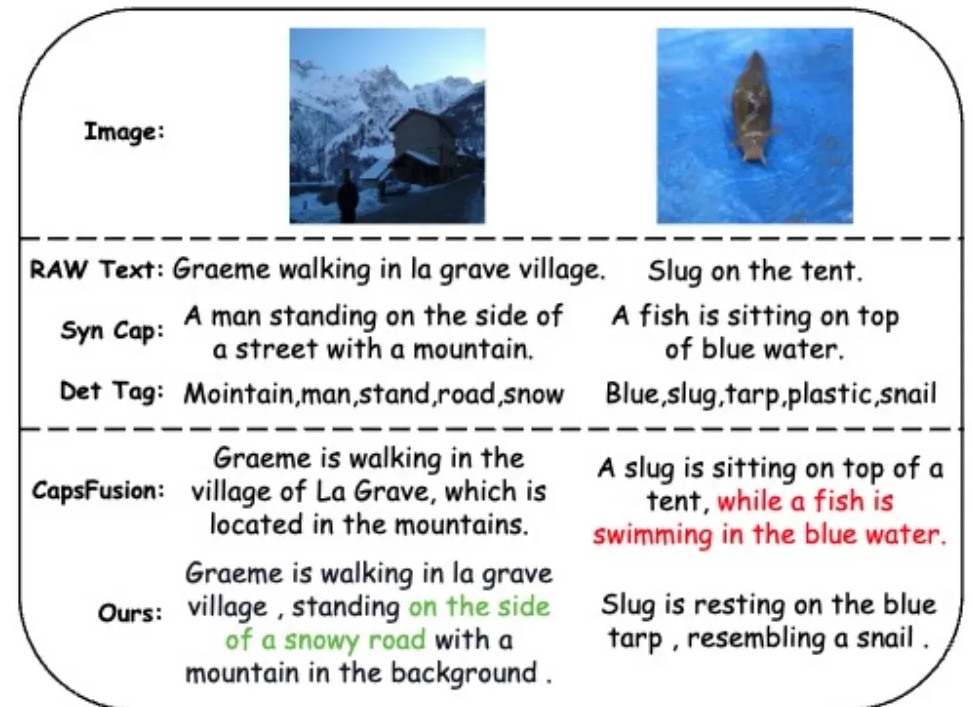

Um das Problem der verrauschten Daten anzugehen und die Datenqualität zu verbessern, führte das Forschungsteam ein vielfältiges Beschreibungsgenerierungs-Framework ein, das große Sprachmodelle (LLMs) nutzt, um Inhalte aus webbasiertem Text, synthetisierten Untertiteln und erkannten Tags zu synthetisieren und zu verfeinern.

Das RWKV-CLIP-Modell verwendet eine Twin-Tower-Architektur, die das effektive parallele Training von Transformer und die effiziente Inferenz von RNN integriert. Das Modell besteht aus mehreren räumlichen Blending- und Channel-Blending-Modulen, die eine tiefgreifende Verarbeitung von Eingabebildern und -texten ermöglichen. In der räumlichen Mischphase verwendet das Modell den Aufmerksamkeitsmechanismus, um eine globale lineare Komplexitätsberechnung durchzuführen und die Interaktion von Merkmalen auf Kanalebene zu stärken. Die Kanalmischungsphase verfeinert die Merkmalsdarstellung weiter. Im Hinblick auf die Eingabeverbesserung erhöht das RWKV-CLIP-Modell die Robustheit des Modells durch zufällige Auswahl von Originaltext, synthetischen Untertiteln oder generierten Beschreibungen als Texteingabe.

Experimentelle Ergebnisse zeigen, dass RWKV-CLIP bei mehreren nachgelagerten Aufgaben Spitzenleistungen erzielt, darunter lineare Erkennung, Zero-Shot-Klassifizierung und Zero-Shot-Bildtextabruf. Im Vergleich zum Basismodell erzielt RWKV-CLIP deutliche Leistungsverbesserungen.

Die modalübergreifende Analyse des RWKV-CLIP-Modells zeigt, dass seine erlernten Darstellungen innerhalb derselben Modalität eine klarere Unterscheidbarkeit aufweisen und im Bild-Text-Modalitätsraum engere Abstände aufweisen, was auf eine modalitätsübergreifende bessere Ausrichtungsleistung hinweist.

Modelladresse: https://wisemodel.cn/models/deepglint/RWKV-CLIP

Insgesamt zeigt das RWKV-CLIP-Modell großes Potenzial im Bereich der visuellen Sprache, und seine Open Source bietet auch wertvolle Ressourcen für die entsprechende Forschung. Interessierte Entwickler können den bereitgestellten Link besuchen, um das Modell herunterzuladen und weitere Forschung und Anwendung durchzuführen.