ARC-AGI, ein Benchmark zur Bewertung der Abstraktions- und Argumentationsfähigkeiten der künstlichen allgemeinen Intelligenz (AGI), hat kürzlich Fortschritte gemacht, aber sein Schöpfer Francois Cholet erinnert uns daran, dass dies nicht bedeutet, dass AGI näher rückt. Er wies darauf hin, dass die Leistung aktueller KI-Systeme im ARC-AGI-Test immer noch weit unter den Erwartungen liege und der Hauptgrund die Einschränkungen großer Sprachmodelle (LLM) seien, die bei der Mustererkennung besser seien als beim echten Denken. Sholay und seine Mitarbeiter starteten einen 1-Millionen-Dollar-Wettbewerb, um Open-Source-KI-Durchbrüche bei ARC-AGI zu fördern. Die Ergebnisse bestätigten jedoch auch, dass der Test selbst möglicherweise Mängel aufweist und weiterer Verbesserungen bedarf.

Seit seiner Einführung im Jahr 2019 steht ARC-AGI im Fokus der Aufmerksamkeit im Bereich der künstlichen Intelligenz. Obwohl das KI-System beim Testen einige Fortschritte machte, lagen seine Ergebnisse immer noch deutlich unter dem menschlichen Niveau. Dies hat zum Nachdenken über die aktuelle Richtung der KI-Entwicklung geführt und Forscher dazu veranlasst, die Definitions- und Bewertungsmethoden von AGI zu überdenken. Der Artikel analysiert detailliert die Einschränkungen des ARC-AGI-Tests sowie die Aussichten für zukünftige AGI-Forschungsrichtungen und zeigt relevante Wettbewerbsergebnisse und Bewältigungsstrategien der Forscher auf.

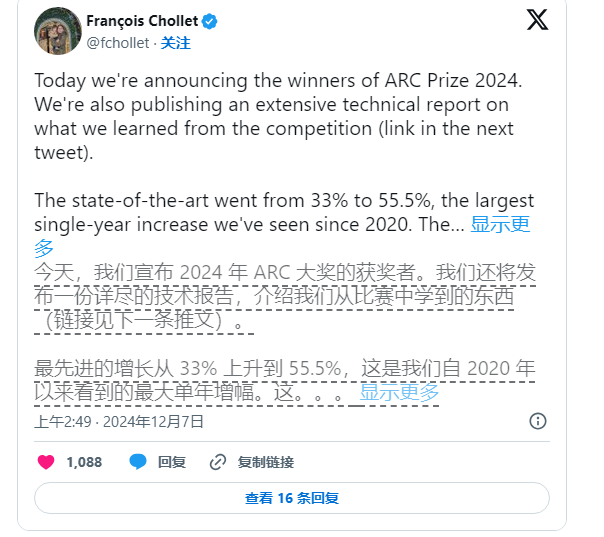

Dennoch hat Sholay nicht aufgehört, die KI-Forschung voranzutreiben. Er und Zapier-Gründer Mike Knoop haben im Juni dieses Jahres gemeinsam einen 1-Millionen-Dollar-Wettbewerb ins Leben gerufen, um Open-Source-KI zu ermutigen, den ARC-AGI-Benchmark herauszufordern. Obwohl das leistungsstärkste KI-System nur 55,5 % von 17.789 Einsendungen erreichte, was unter der 85 %-Marke liegt, die zur Erreichung „menschlicher Leistung“ erforderlich ist, sehen Sholay und Knoop dies dennoch als einen wichtigen Schritt nach vorne.

Knoop wies in einem Blog-Beitrag darauf hin, dass dieser Erfolg nicht bedeutet, dass wir der Verwirklichung von AGI näher gekommen sind. Vielmehr unterstreicht er, dass einige Aufgaben in ARC-AGI zu sehr auf „Brute-Force“-Lösungen beruhen und möglicherweise keine wirksamen Signale für echte Allgemeingültigkeit liefern Intelligenz. ARC-AGI wurde ursprünglich entwickelt, um die Generalisierungsfähigkeit der KI durch die Bereitstellung komplexer, noch nie dagewesener Aufgaben zu testen. Es bestehen jedoch immer noch Zweifel, ob diese Aufgaben AGI effektiv bewerten können.

Hinweis zur Bildquelle: Das Bild wird von AI und dem Bildautorisierungsdienstleister Midjourney generiert

Bei den Aufgaben im ARC-AGI-Benchmark handelt es sich um Rätselprobleme usw., bei denen die KI auf der Grundlage bekannter Informationen auf unbekannte Antworten schließen muss. Obwohl diese Aufgaben die Anpassung der KI an neue Situationen zu fördern scheinen, zeigen die Ergebnisse, dass bestehende Modelle scheinbar Lösungen durch eine große Menge an Berechnungen finden und nicht unbedingt eine echte intelligente Anpassungsfähigkeit aufweisen.

Darüber hinaus wurden die Erfinder von ARC-AGI von ihren Kollegen kritisiert, insbesondere hinsichtlich der Unklarheit hinsichtlich der Definition von AGI. Ein OpenAI-Mitarbeiter erklärte kürzlich, dass AGI tatsächlich erreicht wurde, wenn AGI als künstliche Intelligenz definiert wird, die „bei den meisten Aufgaben eine bessere Leistung erbringt als die meisten Menschen“. Cholet und Knoop argumentieren jedoch, dass bestehende Designs für den ARC-AGI-Benchmark dieses Ziel noch nicht vollständig erreicht haben.

Für die Zukunft planen Sholay und Knoop die Veröffentlichung einer zweiten Generation des ARC-AGI-Benchmarks und werden 2025 einen neuen Wettbewerb veranstalten, um Mängel in den aktuellen Tests zu beheben. Sie sagten, dass sich der neue Benchmark stärker darauf konzentrieren werde, die Entwicklung der KI-Forschung in eine wichtigere Richtung zu fördern und die Umsetzung von AGI zu beschleunigen.

Allerdings ist die Korrektur bestehender Benchmarks keine leichte Aufgabe. Die Bemühungen von Sholay und Knoop zeigen, dass die Definition von Intelligenz in der künstlichen Intelligenz, insbesondere im Bereich der allgemeinen Intelligenz, nach wie vor eine schwierige und komplexe Aufgabe ist.

Alles in allem spiegeln die Fortschritte des ARC-AGI-Benchmarks und die damit verbundenen Diskussionen wider, dass die Erforschung der allgemeinen künstlichen Intelligenz im Bereich der künstlichen Intelligenz noch im Gange ist und sowohl Durchbrüche als auch Herausforderungen erfordert Die Zukunft fördern.