Visuelle Sprachmodelle (VLMs) haben im Bereich der künstlichen Intelligenz erhebliche Fortschritte gemacht, stehen jedoch immer noch vor Herausforderungen bei der Verarbeitung hochauflösender Bilder und vielfältiger Texte. Bestehende Modelle verwenden häufig statische visuelle Encoder, die ineffizient sind und bei verschiedenen Datensätzen keine Genauigkeit aufweisen. Der Mangel an Diversität und Aufgabenspezifität im Trainingsdatensatz schränkt auch seine Leistung ein, insbesondere bei speziellen Domänenaufgaben wie der Graphinterpretation.

Mit der rasanten Entwicklung der künstlichen Intelligenz hat die Integration visueller und sprachlicher Fähigkeiten zu bahnbrechenden Fortschritten bei visuellen Sprachmodellen (VLMs) geführt. Diese Modelle sind darauf ausgelegt, Bild- und Textdaten gleichzeitig zu verarbeiten und zu verstehen, und werden häufig in Szenarien wie Bildbeschreibung, visueller Beantwortung von Fragen, optischer Zeichenerkennung und multimodaler Inhaltsanalyse eingesetzt.

VLMs haben eine wichtige Rolle bei der Entwicklung autonomer Systeme, einer verbesserten Mensch-Computer-Interaktion und effizienten Dokumentenverarbeitungstools gespielt und die Lücke zwischen diesen beiden Datenmodalitäten erfolgreich geschlossen. Bei der Verarbeitung hochauflösender visueller Daten und verschiedener Texteingaben bestehen jedoch noch viele Herausforderungen.

Die aktuelle Forschung hat diese Einschränkungen teilweise behoben, aber die statischen visuellen Encoder, die von den meisten Modellen verwendet werden, sind nicht an hohe Auflösungen und variable Eingabegrößen anpassbar. Gleichzeitig führt die Kombination vorab trainierter Sprachmodelle mit visuellen Encodern häufig zu Ineffizienzen, da sie nicht für multimodale Aufgaben optimiert sind. Obwohl einige Modelle Sparse-Computing-Techniken zur Bewältigung der Komplexität einführen, ist die Genauigkeit verschiedener Datensätze immer noch unzureichend. Darüber hinaus mangelt es den Trainingsdatensätzen bestehender Modelle häufig an Diversität und Aufgabenspezifität, was ihre Leistung weiter einschränkt. Beispielsweise schneiden viele Modelle bei speziellen Aufgaben wie der Diagramminterpretation oder der Analyse dichter Dokumente schlecht ab.

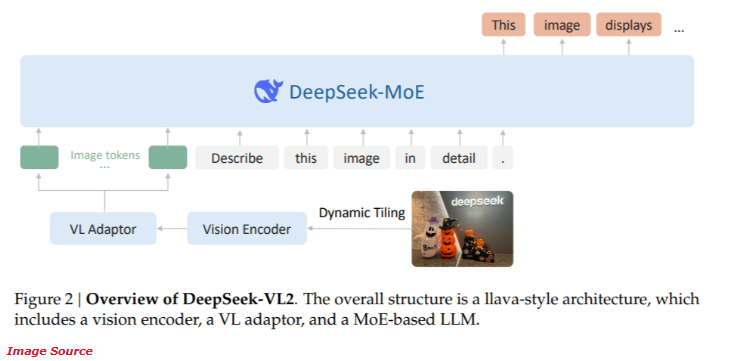

Vor Kurzem hat DeepSeek-AI die neue DeepSeek-VL2-Serie visueller Sprachmodelle für Open-Source-Hybrid-Experten (MoE) auf den Markt gebracht. Diese Modellreihe kombiniert modernste innovative Technologien, darunter dynamisches Slicing der visuellen Kodierung, einen Latent-Attention-Mechanismus mit mehreren Köpfen und das DeepSeek-MoE-Framework.

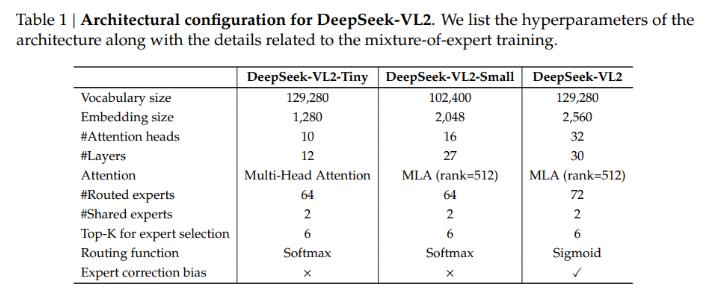

Die DeepSeek-VL2-Serie bietet drei verschiedene Parameterkonfigurationen:

- DeepSeek-VL2-Tiny: 3,37 Milliarden Parameter (1 Milliarde Aktivierungsparameter)

- DeepSeek-VL2-Small: 16,1 Milliarden Parameter (2,8 Milliarden Aktivierungsparameter)

- DeepSeek-VL2: 27,5 Milliarden Parameter (4,5 Milliarden Aktivierungsparameter)

Diese Skalierbarkeit gewährleistet die Anpassungsfähigkeit an unterschiedliche Anwendungsanforderungen und Rechenbudgets.

Die Architektur von DeepSeek-VL2 ist darauf ausgelegt, die Leistung zu optimieren und gleichzeitig den Rechenaufwand zu reduzieren. Die dynamische Slicing-Methode stellt sicher, dass hochauflösende Bilder verarbeitet werden, ohne dass wichtige Details verloren gehen, und eignet sich daher ideal für Dokumentenanalysen und visuelle Lokalisierungsaufgaben. Darüber hinaus ermöglicht der latente Aufmerksamkeitsmechanismus mit mehreren Köpfen dem Modell die effiziente Verarbeitung großer Textdatenmengen, wodurch der Rechenaufwand reduziert wird, der normalerweise mit der Verarbeitung dichter Spracheingaben verbunden ist. Das Training von DeepSeek-VL2 deckt verschiedene multimodale Datensätze ab und ermöglicht so eine gute Leistung bei einer Vielzahl von Aufgaben wie optischer Zeichenerkennung, visueller Beantwortung von Fragen und Diagramminterpretation.

Laut Leistungstests erreichte die kleine Konfiguration eine Genauigkeit von 92,3 % bei der Aufgabe der optischen Zeichenerkennung und übertraf damit bestehende Modelle deutlich. Im Benchmark-Test zur visuellen Positionierung verbesserte das Modell die Genauigkeit im Vergleich zum Produkt der vorherigen Generation um 15 %.

Gleichzeitig reduziert DeepSeek-VL2 den Bedarf an Rechenressourcen um 30 % und behält dabei die Genauigkeit auf dem neuesten Stand der Technik bei. Diese Ergebnisse belegen die Überlegenheit dieses Modells bei der hochauflösenden Bild- und Textverarbeitung.

Projekteingang: https://huggingface.co/collections/deepseek-ai/deepseek-vl2-675c22accc456d3beb4613ab

Höhepunkte:

Die DeepSeek-VL2-Serie bietet eine Vielzahl von Parameterkonfigurationen zur Anpassung an unterschiedliche Anwendungsanforderungen.

Die Dynamic-Slicing-Technologie verbessert die Effizienz der hochauflösenden Bildverarbeitung und eignet sich für komplexe Dokumentenanalysen.

Das Modell schneidet bei Aufgaben der optischen Zeichenerkennung und visuellen Lokalisierung gut ab und weist eine deutlich verbesserte Genauigkeit auf.

Die Modelle der DeepSeek-VL2-Serie haben mit ihrer innovativen Architektur und hervorragenden Leistung neue Durchbrüche im Bereich der visuellen Sprachmodelle gebracht. Aufgrund seiner Vorteile bei der hochauflösenden Bild- und komplexen Textverarbeitung weist es in vielen Anwendungsszenarien großes Potenzial auf und verdient weitere Aufmerksamkeit und Forschung.