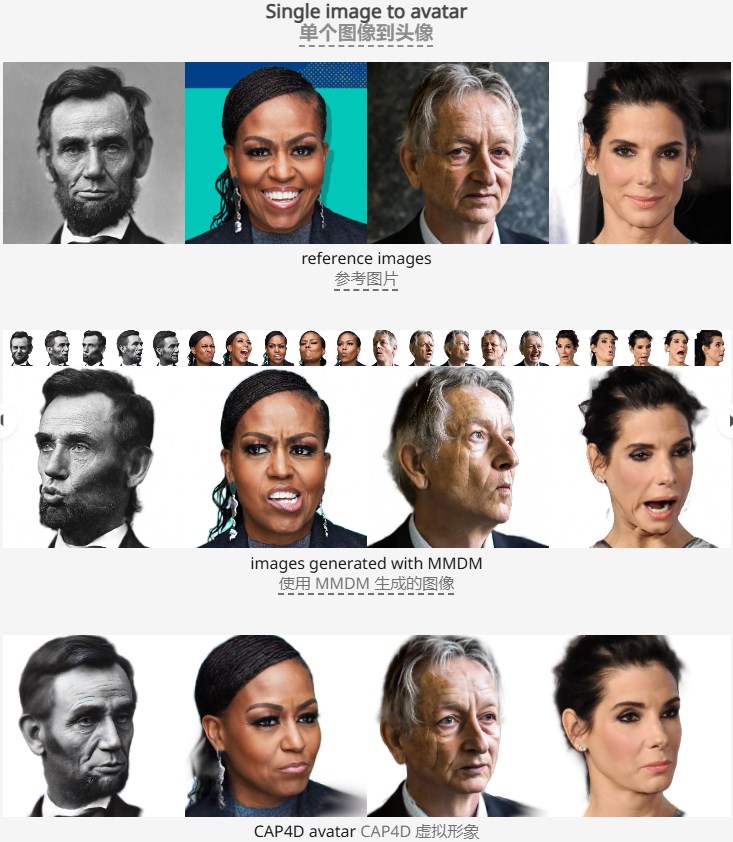

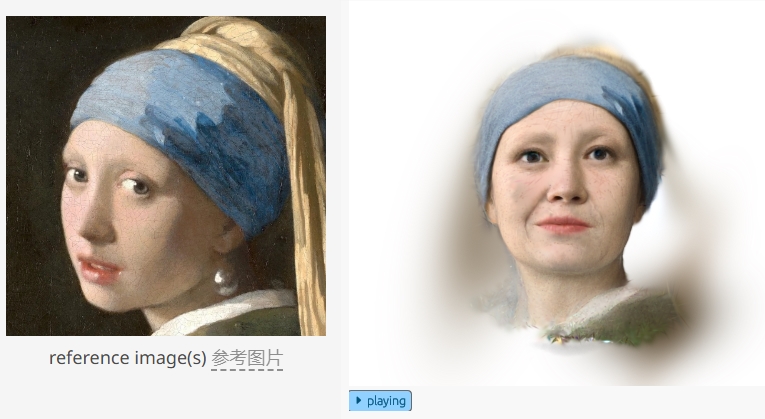

Das Forschungsteam der University of Toronto und des Vector Institute hat kürzlich das CAP4D-Modell veröffentlicht, eine bahnbrechende Technologie zur 4D-Avatar-Generierung. Es basiert auf dem deformierbaren Multi-View-Diffusionsmodell (MMDM) und kann aus beliebig vielen Referenzbildern realistische, in Echtzeit steuerbare 4D-Avatare generieren, wodurch der Avatar-Rekonstruktionseffekt und die Detaildarstellung deutlich verbessert werden. Diese Technologie kann nicht nur ein einzelnes oder eine kleine Anzahl von Referenzbildern verarbeiten, sondern sogar Avatare aus Textaufforderungen oder Kunstwerken generieren, was ihre starke Anpassungsfähigkeit und generativen Fähigkeiten unter Beweis stellt. Die zweistufige Methode verwendet zunächst MMDM, um Bilder mit unterschiedlichen Perspektiven und Ausdrücken zu generieren, und kombiniert dann Referenzbilder, um 4D-Avatare zu rekonstruieren. Sie unterstützt die Kombination mit vorhandenen Bildbearbeitungsmodellen und sprachgesteuerten Animationsmodellen, um umfassendere Interaktionen und dynamische Effekte zu erzielen stellt virtuelle Avatare zur Verfügung, die neue Möglichkeiten eröffnen.

Das Modell verwendet eine zweistufige Methode: Zunächst werden mithilfe von MMDM Bilder mit unterschiedlichen Perspektiven und Ausdrücken generiert. Anschließend werden diese generierten Bilder mit Referenzbildern kombiniert, um einen 4D-Avatar zu rekonstruieren, der in Echtzeit gesteuert werden kann. Benutzer können eine beliebige Anzahl von Referenzbildern eingeben, und das Modell verwendet diese Bildinformationen, um hochwertige 4D-Avatare zu generieren, und unterstützt die Kombination mit sprachgesteuerten Animationsmodellen, um audiogesteuerte dynamische Effekte zu erzielen. Die Entstehung des CAP4D-Modells stellt einen bedeutenden Fortschritt in der 4D-Avatar-Generierungstechnologie dar, die breite Anwendungsaussichten in Bereichen wie virtuelle Realität, Spiele und Metaversum bietet.

Das Forschungsteam demonstrierte eine Vielzahl von von CAP4D generierten Avataren, die ein einzelnes Referenzbild, eine kleine Anzahl von Referenzbildern und das anspruchsvollere Szenario der Generierung von Avataren aus Textaufforderungen oder Grafiken abdeckten. Durch die Verwendung mehrerer Referenzbilder ist das Modell in der Lage, Details und Geometrien wiederherzustellen, die in einem einzelnen Bild nicht zu sehen sind, wodurch die Rekonstruktionsleistung verbessert wird. Darüber hinaus bietet CAP4D auch die Möglichkeit, mit vorhandenen Bildbearbeitungsmodellen kombiniert zu werden, sodass Benutzer das Erscheinungsbild und die Beleuchtung des generierten Avatars bearbeiten können.

Um die Ausdruckskraft des Avatars weiter zu verbessern, kann CAP4D den generierten 4D-Avatar mit dem sprachgesteuerten Animationsmodell kombinieren, um audiogesteuerte Animationseffekte zu erzielen. Dadurch kann der Avatar nicht nur statische visuelle Effekte anzeigen, sondern auch dynamisch mit Benutzern über Ton interagieren, wodurch ein neues Feld für virtuelle Avatar-Anwendungen entsteht.

Highlight:

Das CAP4D-Modell kann mithilfe eines zweistufigen Workflows aus beliebig vielen Referenzbildern hochwertige 4D-Avatare generieren.

Diese Technologie kann Avatare aus verschiedenen Perspektiven generieren und so den Bildrekonstruktionseffekt und die Detaildarstellung deutlich verbessern.

CAP4D wird mit dem sprachgesteuerten Animationsmodell kombiniert, um audiogesteuerte dynamische Avatare zu realisieren und die Anwendungsszenarien virtueller Avatare zu erweitern.

Alles in allem hat das CAP4D-Modell einen bedeutenden Durchbruch im Bereich der 4D-Avatar-Generierung erzielt und seine effizienten, realistischen und multifunktionalen Funktionen haben neue Möglichkeiten in Bereichen wie virtuelle Realität und digitale Unterhaltung eröffnet. Es wird erwartet, dass diese Technologie in Zukunft weiterentwickelt wird, um Benutzern ein komfortableres und realistischeres virtuelles interaktives Erlebnis zu bieten.