Stellen Sie sich vor, Sie könnten mit nur wenigen Summen oder Schlägen hochwertige Musik oder Soundeffekte erzeugen. Das ist kein ferner Traum mehr. Sketch2Sound, das Ergebnis bahnbrechender KI-Forschung, erreicht eine hochwertige Audioerzeugung durch die Kombination von Klangimitation und Textansagen. Es nutzt geschickt die drei wichtigsten Steuersignale Lautstärke, Helligkeit und Tonhöhe, die aus der Klangimitation gewonnen werden, und integriert sie in das potenzielle Diffusionsmodell von Text zu Audio, wodurch die KI angeleitet wird, Klänge zu erzeugen, die bestimmte Anforderungen erfüllen, was große Vorteile für den Bereich bringt Klangschöpfung. Revolutionäre Veränderungen.

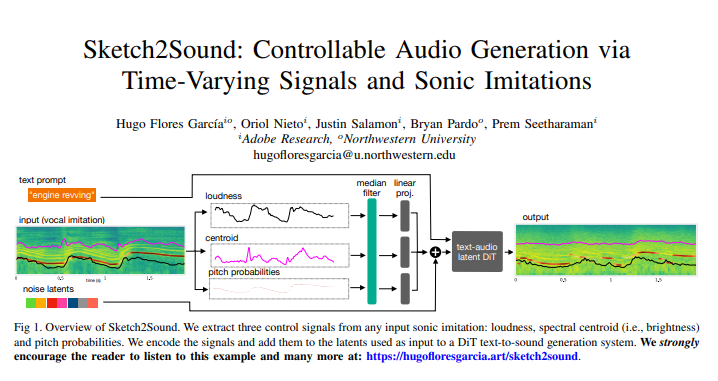

Die Kerntechnologie von Sketch2Sound ist die Fähigkeit, aus jeder Klangimitation (z. B. einer Stimmimitation oder einem Referenzklang) drei wichtige, zeitlich veränderliche Steuersignale zu extrahieren: Lautstärke, Helligkeit (Spektralschwerpunkt) und Tonhöhe. Sobald diese Steuersignale codiert sind, werden sie dem zugrunde liegenden Diffusionsmodell hinzugefügt, das für die Text-zu-Ton-Erzeugung verwendet wird, und leiten so die KI an, Geräusche zu erzeugen, die bestimmte Anforderungen erfüllen.

Das Beeindruckendste an dieser Technologie ist ihr geringes Gewicht und ihre Effizienz. Sketch2Sound basiert auf dem bestehenden latenten Text-zu-Audio-Diffusionsmodell und erfordert nur 40.000 Feinabstimmungsschritte und nur eine lineare Ebene für jedes Steuersignal, was es prägnanter und effizienter macht als andere Methoden (wie ControlNet). Damit das Modell aus „skizzenartigen“ Klangimitationen synthetisieren kann, wendeten die Forscher während des Trainings außerdem einen stochastischen Medianfilter auf das Steuersignal an, wodurch es sich an Steuersignale mit flexiblen zeitlichen Eigenschaften anpassen konnte. Experimentelle Ergebnisse zeigen, dass Sketch2Sound nicht nur Klänge synthetisieren kann, die dem Eingangssteuersignal entsprechen, sondern auch die Einhaltung von Textaufforderungen aufrechterhalten und eine Audioqualität erzielen kann, die mit der Basislinie für einfachen Text vergleichbar ist.

Sketch2Sound bietet Klangkünstlern eine neue Möglichkeit zum Schaffen. Sie können die semantische Flexibilität textlicher Aufforderungen, kombiniert mit der Ausdruckskraft und Präzision stimmlicher Gesten oder Imitationen, nutzen, um beispiellose Klangkompositionen zu schaffen. Dies ähnelt traditionellen Foley-Künstlern, die Klangeffekte durch Manipulation von Objekten erzeugen, während Sketch2Sound die Klangerzeugung durch Klangimitation steuert, der Klangerzeugung eine „humanisierte“ Note verleiht und den künstlerischen Wert von Klangwerken verbessert.

Sketch2Sound ist in der Lage, seine Einschränkungen im Vergleich zu herkömmlichen Text-zu-Audio-Interaktionsmethoden zu überwinden. In der Vergangenheit mussten Sounddesigner viel Zeit damit verbringen, die zeitlichen Eigenschaften der erzeugten Klänge anzupassen, um sie mit visuellen Effekten zu synchronisieren. Sketch2Sound kann diese Synchronisierung natürlich durch Klangimitation erreichen und ist nicht auf die Nachahmung menschlicher Stimmen jeglicher Art beschränkt Nachahmung kann verwendet werden, um dieses generative Modell voranzutreiben.

Die Forscher entwickelten außerdem eine Technik, um die zeitlichen Details des Steuersignals anzupassen, indem sie während des Trainings Medianfilter mit unterschiedlichen Fenstergrößen anwendeten. Auf diese Weise können Klangkünstler steuern, wie gut das generative Modell die zeitliche Genauigkeit des Steuersignals einhält, wodurch die Qualität von Klängen verbessert wird, die sich nur schwer perfekt imitieren lassen. In praktischen Anwendungen können Benutzer durch Anpassung der Größe des Medianfilters ein Gleichgewicht zwischen der strikten Einhaltung der Klangimitation und der Sicherstellung der Audioqualität finden.

Das Arbeitsprinzip von Sketch2Sound besteht darin, zunächst drei Steuersignale für Lautstärke, Spektrumsschwerpunkt und Tonhöhe aus dem Eingangsaudiosignal zu extrahieren. Diese Steuersignale werden dann mit den latenten Signalen im Text-zu-Ton-Modell abgeglichen, und das latente Diffusionsmodell wird über eine einfache lineare Projektionsschicht abgestimmt, um letztendlich den gewünschten Klang zu erzeugen. Experimentelle Ergebnisse zeigen, dass die Konditionierung des Modells durch zeitlich variierende Steuerung des Signals die Einhaltung dieses Signals erheblich verbessern kann, während die Audioqualität und die Textkonformität nur minimal beeinträchtigt werden.

Bemerkenswerterweise fanden die Forscher auch heraus, dass Steuersignale die Semantik der erzeugten Signale manipulieren können. Wenn Sie beispielsweise die Textaufforderung „Waldambiente“ verwenden und der Klangimitation zufällige Lautstärkestöße hinzufügen, kann das Modell Vogelrufe in diesen Lautstärkestößen ohne die zusätzliche Aufforderung „Vögel“ synthetisieren, was darauf hinweist, dass das Modell die Korrelation zwischen gelernt hat Lautstärkeausbrüche und Vogelpräsenz.

Natürlich gibt es bei Sketch2Sound einige Einschränkungen, z. B. die Tatsache, dass die Schwerpunktsteuerung die durch die Eingabegeräusche modellierten Raumtöne in das generierte Audio integrieren kann, möglicherweise weil die Raumtöne durch den Schwerpunkt codiert werden, wenn dies der Fall ist Keine Tonereignisse im Eingangsaudio.

Alles in allem ist Sketch2Sound ein leistungsstarkes generatives Klangmodell, das durch Textansagen und zeitlich variierende Steuerungen (Lautstärke, Helligkeit, Tonhöhe) Töne erzeugen kann. Es kann Klänge durch Klangimitation und „Skizze“ von Steuerkurven erzeugen und ist leichtgewichtig und effizient. Es bietet Klangkünstlern ein steuerbares, gestenbasiertes und ausdrucksstarkes Werkzeug, das Klänge mit flexiblem Timing erzeugen kann Anwendungsperspektiven in den Bereichen Musikkreation und Game-Sounddesign in der Zukunft.

Papieradresse: https://arxiv.org/pdf/2412.08550

Das Aufkommen von Sketch2Sound läutet eine neue Ära im Bereich der Klangerstellung ein. Es bietet Künstlern beispiellose kreative Freiheiten und Möglichkeiten und eröffnet außerdem unbegrenzten Fantasieraum für Musik, Spiele, Filme und andere Bereiche. Ich glaube, dass diese Technologie in naher Zukunft weiter verbreitet sein wird und uns eine buntere Klangwelt bescheren wird.