Das chinesische Startup für künstliche Intelligenz DeepSeek hat sein neuestes ultragroßes Modell DeepSeek-V3 veröffentlicht, das mit seinem Open-Source-Code und seiner leistungsstarken Leistung zum Fokus der Branche geworden ist. Mit 671B-Parametern und einer Experten-Hybridarchitektur übertrifft DeepSeek-V3 führende Open-Source-Modelle in mehreren Benchmarks und schneidet sogar ähnlich ab wie einige Closed-Source-Modelle. Seine Innovation liegt in seiner zusätzlichen verlustfreien Lastausgleichsstrategie und der Multi-Token-Vorhersagetechnologie, die die Effizienz und Ausführungsgeschwindigkeit des Modelltrainings erheblich verbessert. Die Veröffentlichung von DeepSeek-V3 stellt einen großen Durchbruch in der Open-Source-KI-Technologie dar, indem sie die Lücke zur Closed-Source-KI weiter verringert und den Weg für die Entwicklung künstlicher allgemeiner Intelligenz (AGI) ebnet.

Am 26. Dezember 2024 veröffentlichte das chinesische Startup für künstliche Intelligenz DeepSeek sein neuestes ultragroßes Modell DeepSeek-V3, das für seine Open-Source-Technologie und innovativen Herausforderungen führender KI-Anbieter bekannt ist. DeepSeek-V3 verfügt über 671B Parameter und nutzt eine Architektur aus verschiedenen Experten, um spezifische Parameter zu aktivieren, um eine bestimmte Aufgabe genau und effizient zu erledigen. Laut von DeepSeek bereitgestellten Benchmarks hat dieses neue Modell führende Open-Source-Modelle, darunter Metas Llama3.1-405B, übertroffen und weist eine ähnliche Leistung wie geschlossene Modelle von Anthropic und OpenAI auf.

Die Veröffentlichung von DeepSeek-V3 markiert eine weitere Verringerung der Kluft zwischen Open-Source-KI und Closed-Source-KI. DeepSeek, das als Ableger des chinesischen Quant-Hedgefonds High-Flyer Capital Management begann, hofft, dass diese Entwicklungen den Weg für künstliche allgemeine Intelligenz (AGI) ebnen, bei der Modelle in der Lage sein werden, jede intellektuelle Aufgabe, die ein Mensch ausführen kann, zu verstehen oder zu erlernen .

Zu den Hauptfunktionen von DeepSeek-V3 gehören:

Wie sein Vorgänger DeepSeek-V2 basiert das neue Modell auf der Grundarchitektur von Multi-Head Latent Attention (MLA) und DeepSeekMoE und gewährleistet so effizientes Training und Inferenz.

Das Unternehmen brachte außerdem zwei Innovationen auf den Markt: eine zusätzliche verlustfreie Lastausgleichsstrategie und Multi-Token Prediction (MTP), die es Modellen ermöglicht, mehrere zukünftige Token gleichzeitig vorherzusagen, was die Trainingseffizienz verbessert und es Modellen ermöglicht, dreimal schneller zu laufen und 60 Token pro Sekunde zu generieren .

In der Vortrainingsphase trainierte DeepSeek-V3 mit 14,8T hochwertigen und vielfältigen Token, führte eine zweistufige Kontextlängenerweiterung durch und führte schließlich das Nachtraining mit überwachter Feinabstimmung (SFT) und Reinforcement Learning (RL) durch. , um das Modell an den menschlichen Vorlieben auszurichten und sein Potenzial weiter auszuschöpfen.

In der Trainingsphase nutzt DeepSeek eine Vielzahl von Hardware- und Algorithmusoptimierungen, darunter das FP8-Trainingsframework mit gemischter Präzision und den DualPipe-Algorithmus zur Pipeline-Parallelisierung, wodurch die Trainingskosten gesenkt werden. Der gesamte Trainingsprozess von DeepSeek-V3 soll in 2788K H800-GPU-Stunden oder etwa 5,57 Millionen US-Dollar abgeschlossen sein, was weit weniger ist als die Hunderte Millionen Dollar, die normalerweise für das Vortraining großer Sprachmodelle ausgegeben werden.

DeepSeek-V3 hat sich zum stärksten Open-Source-Modell auf dem Markt entwickelt. Mehrere vom Unternehmen durchgeführte Benchmarks zeigten, dass es das Closed-Source-GPT-4o in den meisten Benchmarks übertrifft, mit Ausnahme von SimpleQA und FRAMES mit Schwerpunkt auf Englisch, wo das OpenAI-Modell mit Werten von 38,2 bzw. 80,5 an der Spitze stand (DeepSeek-V3-Werte liegen bei 24,9 bzw 73,3). DeepSeek-V3 schnitt bei den Chinesisch- und Mathematik-Benchmarks besonders gut ab und erzielte beim Math-500-Test eine Punktzahl von 90,2, gefolgt von 80 von Qwen.

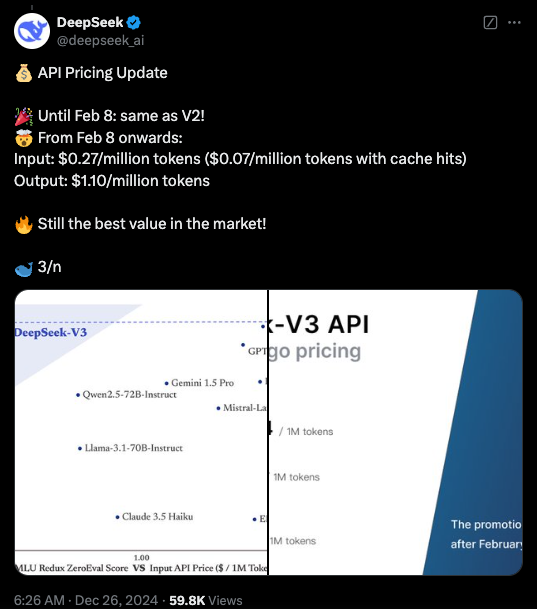

Derzeit ist der Code für DeepSeek-V3 unter einer MIT-Lizenz auf GitHub verfügbar und das Modell wird unter der Modelllizenz des Unternehmens bereitgestellt. Unternehmen können neue Modelle auch über DeepSeek Chat, eine Plattform ähnlich ChatGPT, testen und auf APIs für die kommerzielle Nutzung zugreifen. DeepSeek wird die API bis zum 8. Februar zum gleichen Preis wie DeepSeek-V2 bereitstellen. Danach werden Gebühren in Höhe von 0,27 $ pro Million Input-Tokens (0,07 $ pro Million Tokens für Cache-Hits) und 1,10 $ pro Million Output-Tokens erhoben.

Höhepunkte:

DeepSeek-V3 wird veröffentlicht, mit einer Leistung, die Llama und Qwen übertrifft.

Übernehmen Sie 671B-Parameter und eine Experten-Hybridarchitektur, um die Effizienz zu verbessern.

Zu den Innovationen gehören verlustfreie Lastausgleichsstrategien und Multi-Token-Vorhersage für eine verbesserte Geschwindigkeit.

Die Schulungskosten werden deutlich reduziert, was die Entwicklung von Open-Source-KI fördert.

Die Open Source und die hohe Leistung von DeepSeek-V3 werden tiefgreifende Auswirkungen auf den Bereich der künstlichen Intelligenz haben, die Entwicklung der Open-Source-KI-Technologie fördern und ihre Anwendung in verschiedenen Bereichen fördern. DeepSeek wird weiterhin an der Entwicklung fortschrittlicherer KI-Modelle arbeiten und zur Verwirklichung von AGI beitragen. Wir haben Grund, in Zukunft weitere Durchbrüche von DeepSeek zu erwarten.