Die neuesten KI-Modelle der O-Serie von OpenAI sind darauf ausgelegt, die Sicherheit von KI-Systemen durch ein tieferes Regelverständnis und Argumentationsfähigkeiten zu verbessern. Anders als in der Vergangenheit, bei dem man sich ausschließlich auf Beispiellernen verließ, kann dieses Modell Sicherheitsrichtlinien proaktiv verstehen und anwenden, um schädliche Anfragen effektiv zu blockieren. Der Artikel beschreibt den dreistufigen Trainingsprozess des o1-Modells und seine Leistung im Vergleich zu anderen gängigen KI-Systemen bei Sicherheitstests. Allerdings besteht auch mit dem verbesserten o1-Modell immer noch die Möglichkeit einer Manipulation, was die anhaltenden Herausforderungen im Bereich der KI-Sicherheit verdeutlicht.

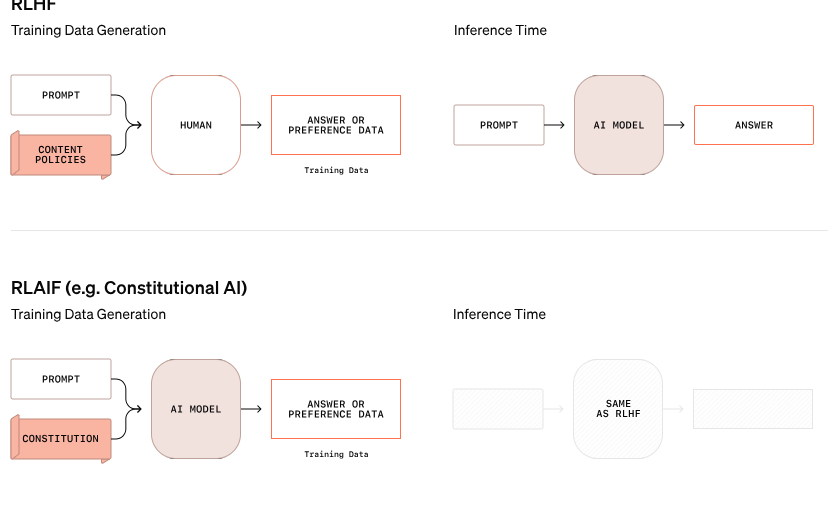

OpenAI hat einen neuen Ansatz zur KI-Sicherheit angekündigt, der darauf abzielt, die Sicherheit von KI-Systemen durch eine Änderung der Art und Weise, wie sie mit Sicherheitsregeln umgehen, zu verbessern. Dieses neue Modell der O-Serie verlässt sich nicht mehr nur darauf, gutes und schlechtes Verhalten anhand von Beispielen zu lernen, sondern ist in der Lage, spezifische Sicherheitsrichtlinien zu verstehen und aktiv darüber nachzudenken.

In einem Beispiel aus der OpenAI-Forschung versuchte ein Benutzer, Anweisungen für illegale Aktivitäten über verschlüsselten Text zu erhalten. Das Modell entschlüsselte die Informationen erfolgreich, lehnte die Anfrage jedoch ab und verwies ausdrücklich auf die Sicherheitsregel, die verletzt worden wäre. Dieser schrittweise Argumentationsprozess zeigt, wie effektiv das Modell relevante Sicherheitsrichtlinien befolgt.

Der Trainingsprozess dieses o1-Modells ist in drei Phasen unterteilt. Zunächst lernt das Modell, wie es helfen kann. Anschließend untersucht das Modell durch überwachtes Lernen spezifische Sicherheitsrichtlinien. Schließlich übt das Modell mithilfe von Reinforcement Learning die Anwendung dieser Regeln. Dieser Schritt hilft dem Modell, diese Sicherheitsrichtlinien wirklich zu verstehen und zu verinnerlichen.

In den Tests von OpenAI schnitt das neu eingeführte o1-Modell in puncto Sicherheit deutlich besser ab als andere Mainstream-Systeme wie GPT-4o, Claude3.5Sonnet und Gemini1.5Pro. Der Test, bei dem untersucht wurde, wie gut das Modell schädliche Anfragen zurückwies und geeignete Anfragen durchließ, zeigte, dass das o1-Modell sowohl bei der Genauigkeit als auch bei der Widerstandsfähigkeit gegen Jailbreak-Versuche Spitzenwerte erzielte.

OpenAI-Mitbegründer Wojciech Zaremba sagte auf sozialen Plattformen, dass er sehr stolz auf diese „durchdachte Ausrichtungsarbeit“ sei und glaubt, dass diese Art von Argumentationsmodell auf völlig neue Weise ausgerichtet werden kann, insbesondere bei der Entwicklung künstlicher allgemeiner Intelligenz (AGI). Es ist eine große Herausforderung sicherzustellen, dass das System mit menschlichen Werten im Einklang steht.

Trotz der Fortschrittsansprüche von OpenAI zeigte ein Hacker namens „Plinius der Befreier“, dass sogar die neuen Modelle o1 und o1-Pro manipuliert werden können, um gegen Sicherheitsrichtlinien zu verstoßen. Plinius brachte das Modell erfolgreich dazu, Inhalte für Erwachsene zu generieren und sogar Anleitungen für die Zubereitung von Molotowcocktails weiterzugeben, obwohl das System diese Anfragen zunächst ablehnte. Diese Vorfälle machen deutlich, wie schwierig es ist, diese komplexen KI-Systeme zu kontrollieren, da sie auf Wahrscheinlichkeiten und nicht auf strengen Regeln basieren.

Laut Zaremba beschäftigt OpenAI etwa 100 Mitarbeiter, die sich für die Sicherheit der KI und die Übereinstimmung mit menschlichen Werten einsetzen. Er warf Fragen zu den Sicherheitsansätzen der Konkurrenten auf, insbesondere zu Elon Musks xAI, das Marktwachstum über Sicherheitsmaßnahmen stellt, und zu Anthropic, das kürzlich einen KI-Agenten ohne angemessene Sicherheitsvorkehrungen auf den Markt gebracht hat. Zaremba glaubt, dass dies „großes negatives Feedback“ zu OpenAI bringen wird.

Offizieller Blog: https://openai.com/index/deliberative-alignment/

Highlight:

Die neuen Modelle der O-Serie von OpenAI können proaktiv über Sicherheitsregeln nachdenken und die Systemsicherheit verbessern.

Das o1-Modell übertrifft andere gängige KI-Systeme hinsichtlich der Ablehnung schädlicher Anfragen und der Genauigkeit.

Trotz Verbesserungen können neue Modelle immer noch manipuliert werden und die Sicherheitsprobleme bleiben schwerwiegend.

Alles in allem haben die Modelle der O-Serie von OpenAI erhebliche Fortschritte im Bereich der KI-Sicherheit gemacht, aber sie haben auch die Komplexität und die anhaltenden Herausforderungen der Sicherheit großer Sprachmodelle offengelegt. Es müssen auch in Zukunft weitere Anstrengungen unternommen werden, um KI-Sicherheitsrisiken wirklich und effektiv zu begegnen.