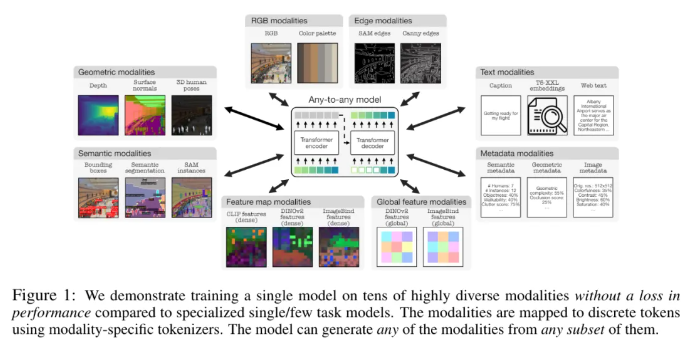

Apple und die Ecole Polytechnique Fédérale de Lausanne (EPFL) in der Schweiz haben gemeinsam ein bahnbrechendes multimodales Modell entwickelt: 4M-21. Das Modell kann auf 21 verschiedenen Modalitäten trainiert werden, seine Leistung ist deutlich besser als bei bestehenden Modellen und es realisiert mehrere Funktionen wie modalübergreifendes Abrufen und steuerbare Generierung. Diese Forschung verbesserte die Leistung und Anpassungsfähigkeit des Modells erheblich, indem die Modell- und Datensatzgröße erweitert, die Art und Anzahl der Trainingsmodalitäten erhöht und eine gemeinsame Trainingsstrategie eingeführt wurde. Das 4M-21-Modell verwendet eine transformatorbasierte Encoder-Decoder-Architektur und fügt zusätzliche modale Einbettungen hinzu, um sich an neue Modalitäten anzupassen. Sein Trainingsprozess berücksichtigt vollständig die Eigenschaften verschiedener Modalitäten und verwendet eine spezifische Tokenisierungsmethode für Modalitäten.

In dieser Studie wurde eine 4M-Vortrainingslösung verwendet, die die Leistung und Anpassungsfähigkeit des Modells verbessern kann, indem die Größe des Modells und der Datensätze erweitert, die Art und Anzahl der beim Training des Modells beteiligten Modalitäten erhöht und gemeinsames Training für mehrere durchgeführt wird Datensätze. Forscher verwenden verschiedene Tokenisierungsmethoden, um Modalitäten mit unterschiedlichen Merkmalen zu diskretisieren, beispielsweise globale Bildeinbettungen, menschliche Posen und semantische Instanzen. In Bezug auf die Architekturauswahl übernimmt diese Studie die auf Transformer basierende 4M-Encoder-Decoder-Architektur und fügt zusätzliche modale Einbettungen hinzu, um sich an neue Modalitäten anzupassen.

Dieses Modell kann nicht nur eine Reihe gängiger Sehaufgaben sofort ausführen, wie z. B. die Schätzung der DIODE-Oberflächennormalen und -Tiefe, die COCO-Semantik und Instanzsegmentierung, die Schätzung der menschlichen Pose in 3DPW3D usw., sondern es kann auch beliebige Trainingsmodalitäten generieren und mehrere unterstützen Es wird eine feinkörnige und multimodale Generierung durchgeführt, und RGB-Bilder oder andere Modalitäten können durch die Verwendung anderer Modalitäten als Abfragen abgerufen werden. Darüber hinaus führten die Forscher auch multimodale Übertragungsexperimente zu NYUv2, der semantischen Segmentierung von Hypersim und ARKitScenes durch.

Zu seinen wichtigen Funktionsmerkmalen gehören:

Any-to-Any-Modalitäten: Von 7 Modalitäten des besten existierenden Any-to-Any-Modells auf 21 verschiedene Modalitäten erhöht, was modalübergreifenden Abruf, steuerbare Generierung und leistungsstarke Out-of-the-Box-Leistung ermöglicht.

Diversity-Unterstützung: Fügen Sie Unterstützung für strukturiertere Daten wie menschliche Posen, SAM-Instanzen, Metadaten und mehr hinzu.

Tokenisierung: Untersuchen Sie die diskrete Tokenisierung für verschiedene Modalitäten mithilfe modalitätsspezifischer Methoden, z. B. globaler Bildeinbettungen, menschlicher Posen und semantischer Instanzen.

Skalierung: Erweitern Sie die Modellgröße auf 3B Parameter und den Datensatz auf 0,5B Proben.

Kollaboratives Training: gemeinsames Training zum Sehen und zur Sprache zugleich.

Papieradresse: https://arxiv.org/pdf/2406.09406

Höhepunkte:

– Forscher von Apple und der Ecole Polytechnique Fédérale de Lausanne (EPFL) in der Schweiz haben gemeinsam ein einziges Any-to-Any-Modalitätsmodell entwickelt, das in 21 verschiedenen Modalitäten trainiert werden kann.

- Das Modell kann eine Reihe gängiger Sehaufgaben sofort ausführen und ist außerdem in der Lage, beliebige Trainingsmodalitäten zu generieren, wobei es mehrere Methoden zur Durchführung einer feinkörnigen und multimodalen Generierung unterstützt.

- Die Forscher führten auch multimodale Übertragungsexperimente zu NYUv2, der semantischen Segmentierung von Hypersim und ARKitScenes durch.

Insgesamt hat das 4M-21-Modell im Bereich der multimodalen Forschung erhebliche Fortschritte gemacht. Seine starke Leistung und seine breiten Anwendungsaussichten bieten eine neue Richtung für die zukünftige Entwicklung der multimodalen künstlichen Intelligenz. Es lohnt sich, auf die Open Source und zukünftige Anwendungen dieses Modells gespannt zu sein.