Forschungsteams der Nanjing-Universität, der Fudan-Universität und des Noah's Ark Laboratory von Huawei haben große Durchbrüche auf dem Gebiet der digitalen 3D-Menschen erzielt und die Probleme der unzureichenden Multi-View-Konsistenz und emotionalen Ausdruckskraft bestehender Methoden gelöst. Sie haben eine neue Methode entwickelt, die die Synthese sprechender 3D-Avatare mit kontrollierbaren Emotionen ermöglicht und deutliche Verbesserungen bei der Lippensynchronisation und der Wiedergabequalität erzielt. Die Forschungsergebnisse basieren auf dem neu erstellten EmoTalk3D-Datensatz, der kalibrierte Multi-View-Videos, emotionale Anmerkungen und bildweise 3D-Geometrieinformationen enthält und für nichtkommerzielle Forschungszwecke veröffentlicht wurde. Durch das Mapping-Framework „von der Sprache über die Geometrie bis zum Erscheinungsbild“ erfasst diese Methode subtile Gesichtsausdrücke präzise und erreicht eine hochauflösende Wiedergabe unter freien Betrachtungswinkeln.

Produkteingang: https://nju-3dv.github.io/projects/EmoTalk3D/

Sie sammelten den EmoTalk3D-Datensatz mit kalibrierten Multi-View-Videos, Emotionsanmerkungen und Frame-by-Frame-3D-Geometrie. Außerdem wird eine neue Methode zur Synthese sprechender 3D-Avatare mit kontrollierbaren Emotionen vorgeschlagen, mit erheblichen Verbesserungen bei der Lippensynchronisation und der Wiedergabequalität.

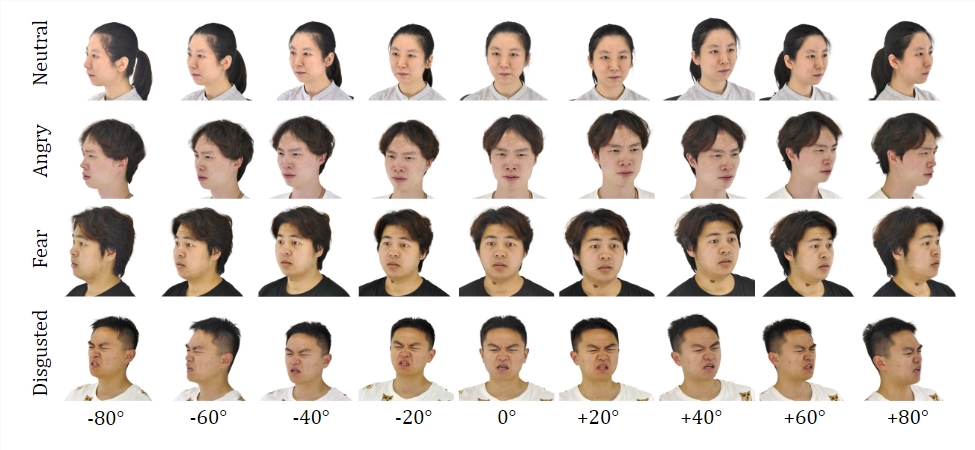

Datensatz:

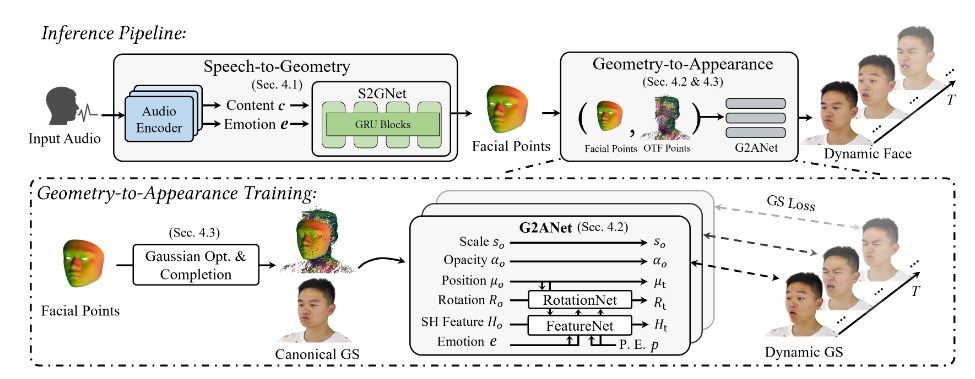

Durch Training am EmoTalk3D-Datensatz baute das Forschungsteam ein Mapping-Framework „von der Sprache über die Geometrie bis zum Erscheinungsbild“ auf. Eine realistische geometrische 3D-Sequenz wird zunächst anhand von Audiomerkmalen vorhergesagt, und dann wird das Erscheinungsbild eines 3D-sprechenden Kopfes, dargestellt durch eine 4D-Gauß-Funktion, basierend auf der vorhergesagten Geometrie synthetisiert. Die Erscheinungsbilder werden weiter in Standard- und dynamische Gauß-Funktionen zerlegt, aus Videos mit mehreren Ansichten gelernt und zusammengeführt, um Freiansicht-Animationen mit sprechenden Köpfen zu rendern.

Das Modell ermöglicht kontrollierbare Emotionen in generierten sprechenden Avataren und rendert sie aus einem breiten Blickwinkelbereich. Demonstrierte verbesserte Rendering-Qualität und Stabilität bei der Generierung von Lippenbewegungen bei gleichzeitiger Erfassung dynamischer Gesichtsdetails wie Falten und subtiler Ausdrücke. Im Beispiel der generierten Ergebnisse werden die glücklichen, wütenden und frustrierten Gesichtsausdrücke des 3D-Digitalmenschen genau dargestellt.

Der Gesamtprozess umfasst fünf Module:

Der erste ist ein Encoder zur Zerlegung emotionaler Inhalte, der Inhalte und emotionale Merkmale aus der Eingabesprache analysiert; der zweite ist ein Sprach-zu-Geometrie-Netzwerk, das dynamische 3D-Punktwolken aus Merkmalen vorhersagt; der dritte ist ein zu erstellendes Gaußsches Optimierungs- und Vervollständigungsmodul ein Standard-Erscheinungsbild; das vierte ist die Geometrie-zu-Erscheinungsbild-Animation. Das fünfte ist das Rendering-Modul, das dynamische Gaußsche Animationen darstellt.

Darüber hinaus erstellten sie den EmoTalk3D-Datensatz, einen mit Emotionen kommentierten Multi-View-Datensatz sprechender Köpfe mit bildweisen 3D-Gesichtsformen, der der Öffentlichkeit für nichtkommerzielle Forschungszwecke zur Verfügung gestellt wird.

Highlight:

Schlagen Sie eine neue Methode vor, um digitale Menschen mit kontrollierbaren Emotionen zu synthetisieren.

Erstellen Sie ein Mapping-Framework „von der Sprache über die Geometrie bis zum Erscheinungsbild“.

Der EmoTalk3D-Datensatz ist erstellt und kann geöffnet werden.

Diese Forschung gibt eine neue Richtung für die Entwicklung digitaler 3D-Menschentechnologie vor. Die vorgeschlagenen Methoden und Datensätze werden wertvolle Ressourcen für zukünftige Forschungen bereitstellen und die Entwicklung einer realistischeren und emotionaleren 3D-Menschentechnologie fördern. Die Öffnung des EmoTalk3D-Datensatzes fördert auch die Zusammenarbeit und den Austausch in der akademischen Gemeinschaft.