Meta hat kürzlich in aller Stille sechs wichtige KI-Forschungsergebnisse veröffentlicht, die mehrere Bereiche wie multimodale Modelle, textgenerierte Musik, Audio-Wasserzeichen-Technologie und Datensätze abdecken und damit seine kontinuierliche Innovation und technische Stärke im Bereich der künstlichen Intelligenz unter Beweis stellen. Diese Forschungsergebnisse bieten nicht nur neue Anwendungsmöglichkeiten im Bereich der KI, sondern liefern auch wertvolle Hinweise für zukünftige technologische Entwicklungsrichtungen. Diese beeindruckenden Forschungsergebnisse werden im Folgenden ausführlich beschrieben.

Vor Kurzem hat Meta in aller Stille sechs Forschungsergebnisse veröffentlicht, die neue Anwendungen und technologische Durchbrüche im Bereich der KI bringen. Dazu gehören multimodale Modelle, textgenerierte Musikmodelle, Audio-Wasserzeichen-Technologie, Datensätze und andere Projekte. Werfen wir einen Blick auf die konkreten Ergebnisse dieser Studien.

Meta-Chamäleon (Modell „Chamäleon“)

Erstens kann das veröffentlichte multimodale Modell „Chameleon“ Text und Bilder gleichzeitig verarbeiten, unterstützt gemischte Eingabe- und Ausgabetexte und bietet eine neue Lösung für die Verarbeitung multimodaler Daten.

Während die meisten aktuellen Fusionsmodelle im Spätstadium diffusionsbasiertes Lernen verwenden, verwendet Meta Chameleon die Tokenisierung für Text und Bilder. Dies ermöglicht einen einheitlicheren Ansatz und erleichtert das Entwerfen, Warten und Erweitern von Modellen.

Videobeispiele: Generieren Sie kreative Titel aus Bildern oder verwenden Sie eine Mischung aus Textaufforderungen und Bildern, um eine völlig neue Szene zu erstellen

Meta wird nun Schlüsselkomponenten der Modelle Chameleon7B und 34B im Rahmen einer Forschungslizenz öffentlich veröffentlichen. Das aktuell veröffentlichte Modell ist auf Sicherheit abgestimmt, unterstützt Mixed-Mode-Eingabe und Klartextausgabe und kann für Forschungszwecke verwendet werden. Der Beamte betonte, dass das Bilderzeugungsmodell Chameleon nicht veröffentlicht werde.

Produkteingang: https://top.aibase.com/tool/meta-chameleon

Multi-Token-Vorhersage

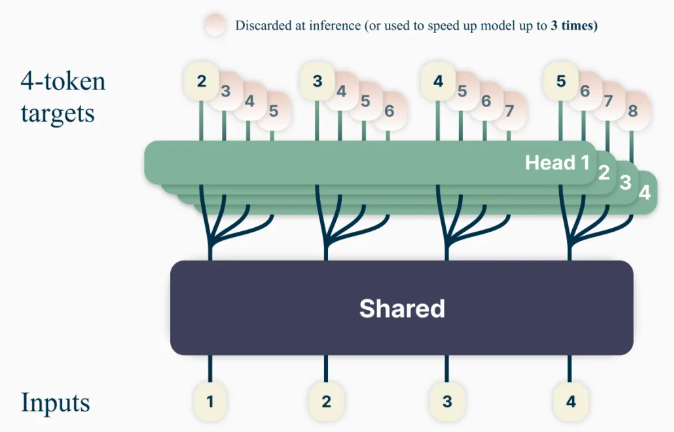

Die neue Sprachmodell-Trainingsmethode „Multi-Token Prediction“ zielt darauf ab, die Modellfähigkeiten und die Trainingseffizienz zu verbessern. Sie trainiert das Modell, mehrere Wörter gleichzeitig vorherzusagen und verbessert so die Vorhersagegenauigkeit des Modells.

Mithilfe dieses Ansatzes können Sprachmodelle darauf trainiert werden, mehrere zukünftige Wörter gleichzeitig vorherzusagen, anstatt wie bisher nur ein Wort nach dem anderen vorherzusagen. Dies verbessert die Modellfähigkeiten und die Trainingseffizienz und erhöht gleichzeitig die Geschwindigkeit. Im Sinne einer verantwortungsvollen offenen Wissenschaft werden vorab trainierte Modelle zur Code-Vervollständigung unter einer nichtkommerziellen/reine Forschungslizenz freigegeben.

Produkteingang: https://top.aibase.com/tool/multi-token-prediction

Musikmodell zur Textgenerierung „JASCO“

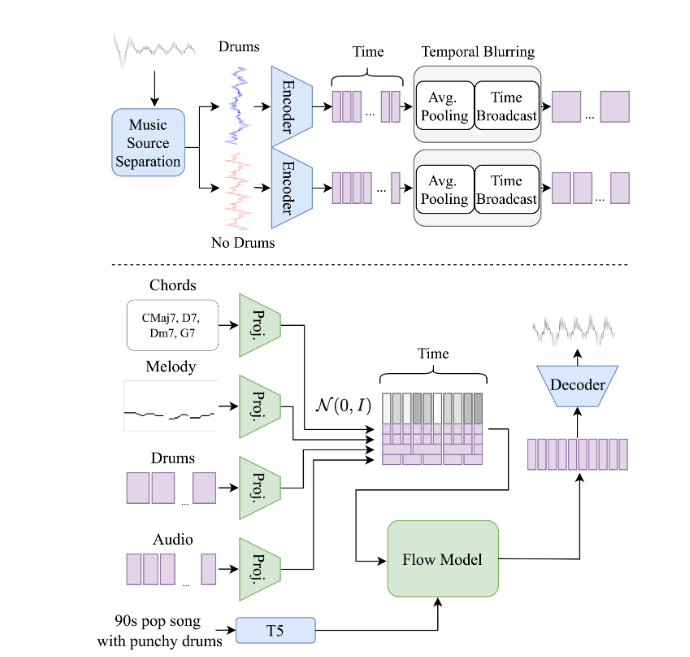

Während bestehende Text-to-Music-Modelle wie MusicGen in erster Linie auf Texteingaben zur Generierung von Musik basieren, ist Metas neues Modell Meta-Joint Audio and Symbol Conditioning for Temporally Controlled Text-to-Music Generation (JASCO) in der Lage, eine Vielfalt zu akzeptieren von Bedingungen Eingaben, wie z. B. bestimmte Akkorde oder Beats, um die Kontrolle über die resultierende musikalische Ausgabe zu verbessern. Insbesondere kann eine Informationsengpassschicht in Verbindung mit zeitlicher Unschärfe verwendet werden, um für bestimmte Steuerelemente relevante Informationen zu extrahieren. Dies ermöglicht die gleichzeitige Kombination symbolischer und audiobasierter Bedingungen im selben generativen Text-zu-Musik-Modell.

JASCO ist hinsichtlich der Generierungsqualität mit der Evaluierungsbasislinie vergleichbar und ermöglicht gleichzeitig eine bessere und flexiblere Kontrolle über die generierte Musik. Beamte werden Forschungsarbeiten und Beispielseiten veröffentlichen, und später in diesem Monat wird der Inferenzcode als Teil des AudioCraft-Repositorys unter der MIT-Lizenz veröffentlicht, und das vorab trainierte Modell wird unter CC-BY-NC veröffentlicht.

Code-Eingabe: https://top.aibase.com/tool/audiocraft

Audio-Wasserzeichen-Technologie „AudioSeal“

Dies ist die erste Audio-Wasserzeichentechnologie, die speziell für die lokale Erkennung von KI-generierter Sprache entwickelt wurde und eine präzise Lokalisierung von KI-generierten Segmenten in längeren Audioclips ermöglicht. AudioSeal verbessert herkömmliche Audio-Wasserzeichen, indem es sich auf die Erkennung von KI-generierten Inhalten und nicht auf Steganographie konzentriert.

Im Gegensatz zu herkömmlichen Methoden, die auf komplexen Dekodierungsalgorithmen basieren, ermöglicht der lokale Erkennungsansatz von AudioSeal eine schnellere und effizientere Erkennung. Dieses Design verbessert die Erkennungsgeschwindigkeit im Vergleich zu früheren Methoden um das 485-fache und eignet sich daher ideal für groß angelegte Echtzeitanwendungen. Unsere Methode erreicht Spitzenleistungen in Bezug auf Robustheit und Unwahrnehmbarkeit von Audio-Wasserzeichen.

AudioSeal wird unter einer kommerziellen Lizenz veröffentlicht.

Produkteingang: https://top.aibase.com/tool/audioseal

PRISM-Datensatz

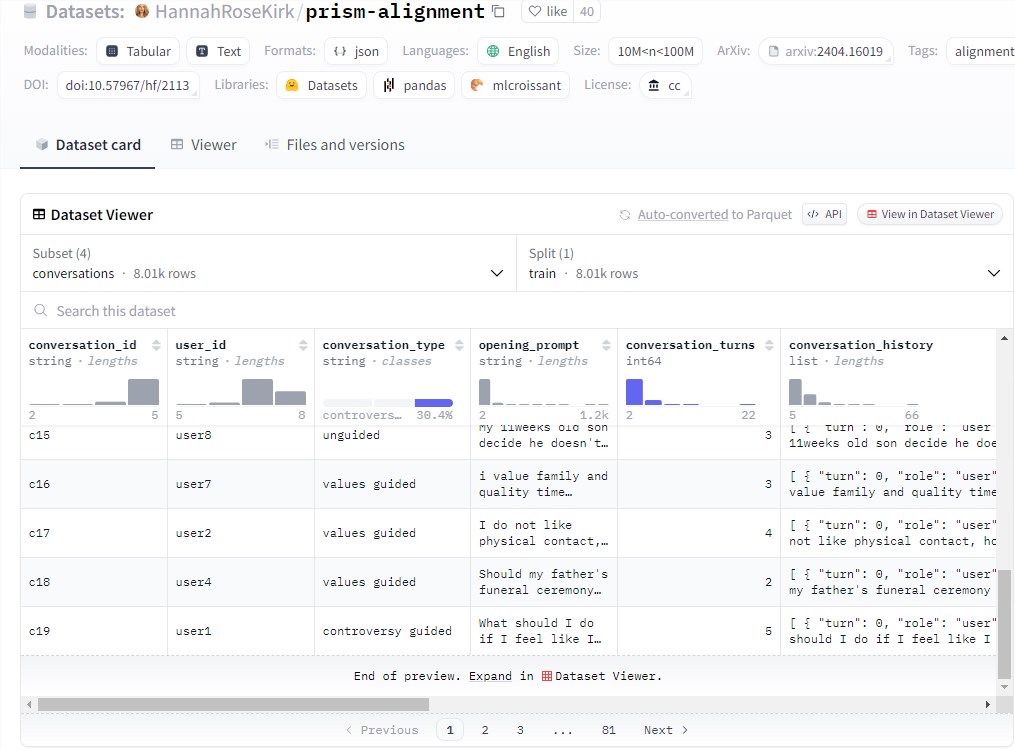

Gleichzeitig veröffentlichte Meta in Zusammenarbeit mit externen Partnern auch den PRISM-Datensatz, der die Dialogdaten und Präferenzen von 1.500 Teilnehmern auf der ganzen Welt enthält. Er wird zur Verbesserung groß angelegter Sprachmodelle und damit zur Verbesserung der Dialogvielfalt und -präferenzen verwendet Vielfalt und sozialer Nutzen des Modells.

Dieser Datensatz bildet die Vorlieben und das detaillierte Feedback jeder Person in 8.011 Echtzeitgesprächen mit 21 verschiedenen LLMs ab.

Datensatzeingang: https://huggingface.co/datasets/HannahRoseKirk/prism-alignment

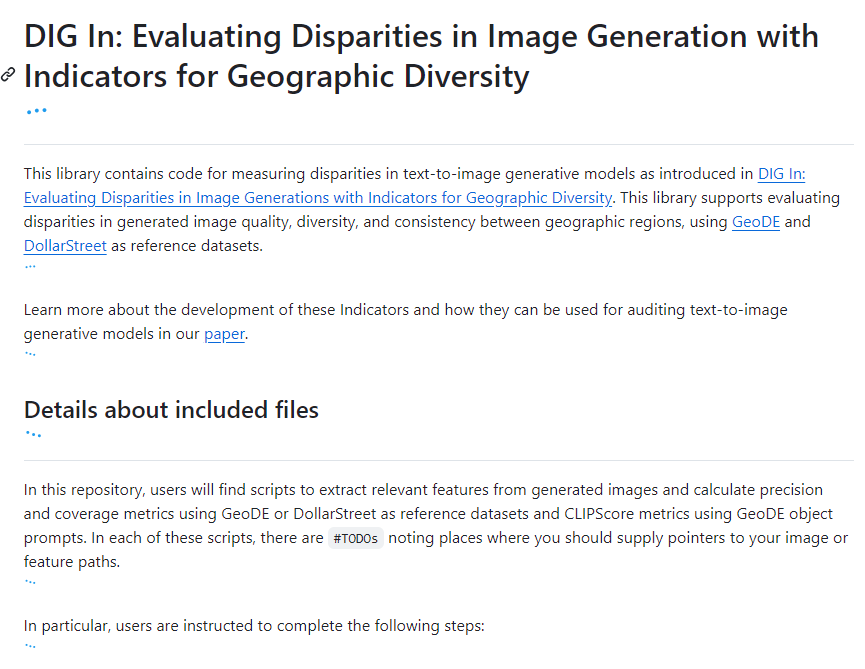

„DIG In“-Anzeige

Wird verwendet, um geografische Unterschiede in Bildmodellen zur Textgenerierung auszuwerten und mehr Referenzdaten für die Modellverbesserung bereitzustellen. Um zu verstehen, wie Menschen in verschiedenen Regionen die geografische Darstellung unterschiedlich sehen, führte Meta eine groß angelegte Annotationsstudie durch. Wir haben für jedes Beispiel über 65.000 Anmerkungen und über 20 Umfrageantworten gesammelt, die Attraktivität, Ähnlichkeit, Konsistenz und gemeinsame Empfehlungen abdecken, um die automatische und menschliche Bewertung von Text-zu-Bild-Modellen zu verbessern.

Code-Eingabe: https://top.aibase.com/tool/dig-in

Die Veröffentlichung dieser Projekte hat dem KI-Bereich neue technologische Durchbrüche und Anwendungsperspektiven beschert und ist von großer Bedeutung für die Förderung der Entwicklung und Anwendung der KI-Technologie.

Insgesamt belegen die sechs diesmal von Meta veröffentlichten KI-Forschungsergebnisse seine führende Technologie und sein zukunftsweisendes Layout in den Bereichen Multimodalität, Textgenerierung, Audioverarbeitung und Datensatzkonstruktion. Fortschritte in diesen Technologien werden die weitere Entwicklung im Bereich der KI vorantreiben und mehr Möglichkeiten für zukünftige Anwendungen bringen.