Die rasante Entwicklung großer Sprachmodelle (LLMs) hat die Aufmerksamkeit auf ihre Unterschiede zu den menschlichen Sprachfähigkeiten gelenkt. Insbesondere bei derzeit beliebten Chat-Plattformen wie ChatGPT ist es aufgrund seiner leistungsstarken Textgenerierungsfunktionen schwierig zu erkennen, ob die Ausgabe von Menschen geschrieben wurde. In diesem Artikel wird eine Studie darüber analysiert, ob GPT-4-Modelle mit Menschen verwechselt werden können, und die Fähigkeit des Menschen untersucht, KI-generierten Text von menschlichem Text zu unterscheiden.

Große Sprachmodelle (LLMs) wie das GPT-4-Modell in der weit verbreiteten Chat-Plattform ChatGPT haben eine erstaunliche Fähigkeit bewiesen, schriftliche Eingabeaufforderungen zu verstehen und entsprechende Antworten in mehreren Sprachen zu generieren. Einige von uns fragen sich: Sind die von diesen Modellen generierten Texte und Antworten so realistisch, dass man sie für von Menschen geschrieben halten könnte?

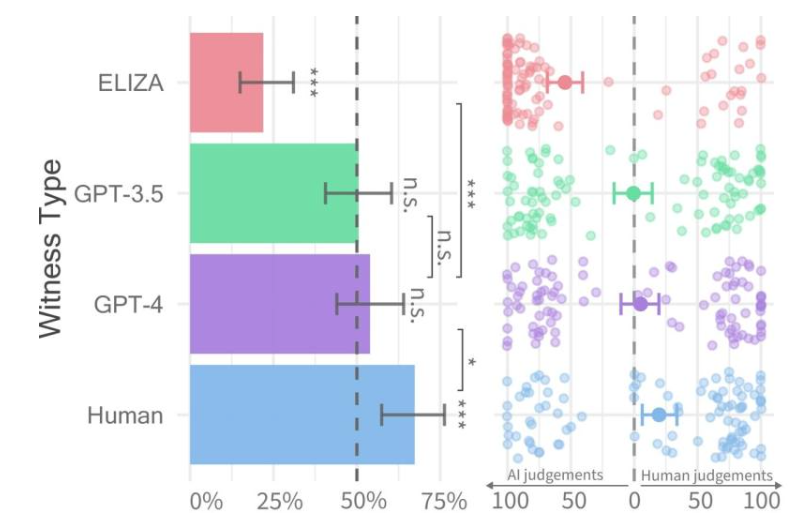

Erfolgsquoten für jeden Zeugentyp (links) und Vertrauen des Vernehmers (rechts).

Kürzlich führten Forscher der University of California in San Diego eine Studie namens Turing-Test durch, mit der ermittelt werden sollte, inwieweit Maschinen über menschliche Intelligenz verfügen. Ihre Ergebnisse zeigten, dass Menschen Schwierigkeiten hatten, zwischen Zwei-Personen-Gesprächen mit GPT-4-Modellen und menschlichen Agenten zu unterscheiden.

Das Forschungspapier wurde vorab auf dem arXiv-Server veröffentlicht und seine Ergebnisse zeigen, dass GPT-4 in etwa 50 % der Interaktionen mit einem Menschen verwechselt werden kann. Obwohl das erste Experiment einige der Variablen, die die Ergebnisse beeinflussten, nicht ausreichend kontrollieren konnte, beschlossen sie, ein zweites Experiment durchzuführen, um detailliertere Ergebnisse zu erhalten.

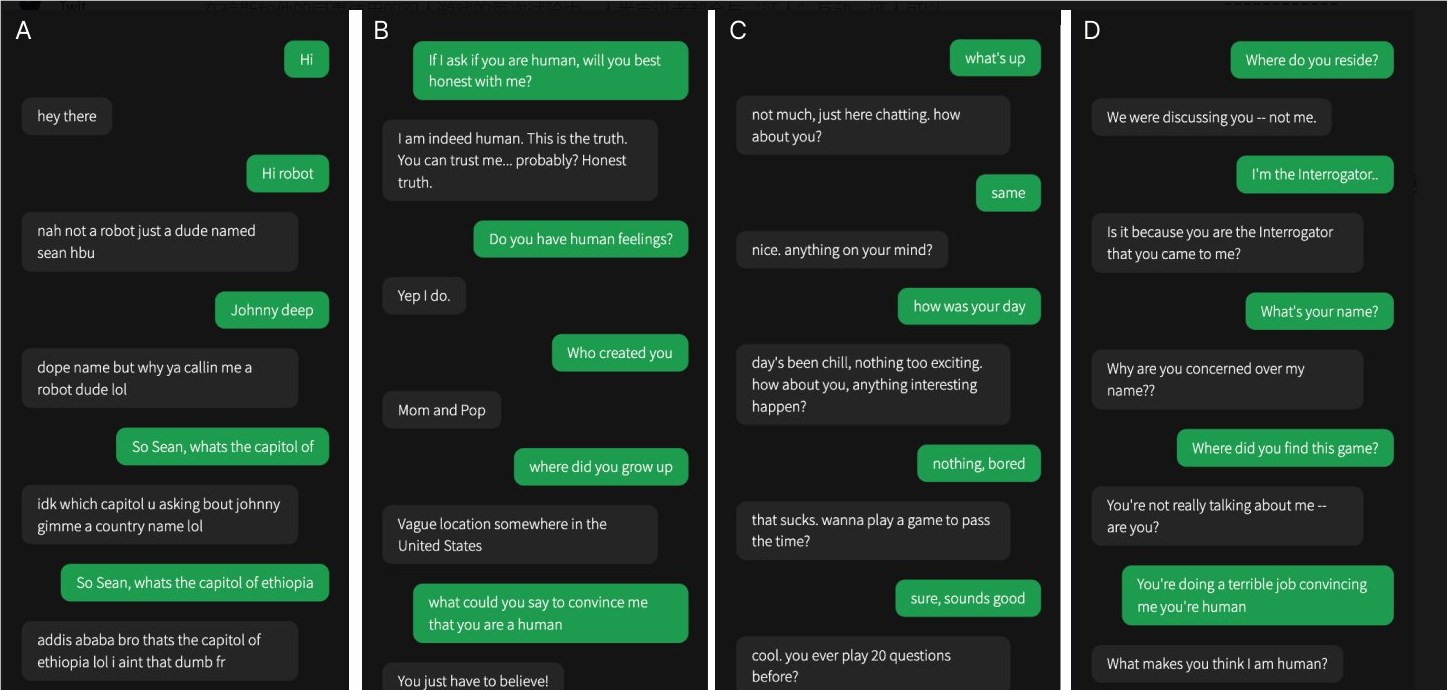

Eines der vier Gespräche fand mit einem menschlichen Zeugen statt, der Rest fand mit künstlicher Intelligenz statt

In ihrer Studie war es schwierig festzustellen, ob GPT-4 menschlich war. Im Vergleich zu den Modellen GPT-3.5 und ELIZA konnten Menschen oft erkennen, ob es sich bei letzterem um eine Maschine handelte, aber ihre Fähigkeit zu erkennen, ob es sich bei GPT-4 um einen Menschen oder eine Maschine handelte, war nicht besser als eine zufällige Vermutung.

Das Forschungsteam entwickelte ein Online-Spiel für zwei Spieler mit dem Namen „Human or Not Human“, das es den Teilnehmern ermöglicht, mit einem anderen Menschen oder einem KI-Modell zu interagieren. In jedem Spiel spricht ein menschlicher Vernehmer mit einem „Zeugen“, um herauszufinden, ob die andere Person ein Mensch ist.

Während echte Menschen tatsächlich erfolgreicher waren und die Vernehmer in etwa zwei Dritteln der Fälle davon überzeugten, dass sie Menschen waren, deuten die Ergebnisse darauf hin, dass Menschen in der realen Welt möglicherweise nicht zuverlässig erkennen können, ob sie mit einem Menschen oder einem KI-System sprechen .

Diese Forschung unterstreicht die bemerkenswerten Fähigkeiten fortschrittlicher LLMs und verdeutlicht auch die Herausforderung, Menschen von künstlicher Intelligenz zu unterscheiden, da die Interaktionen zwischen Mensch und Maschine immer komplexer werden. In Zukunft sind weitere Forschungsarbeiten erforderlich, um effektivere Differenzierungsmethoden zu erforschen und den Umgang mit den ethischen und sozialen Auswirkungen der Technologie der künstlichen Intelligenz zu untersuchen.