Ein Forschungsteam der Universität Nanjing arbeitete mit ByteDance und der Southwest University zusammen, um eine innovative Video-Superauflösungstechnologie namens STAR auf den Markt zu bringen. Diese Technologie kombiniert geschickt räumlich-zeitliche Verbesserungsmethoden und Text-zu-Video-Modelle, wodurch die Klarheit von Videos mit niedriger Auflösung, insbesondere von Videos, die von Videoplattformen heruntergeladen werden, erheblich verbessert werden kann. Die vorab trainierte Version des STAR-Modells wurde für Forscher und Entwickler als Open Source auf GitHub bereitgestellt. Dies stellt einen wichtigen Durchbruch im Bereich der Videoverarbeitung dar. Das Projekt bietet zwei Modelle, I2VGen-XL und CogVideoX-5B, und unterstützt mehrere Eingabeformate und Eingabeaufforderungsoptionen, um unterschiedlichen Anforderungen gerecht zu werden.

Um Forschern und Entwicklern die Arbeit zu erleichtern, hat das Forschungsteam die vorab trainierte Version des STAR-Modells auf GitHub veröffentlicht, einschließlich zweier Modelle, I2VGen-XL und CogVideoX-5B, sowie zugehörigem Inferenzcode. Die Einführung dieser Tools stellt einen wichtigen Fortschritt im Bereich der Videoverarbeitung dar.

Die Verwendung dieses Modells ist relativ einfach. Zunächst müssen Benutzer das vorab trainierte STAR-Modell von HuggingFace herunterladen und im angegebenen Verzeichnis ablegen. Bereiten Sie als Nächstes die zu testende Videodatei vor und wählen Sie die entsprechenden Textaufforderungsoptionen aus, einschließlich „keine Aufforderungen“, automatisch generierte oder manuell eingegebene Aufforderungen. Benutzer müssen lediglich die Pfadeinstellungen im Skript anpassen, um Videos mit Superauflösung problemlos verarbeiten zu können.

Dieses Projekt hat speziell zwei auf I2VGen-XL basierende Modelle entwickelt, die für unterschiedliche Grade der Videodegradationsverarbeitung verwendet werden, um sicherzustellen, dass sie eine Vielzahl von Anforderungen erfüllen können. Darüber hinaus unterstützt das Modell CogVideoX-5B speziell das Eingabeformat 720x480 und bietet so flexible Optionen für bestimmte Szenarien.

Diese Forschung liefert nicht nur neue Ideen für die Entwicklung der Video-Super-Resolution-Technologie, sondern eröffnet auch neue Forschungsrichtungen für Forscher in verwandten Bereichen. Das Forschungsteam bedankt sich bei Spitzentechnologien wie I2VGen-XL, VEnhancer, CogVideoX und OpenVid-1M, die ihrer Meinung nach den Grundstein für ihr Projekt gelegt haben.

Projekteingang: https://github.com/NJU-PCALab/STAR

Höhepunkte:

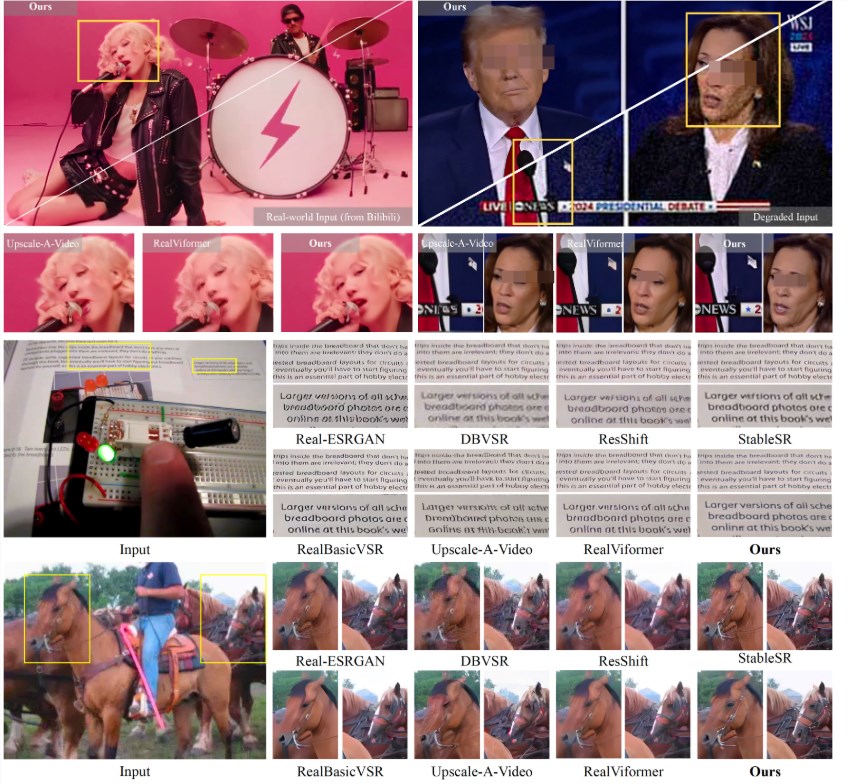

Die neue Technologie STAR kombiniert Text-zu-Video-Modelle, um eine Video-Superauflösung zu erreichen und die Videoqualität zu verbessern.

Das Forschungsteam hat vorab trainierte Modelle und Inferenzcodes veröffentlicht, und der Nutzungsprozess ist einfach und klar.

Geben Sie Kontaktinformationen an, um Benutzer zur Kommunikation und Diskussion mit dem Forschungsteam zu ermutigen.

Das STAR-Projekt ist Open Source über GitHub und erleichtert Entwicklern und Forschern die Nutzung. Sein einfacher und benutzerfreundlicher Bedienungsprozess und seine leistungsstarken Funktionen eröffnen neue Möglichkeiten im Bereich der Video-Superauflösung und bieten neue Richtungen für zukünftige Forschung . Wir freuen uns darauf, dass die STAR-Technologie in der Praxis eine größere Rolle spielt.