Mit der rasanten Entwicklung multimodaler großer Sprachmodelle (MLLM) ist die effektive Integration visueller, sprachlicher und sprachlicher Modalitäten zu einem Forschungsschwerpunkt geworden. Allerdings behindern die Herausforderungen, die sich aus den wesentlichen Unterschieden in verschiedenen modalen Daten ergeben, wie z. B. den räumlichen Informationen des Sehens und den Zeitreiheninformationen der Sprache, einer effizienten multimodalen Interaktion. Bestehende Methoden basieren häufig auf unabhängigen ASR- und TTS-Modulen, was die Latenz erhöht und die reibungslose Interaktion verringert. In diesem Artikel wird VITA-1.5 vorgestellt, ein multimodales Sprachmodell in großem Maßstab, das Vision, Sprache und Sprache integriert und darauf abzielt, diese Probleme zu lösen.

In jüngster Zeit wurden erhebliche Fortschritte bei multimodalen großen Sprachmodellen (MLLM) erzielt, insbesondere bei der Integration visueller und textueller Modalitäten. Mit der zunehmenden Beliebtheit der Mensch-Computer-Interaktion ist jedoch die Bedeutung von Sprachmodalitäten immer wichtiger geworden, insbesondere in multimodalen Dialogsystemen. Sprache ist nicht nur ein zentrales Medium zur Informationsübertragung, sondern verbessert auch die Natürlichkeit und den Komfort von Interaktionen erheblich.

Aufgrund der wesentlichen Unterschiede zwischen visuellen und sprachlichen Daten ist deren Integration in MLLM jedoch nicht trivial. Visuelle Daten vermitteln beispielsweise räumliche Informationen, während Sprachdaten dynamische Änderungen in Zeitreihen vermitteln. Diese grundlegenden Unterschiede stellen die gleichzeitige Optimierung der beiden Modalitäten vor Herausforderungen und führen häufig zu Konflikten während des Trainingsprozesses. Darüber hinaus basieren herkömmliche Speech-to-Speech-Systeme auf separaten Modulen für automatische Spracherkennung (ASR) und Text-to-Speech (TTS), was die Latenz erhöht und die Kohärenz verringert, was ihren Nutzen in Echtzeitanwendungen einschränkt.

Um diese Herausforderungen anzugehen, haben Forscher VITA-1.5 ins Leben gerufen, ein multimodales Sprachmodell im großen Maßstab, das Sehen, Sprache und Sprache integriert. VITA-1.5 verwendet eine sorgfältig entwickelte dreistufige Trainingsmethode, um nach und nach visuelle und sprachliche Daten einzuführen, um modale Konflikte zu lindern und gleichzeitig eine starke multimodale Leistung aufrechtzuerhalten.

In der ersten Phase konzentriert sich das Modell auf das visuell-linguistische Training, den Aufbau starker visueller Fähigkeiten durch das Training visueller Adapter und die Feinabstimmung des Modells mithilfe beschreibender Bildunterschriften und visueller Frage- und Antwortdaten.

In der zweiten Stufe wird die Verarbeitung von Audioeingaben eingeführt, indem der Audio-Encoder mithilfe gepaarter Sprachtranskriptionsdaten trainiert und anschließend mithilfe von Sprachfrage- und Antwortdaten verfeinert wird, sodass das Modell die Audioeingabe effektiv verstehen und darauf reagieren kann. In der dritten Stufe schließlich wird der Audiodecoder darauf trainiert, eine durchgängige Sprachausgabe zu erreichen, ohne dass externe TTS-Module erforderlich sind. Dadurch kann VITA-1.5 flüssige Sprachantworten generieren und die Natürlichkeit und Interaktivität multimodaler Dialoge verbessern Systeme.

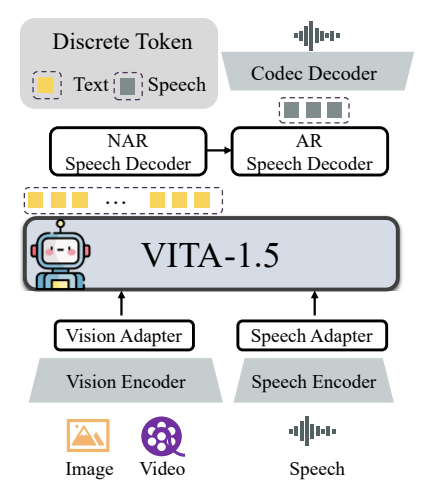

Die Gesamtarchitektur von VITA-1.5 umfasst visuelle und akustische Encoder und Adapter zur Verbindung mit großen Sprachmodellen. Die Ausgabe verfügt über ein End-to-End-Sprachgenerierungsmodul, anstatt ein externes TTS-Modell wie die ursprüngliche VITA-1.0-Version zu verwenden. Der visuelle Encoder verwendet InternViT-300M, die Eingabebildgröße beträgt 448 x 448 Pixel und jedes Bild generiert 256 visuelle Token.

Für hochauflösende Bilder wendet VITA-1.5 eine dynamische Patching-Strategie an, um lokale Details zu erfassen. Video wird als spezieller Mehrbild-Eingabetyp behandelt, wobei die Frames auf der Grundlage der Länge des Videos abgetastet werden. Das Audiokodierungsmodul besteht aus mehreren Downsampling-Faltungsschichten und 24 Transformer-Blöcken mit einer Ausgangsbildrate von 12,5 Hz. Der Audioadapter besteht aus mehreren Faltungsschichten mit 2-fachem Downsampling. Als Codec-Modell kommt TiCodec zum Einsatz, der ein kontinuierliches Sprachsignal in diskrete Sprachtokens mit einer Frequenz von 40 Hz kodiert und diese wieder in ein Sprachsignal mit einer Abtastrate von 24.000 Hz dekodieren kann. Damit das Modell Sprachtokens ausgeben kann, werden nach den Texttokens zwei Sprachdecoder hinzugefügt: ein nicht-autoregressiver (NAR) Sprachdecoder und ein autoregressiver (AR) Sprachdecoder.

Die Trainingsdaten von VITA-1.5 decken ein breites Spektrum an Kategorien ab, beispielsweise Untertiteldaten sowie Frage- und Antwortdaten, einschließlich Chinesisch und Englisch. In verschiedenen Trainingsphasen werden Teilmengen des gesamten Datensatzes selektiv abgetastet, um unterschiedliche Ziele zu erreichen. Die Trainingsstrategie erfolgt in drei Phasen:

Die erste Stufe: visuell-linguistisches Training, einschließlich visueller Ausrichtung, visuellem Verständnis und visuell überwachter Feinabstimmung, zielt darauf ab, die Lücke zwischen Vision und Sprache zu schließen und das Modell in die Lage zu versetzen, Bildinhalte zu verstehen und visuelle Fragen zu beantworten.

Phase 2: Die Abstimmung des Audioeingangs, einschließlich Audioausrichtung und audioüberwachter Feinabstimmung, soll es dem Modell ermöglichen, den Audioeingang zu verstehen und über Sprachfragen und Textantworten zu interagieren.

Die dritte Stufe: Die Abstimmung der Audioausgabe, einschließlich Codec-Training und NAR + AR-Decoder-Training, soll es dem Modell ermöglichen, eine Sprachausgabe zu generieren und eine durchgängige Sprachinteraktion zu erreichen.

Die Forscher führten eine umfassende Auswertung verschiedener Benchmarks für das Bild-, Video- und Sprachverständnis durch und verglichen die Ergebnisse mit Open-Source- und proprietären Modellen. Die Ergebnisse zeigen, dass VITA-1.5 vergleichbare Wahrnehmungs- und Argumentationsfähigkeiten wie das führende MLLM bei Bild- und Videoaufgaben aufweist und erhebliche Verbesserungen der Sprachfähigkeiten erzielt. Beim Bildverständnis-Benchmark schneidet VITA-1.5 beispielsweise auf Augenhöhe mit modernsten Open-Source-Modellen ab und übertrifft sogar einige Closed-Source-Modelle. In Bezug auf das Videoverständnis liegt VITA-1.5 auf Augenhöhe mit Top-Open-Source-Modellen. Darüber hinaus erreichte VITA-1.5 sowohl bei chinesischen als auch bei englischen ASR-Aufgaben eine führende Genauigkeit und übertraf damit professionelle Sprachmodelle.

Insgesamt integriert VITA-1.5 durch eine sorgfältig konzipierte dreistufige Trainingsstrategie erfolgreich Sehen und Sprache, wodurch starke visuelle und sprachliche Verständnisfähigkeiten erreicht werden und eine effiziente Sprache-zu-Sprache-Interaktion ermöglicht wird, ohne auf ein separates ASR- oder TTS-Modul angewiesen zu sein. Von dieser Forschung wird erwartet, dass sie die Weiterentwicklung von Open-Source-Modellen im Bereich der multimodalen Interaktion in Echtzeit fördert.

Projektadresse: https://github.com/VITA-MLLM/VITA

Das Erscheinen von VITA-1.5 markiert eine neue Stufe in der Entwicklung multimodaler Sprachmodelle im großen Maßstab. Seine durchgängigen Sprachgenerierungsfunktionen und die hervorragende Leistung bei Bild-, Video- und Sprachverständnisaufgaben sorgen für einen natürlicheren und reibungsloseren Aufbau Multimodales Sprachmodell für die Zukunft. Dynamische interaktive Systeme bieten neue Möglichkeiten. Dieses Forschungsergebnis verdient Aufmerksamkeit und wird voraussichtlich eine wichtige Rolle in der praktischen Anwendung spielen.