Das neueste von ByteDance veröffentlichte LatentSync-Lippensynchronisations-Framework verwendet das audiobedingte latente Diffusionsmodell basierend auf Stable Diffusion, um einen genaueren und effizienteren Lippensynchronisationseffekt zu erzielen. Anders als frühere Methoden verfolgt LatentSync einen End-to-End-Ansatz, um die komplexe Beziehung zwischen Audio und Bild direkt zu modellieren, ohne dass eine Zwischenbewegungsdarstellung erforderlich ist, was die Verarbeitungseffizienz und Synchronisierungsgenauigkeit erheblich verbessert. Dieses Framework nutzt Whisper geschickt für die Audioeinbettung und kombiniert es mit dem TREPA-Mechanismus, um die zeitliche Konsistenz zu verbessern und sicherzustellen, dass das Ausgabevideo die zeitliche Kohärenz beibehält und gleichzeitig die Genauigkeit der Lippensynchronisation beibehält.

Vor kurzem hat ByteDance ein neues Lippensynchronisations-Framework namens LatentSync veröffentlicht, das darauf abzielt, das latente Diffusionsmodell des Audiozustands zu verwenden, um eine genauere Lippensynchronisation zu erreichen. Das Framework basiert auf Stable Diffusion und ist auf Zeitkonsistenz optimiert.

Im Gegensatz zu früheren Methoden, die auf räumlicher Pixeldiffusion oder zweistufiger Erzeugung basieren, verfolgt LatentSync einen End-to-End-Ansatz ohne die Notwendigkeit einer zwischengeschalteten Bewegungsdarstellung und kann komplexe audiovisuelle Beziehungen direkt modellieren.

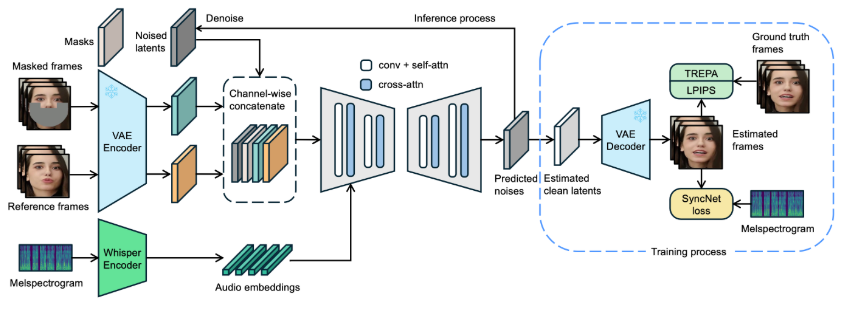

Im Rahmen von LatentSync wird Whisper zunächst dazu verwendet, Audiospektrogramme in Audioeinbettungen umzuwandeln und über Cross-Attention-Layer in das U-Net-Modell zu integrieren. Das Framework führt eine Verkettung von Referenzrahmen und Maskenrahmen auf Kanalebene mit latenten Rauschvariablen als Eingabe für U-Net durch.

Während des Trainings wird ein einstufiger Ansatz verwendet, um saubere latente Variablen aus dem Vorhersagerauschen zu schätzen und dann zu dekodieren, um saubere Frames zu generieren. Gleichzeitig führt das Modell den TREPA-Mechanismus (Temporal REPresentation Alignment) ein, um die zeitliche Konsistenz zu verbessern und sicherzustellen, dass das generierte Video die zeitliche Kohärenz beibehält und gleichzeitig die Genauigkeit der Lippensynchronisation beibehält.

Um die Wirksamkeit dieser Technologie zu demonstrieren, stellt das Projekt eine Reihe von Beispielvideos zur Verfügung, die das Originalvideo und das lippensynchrone Video zeigen. Anhand von Beispielen können Benutzer intuitiv den erheblichen Fortschritt von LatentSync bei der Video-Lippensynchronisation spüren.

Originalvideo:

Ausgabevideo:

Darüber hinaus plant das Projekt auch, den Inferenzcode und die Prüfpunkte als Open Source bereitzustellen, um Benutzern Schulungen und Tests zu erleichtern. Für Benutzer, die Inferenz ausprobieren möchten, laden Sie einfach die erforderlichen Modellgewichtsdateien herunter und schon kann es losgehen. Außerdem wurde ein vollständiger Datenverarbeitungsprozess entwickelt, der jeden Schritt von der Videodateiverarbeitung bis zur Gesichtsausrichtung abdeckt, um sicherzustellen, dass Benutzer problemlos loslegen können.

Modellprojekteingang: https://github.com/bytedance/LatentSync

Höhepunkte:

LatentSync ist ein End-to-Port-Synchronisations-Framework, das auf dem audiobedingten latenten Diffusionsmodell basiert, ohne dass zwischenzeitliche Bewegungsdarstellungen erforderlich sind.

Das Framework nutzt Whisper, um Audiospektrogramme in Einbettungen umzuwandeln, was die Genauigkeit und zeitliche Konsistenz des Modells während der Lippensynchronisation verbessert.

Das Projekt stellt eine Reihe von Beispielvideos bereit und plant, relevante Codes und Datenverarbeitungsprozesse als Open Source bereitzustellen, um die Nutzung und Schulung der Benutzer zu erleichtern.

Die offene Quelle und Benutzerfreundlichkeit von LatentSync wird die weitere Entwicklung und Anwendung der Lippensynchronisationstechnologie vorantreiben und neue Möglichkeiten für die Bereiche Videobearbeitung und Inhaltserstellung eröffnen. Ich freue mich auf zukünftige Updates dieses Projekts, die weitere Überraschungen bringen werden.