Ai2, eine gemeinnützige Forschungsorganisation für künstliche Intelligenz, hat sein neues Open-Language-Modell der OLMo2-Serie veröffentlicht. Dabei handelt es sich um das Produkt der zweiten Generation der OLMo-Serie. Seine vollständig Open-Source-Codefunktionen stellen den neuesten Fortschritt im Bereich der Open-Source-KI dar. OLMo2 hält sich strikt an die Definition der Open Source Initiative und alle Trainingsdaten, Tools und Codes sind öffentlich verfügbar, was in scharfem Gegensatz zu anderen Sprachmodellen steht, die behaupten, „offen“ zu sein, aber nicht vollständig Open Source sind. Der Schritt von Ai2 zielt darauf ab, die Innovation und Entwicklung der Open-Source-Community zu fördern und globalen Entwicklern eine leistungsstarke Plattform für technischen Support und die gemeinsame Nutzung von Ressourcen bereitzustellen.

Im Gegensatz zu anderen derzeit auf dem Markt erhältlichen „offenen“ Sprachmodellen wie der Llama-Reihe von Meta erfüllt OLMo2 die strenge Definition der Open Source Initiative, was bedeutet, dass die für seine Entwicklung verwendeten Trainingsdaten, Tools und Codes öffentlich und für jedermann zugänglich sind verwenden. Gemäß der Definition der Open Source Initiative erfüllt OLMo2 die Anforderungen der Organisation an einen „Open Source AI“-Standard, der im Oktober dieses Jahres fertiggestellt wurde.

Ai2 erwähnte in seinem Blog, dass während des Entwicklungsprozesses von OLMo2 alle Trainingsdaten, Codes, Trainingspläne, Bewertungsmethoden und Zwischenkontrollpunkte vollständig offen waren, mit dem Ziel, Innovation und Entdeckung in der Open-Source-Community durch gemeinsame Ressourcen zu fördern. „Durch die offene Weitergabe unserer Daten, Lösungen und Erkenntnisse hoffen wir, der Open-Source-Community die Ressourcen zur Verfügung zu stellen, um neue Methoden und innovative Technologien zu entdecken.“

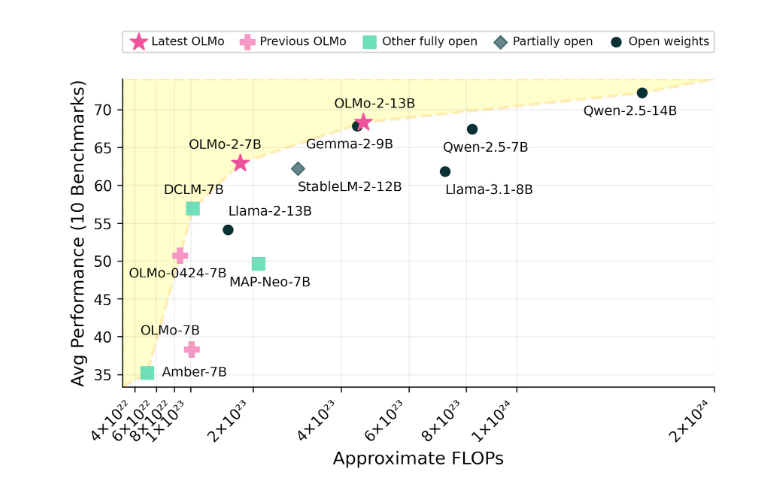

Die OLMo2-Serie umfasst zwei Versionen: eine ist OLMo7B mit 7 Milliarden Parametern und die andere ist OLMo13B mit 13 Milliarden Parametern. Die Anzahl der Parameter wirkt sich direkt auf die Leistung des Modells aus, und Versionen mit mehr Parametern können in der Regel komplexere Aufgaben bewältigen. OLMo2 schnitt bei allgemeinen Textaufgaben gut ab und konnte Aufgaben wie das Beantworten von Fragen, das Zusammenfassen von Dokumenten und das Schreiben von Code erledigen.

Um OLMo2 zu trainieren, verwendete Ai2 einen Datensatz mit fünf Billionen Token. Token ist die kleinste Einheit im Sprachmodell. 1 Million Token entsprechen ungefähr 750.000 Wörtern. Die Trainingsdaten umfassen Inhalte von hochwertigen Websites, wissenschaftlichen Arbeiten, Frage-und-Antwort-Diskussionsforen und Arbeitsbüchern zur synthetischen Mathematik und werden sorgfältig ausgewählt, um die Effizienz und Genauigkeit des Modells sicherzustellen.

Ai2 ist von der Leistung von OLMo2 überzeugt und behauptet, dass es hinsichtlich der Leistung mit Open-Source-Modellen wie Metas Llama3.1 konkurriert. Ai2 wies darauf hin, dass die Leistung von OLMo27B sogar Llama3.18B übertraf und zu einem der derzeit stärksten vollständig offenen Sprachmodelle wurde. Alle OLMo2-Modelle und ihre Komponenten können kostenlos über die offizielle Ai2-Website heruntergeladen werden und folgen der Apache2.0-Lizenz, was bedeutet, dass diese Modelle nicht nur für Forschungszwecke, sondern auch für kommerzielle Anwendungen verwendet werden können.

Die Open-Source-Funktionen von OLMo2 und seine hervorragende Leistung haben der Entwicklung des Bereichs der künstlichen Intelligenz neue Möglichkeiten eröffnet und der Open-Source-Community neue Dynamik verliehen. Es lohnt sich, auf die zukünftige Entwicklung und Anwendungen zu blicken.