Der neueste Multi-IF-Benchmark-Test von META zielt darauf ab, die Anweisungen von großsprachigen Modellen (LLM) in mehreren Runden des Dialogs und der Mehrsprachumgebung umfassendere zu bewerten. Anders als die Bewertungskriterien für mehr Aufmerksamkeit in der Vergangenheit deckt Multi-IF acht Sprachen ab, darunter 4501 dreirädrige Dialogaufgaben, und bemüht sich, die Komplexität realer Anwendungsszenarien zu simulieren und eine strengere und schwierigere Bewertung der LLM-Bewertung zu ermöglichen . Die Ergebnisse dieses Benchmark -Tests zeigten die vielen Mängel des aktuellen Dialogs und der Mehrfach -Spritzer -Aufgaben des aktuellen LLM und lieferten wertvolle Referenzen für die Verbesserungsrichtung zukünftiger Modelle.

Meta hat kürzlich einen neuen Benchmark-Test namens Multi-IF veröffentlicht, der darauf abzielt, die Fähigkeit des großen Sprachmodells (LLM) in mehreren Dialog- und Multisprach-Umgebungen zu bewerten. Dieser Benchmark deckt acht Sprachen ab, darunter 4501 Dialogaufgaben mit drei Wellen, die sich auf die Leistung des aktuellen Modells in komplexen Mehrfach- und Multi -Sprung -Szenarien konzentrieren.

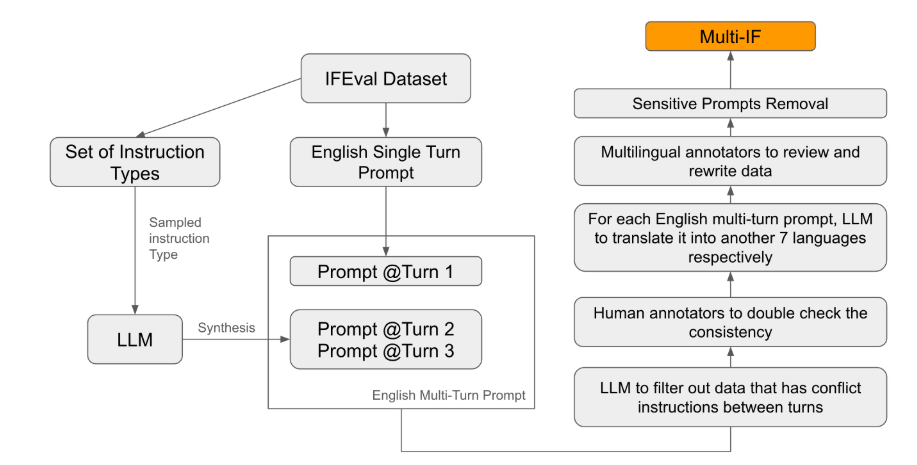

In den vorhandenen Bewertungsstandards konzentrieren sich die meisten auf einen einzelnen Waden -Dialog und eine einzelne Aufgaben, was die Leistung von Modellen in praktischen Anwendungen schwer widerspiegelt. Der Start von Multi-IF besteht darin, diese Lücke zu schließen. Das Forschungsteam generiert komplexe Dialogszenen, indem ein einzelner Wadenanweis in mehrere Anweisungen ausgedehnt wird, und stellt sicher, dass jede Anweisungsrunde logisch kohärent und progressiv ist. Darüber hinaus erreichte der Datensatz durch automatische Übersetzung und künstliche Schule -to -Peer -Schritte auch Multi -Language -Unterstützung.

Die experimentellen Ergebnisse zeigten, dass die meisten LLM -Leistung in mehreren Dialogrunden signifikant zurückging. Als Beispiel als Beispiel betrug die durchschnittliche Genauigkeit in der ersten Runde 87,7%, jedoch in der dritten Runde auf 70,7%. Insbesondere in der Sprache von Nicht -Latin wie Indianer, Russisch und Chinesisch ist die Leistung des Modells im Allgemeinen niedriger als Englisch und zeigt die Einschränkungen von Aufgaben mit mehreren Sprachen.

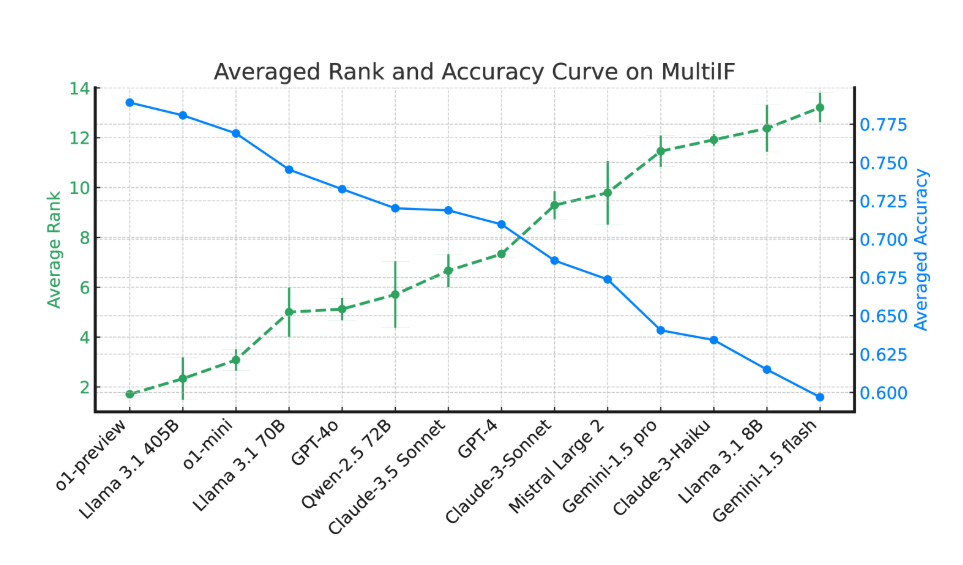

Bei der Bewertung von 14 hochmodernen Sprachmodellen leisteten O1-Präview und Lama3.1405b die beste Leistung, und die durchschnittliche Genauigkeit von Anweisungen mit drei Wellen betrug 78,9% bzw. 78,1%. In mehreren Dialogrunden folgen die Anweisungen aller Modelle jedoch dem allgemeinen Rückgang, was die Herausforderungen des Modells in komplexen Aufgaben widerspiegelt. Das Forschungsteam führte auch die "Anweisungsvergassungsrate" (IFR) ein, um die Anweisungen des Modells in mehreren Dialogrunden zu quantifizieren.

Die Veröffentlichung von Multi-IF bietet Forschern einen herausfordernden Benchmark und fördert die Entwicklung von LLM in globalen und mehrsprachigen Anwendungen. Der Start dieses Benchmarks zeigt nicht nur die Mängel des aktuellen Modells in mehrkundigen und mehrfachsprachigen Aufgaben, sondern bietet auch eine klare Richtung für zukünftige Verbesserungen.

These: https://arxiv.org/html/2410.15553v2

Punkte:

Der Multi-IF-Benchmark deckt acht Sprachen ab, darunter 4501 dreirädrige Dialogaufgaben, um die Leistung von LLM in komplexen Szenen zu bewerten.

Experimente zeigen, dass die Genauigkeit der meisten LLMs in mehreren Dialogrunden erheblich abgenommen hat, insbesondere in der Sprache des nicht -latinischen Textes.

Die Modelle O1-Präview und Lama3.1405B haben die besten durchgeführt, und die durchschnittliche Genauigkeit von dreirädrigen Anweisungen betrug 78,9% bzw. 78,1%.

Insgesamt bietet das Erscheinungsbild des Multi-IF-Benchmarks eine neue Richtung für die Bewertung von großer Sprachmodellen. Werbung Die Geburt von intelligenter und näher am praktischen Modell.