DeepSeek veröffentlichte am 20. Januar 2025 sein erstes Inferenzmodell DeepSeek-R1, das auf Reinforcement-Learning-Training basiert. Das Modell zeigte in mehreren Benchmark-Tests eine Leistung, die mit OpenAI-o1-1217 vergleichbar oder sogar besser war. DeepSeek-R1 wird nicht direkt trainiert, sondern überwindet durch mehrstufiges Training und Kaltstartdaten basierend auf dem DeepSeek-V3-Base-Modell die Probleme, die durch die alleinige Verwendung des Reinforcement-Learning-Trainingsmodells (DeepSeek-R1-Zero) entstehen. Probleme wie schlechte Lesbarkeit und gemischte Sprachen führten letztendlich zu deutlichen Leistungsverbesserungen. Das Modell ist Open Source und bietet wettbewerbsfähige Preise für den API-Zugriff, wodurch Benutzern eine bequemere und wirtschaftlichere Option geboten wird.

Am 20. Januar 2025 kündigte DeepSeek die Einführung seines ersten durch Reinforcement Learning (RL) trainierten Inferenzmodells DeepSeek-R1 an, das in mehreren Inferenz-Benchmarks eine mit OpenAI-o1-1217 vergleichbare Leistung erzielte. DeepSeek-R1 basiert auf dem DeepSeek-V3-Base-Modell und nutzt mehrstufige Trainings- und Kaltstartdaten, um die Inferenzfähigkeiten zu verbessern.

DeepSeek-Forscher entwickelten zunächst DeepSeek-R1-Zero, ein Modell, das vollständig durch verstärktes Lernen in großem Maßstab trainiert wurde, ohne dass vorbereitende Schritte für eine überwachte Feinabstimmung erforderlich waren. DeepSeek-R1-Zero hat in Inferenz-Benchmarks eine hervorragende Leistung gezeigt. Bei der AIME2024-Prüfung stieg der Pass@1-Score beispielsweise von 15,6 % auf 71,0 %. Allerdings weist DeepSeek-R1-Zero auch einige Probleme auf, etwa schlechte Lesbarkeit und gemischte Sprachen.

Um diese Probleme zu lösen und die Inferenzleistung weiter zu verbessern, hat das DeepSeek-Team DeepSeek-R1 entwickelt. DeepSeek-R1 führt mehrstufige Trainings- und Kaltstartdaten vor dem verstärkenden Lernen ein. Konkret sammelten die Forscher zunächst Tausende Kaltstartdaten, um das DeepSeek-V3-Base-Modell zu verfeinern. Anschließend führten sie ein inferenzorientiertes Verstärkungslernen durch, während sie DeepSeek-R1-Zero trainierten. Als der Reinforcement-Learning-Prozess kurz vor der Konvergenz stand, erstellten sie neue überwachte Feinabstimmungsdaten durch Ablehnungsstichproben von Reinforcement-Learning-Kontrollpunkten, kombinierten sie mit den überwachten Daten von DeepSeek-V3 in Bereichen wie Schreiben, Beantworten von Fakten und Selbstbewusstsein und führten dann ein erneutes Training durch DeepSeek-V3-Basismodell. Schließlich wird an den fein abgestimmten Kontrollpunkten unter Verwendung von Hinweisen aus allen Szenarien zusätzliches Verstärkungslernen durchgeführt.

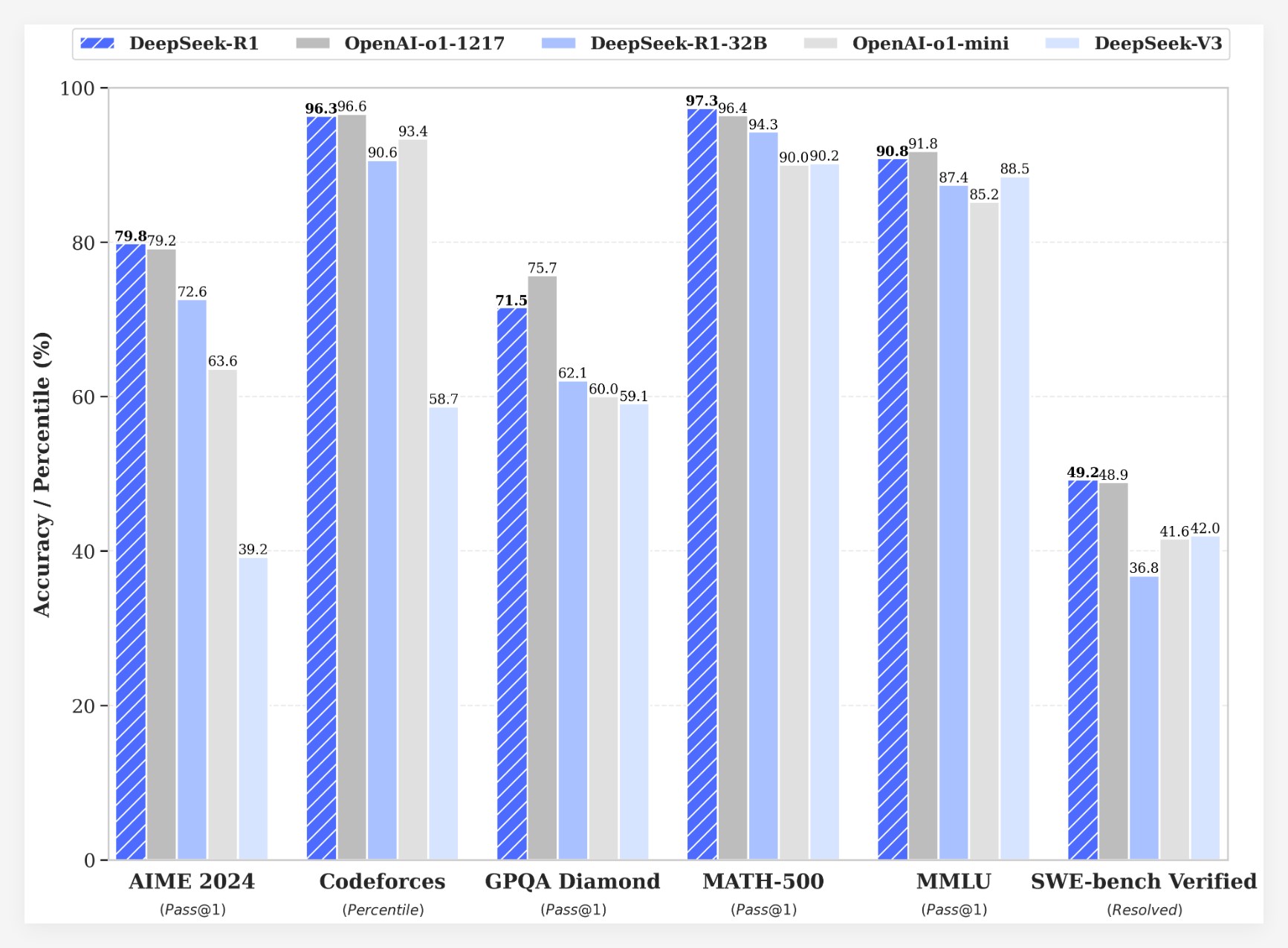

DeepSeek-R1 erzielt beeindruckende Ergebnisse bei mehreren Benchmarks:

•Bei der AIME2024-Prüfung erreichte DeepSeek-R1 einen Pass@1-Score von 79,8 %, etwas mehr als OpenAI-o1-1217.

•In der MATH-500-Prüfung erreichte DeepSeek-R1 die bestanden@1-Wertung von 97,3 %, was dem Wert von OpenAI-o1-1217 entspricht.

•In der Code-Wettbewerbsaufgabe erreichte DeepSeek-R1 eine Elo-Bewertung von 2029 auf Codeforces und übertraf damit 96,3 % der menschlichen Teilnehmer.

•In Wissensbenchmarks wie MMLU, MMLU-Pro und GPQA Diamond schneidet DeepSeek-R1 mit 90,8 %, 84,0 % bzw. 71,5 % deutlich besser ab als DeepSeek-V3.

•DeepSeek-R1 schneidet auch bei anderen Aufgaben wie kreativem Schreiben, allgemeinen Fragen und Antworten, Bearbeitung, Zusammenfassung usw. gut ab.

Darüber hinaus untersucht DeepSeek auch die Destillation der Inferenzfähigkeiten von DeepSeek-R1 in kleinere Modelle. Es wurde festgestellt, dass die Destillation direkt aus DeepSeek-R1 eine bessere Leistung erbringt als die Anwendung von Reinforcement Learning auf einem kleinen Modell. Dies legt nahe, dass die von großen Basismodellen entdeckten Inferenzmuster für die Verbesserung der Inferenzfähigkeiten von entscheidender Bedeutung sind. DeepSeek verfügt über Open-Source-Modelle wie DeepSeek-R1-Zero, DeepSeek-R1 und sechs dichte Modelle (1.5B, 7B, 8B, 14B, 32B, 70B), die aus DeepSeek-R1 basierend auf Qwen und Llama destilliert wurden. Die Einführung von DeepSeek-R1 markiert einen bedeutenden Fortschritt beim Reinforcement Learning zur Verbesserung der Argumentationsfähigkeiten großer Sprachmodelle.

KostenvorteilWas die Kosten angeht, bietet DeepSeek-R1 eine sehr wettbewerbsfähige Preisstrategie. Die API-Zugriffspreise betragen 0,14 US-Dollar (Cache-Treffer) und 0,55 US-Dollar (Cache-Miss) pro Million Eingabe-Tokens und 2,19 US-Dollar pro Million Ausgabe-Tokens. Diese Preisstrategie ist attraktiver als andere ähnliche Produkte und wurde von Nutzern als „Game Changer“ beschrieben. Die offizielle Website und API sind jetzt online! Besuchen Sie https://chat.deepseek.com, um DeepThink zu erleben!

Die Veröffentlichung von DeepSeek-R1 löste heftige Diskussionen in der Community aus. Viele Benutzer schätzen den Open-Source-Charakter und die Kostenvorteile des Modells und glauben, dass es Entwicklern mehr Auswahl und Freiheit bietet. Einige Benutzer haben jedoch Fragen zur Kontextfenstergröße des Modells aufgeworfen und hoffen, dass zukünftige Versionen weiter optimiert werden können.

Das DeepSeek-Team gab an, dass es weiterhin an der Verbesserung der Leistung und des Benutzererlebnisses des Modells arbeiten wird und plant, in Zukunft weitere Funktionen einzuführen, einschließlich erweiterter Datenanalyse, um die Benutzererwartungen an AGI (Künstliche Allgemeine Intelligenz) zu erfüllen.

Die Einführung von DeepSeek-R1 zeigt nicht nur das große Potenzial des Reinforcement Learning zur Verbesserung der Argumentationsfähigkeiten großer Sprachmodelle, sondern bringt auch neue Richtungen und Möglichkeiten für die Entwicklung des KI-Bereichs. Seine Open-Source-Funktionen und seine wettbewerbsfähige Preisstrategie werden die Popularisierung und Anwendung der KI-Technologie weiter fördern.