Die Zhejiang-Universität und die Alibaba Damo Academy haben gemeinsam eine bahnbrechende Forschung gestartet: Sie nutzen Lehrvideos, um einen hochwertigen multimodalen Lehrbuchdatensatz zu erstellen. Diese Forschung zielt darauf ab, die Probleme der geringen Wissensdichte und der schwachen Bild-Text-Korrelation bestehender Pre-Training-Daten für groß angelegte Sprachmodelle (VLMs) zu lösen, bessere Trainingsmaterialien für VLMs bereitzustellen und die Nutzung von Bildungsressourcen zu verbessern. Das Forschungsteam sammelte und verarbeitete umfangreiche Lehrvideos und erstellte schließlich einen hochwertigen Datensatz, der mehrere Disziplinen mit einer Gesamtdauer von mehr als 22.000 Stunden abdeckt und neue Möglichkeiten für die Anwendung künstlicher Intelligenz im Bildungsbereich bietet.

Kürzlich haben die Universität Zhejiang und die Alibaba Damo Academy gemeinsam eine aufsehenerregende Studie veröffentlicht, die darauf abzielt, mithilfe von Lehrvideos hochwertige multimodale Lehrbücher zu erstellen. Dieses innovative Forschungsergebnis liefert nicht nur neue Ideen für das Training groß angelegter Sprachmodelle (VLMs), sondern könnte auch die Art und Weise verändern, wie Bildungsressourcen genutzt werden.

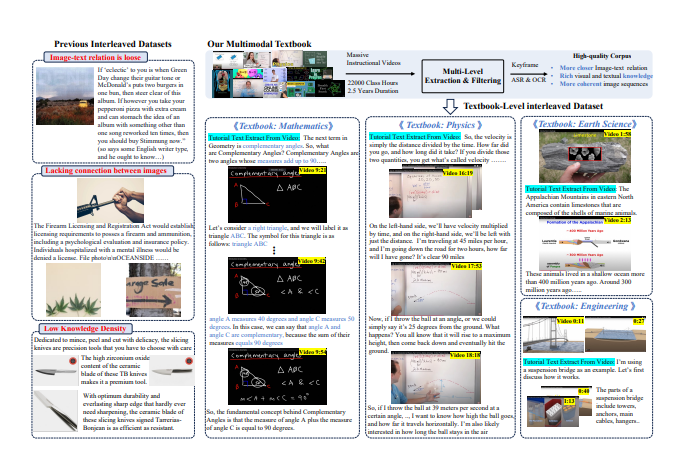

Mit der rasanten Entwicklung der Technologie der künstlichen Intelligenz basiert der Pre-Training-Korpus von VLMs hauptsächlich auf Bild-Text-Daten und einem mit Bild-Text verflochtenen Korpus. Die meisten aktuellen Daten stammen jedoch von Webseiten, die Korrelation zwischen Text und Bildern ist schwach und die Wissensdichte ist relativ gering, sodass komplexe visuelle Überlegungen nicht effektiv unterstützt werden können.

Um dieser Herausforderung zu begegnen, beschloss das Forschungsteam, aus der großen Anzahl von Lehrvideos im Internet einen hochwertigen Wissenskorpus zu extrahieren. Sie haben mehr als 159.000 Lehrvideos gesammelt und nach sorgfältiger Filterung und Verarbeitung schließlich 75.000 hochwertige Videos erhalten, die mehrere Themen wie Mathematik, Physik, Chemie usw. abdecken und eine Gesamtdauer von mehr als 22.000 Stunden haben.

Die Forscher entwarfen eine komplexe „Video-to-Textbook“-Verarbeitungspipeline. Zunächst wird die Technologie der automatischen Spracherkennung (ASR) verwendet, um den Erklärungsinhalt im Video in Text zu transkribieren. Anschließend werden durch Bildanalyse und Textabgleich Clips herausgefiltert, die für die Wissenspunkte von hoher Relevanz sind. Schließlich werden diese verarbeiteten Keyframes, der OCR-Text und der transkribierte Text verschachtelt und organisiert, um ein multimodales Lehrbuch mit reichhaltigem Inhalt und strenger Struktur zu bilden.

Vorläufige Ergebnisse dieser Studie zeigen, dass der neu generierte Lehrbuchdatensatz im Vergleich zu früheren webzentrierten Datensätzen eine deutlich verbesserte Wissensdichte und Bildkorrelation aufweist und eine solidere Grundlage für das Lernen von VLMs bietet. Darüber hinaus erregte die Forschung große Aufmerksamkeit in der akademischen Gemeinschaft, und die relevanten Datensätze gelangten mit mehr als 7.000 Downloads in nur zwei Wochen schnell an die Spitze der beliebten Liste der Hugging Face-Plattform.

Durch diesen innovativen Ansatz hoffen die Forscher, nicht nur die Entwicklung von VLMs voranzutreiben, sondern auch neue Möglichkeiten bei der Integration und Anwendung von Bildungsressourcen zu eröffnen.

Papieradresse: https://arxiv.org/pdf/2501.00958

Dieses Forschungsergebnis ist nicht nur für den Bereich der künstlichen Intelligenz von großer Bedeutung, sondern gibt auch eine neue Richtung für die künftige Reform des Bildungsmodells vor und weist auf die breiten Anwendungsaussichten der Technologie der künstlichen Intelligenz im Bildungsbereich hin. Die offene Quelle dieses Datensatzes stellt außerdem wertvolle Ressourcen für Forscher auf der ganzen Welt bereit und fördert die Zusammenarbeit und den Austausch in der akademischen Gemeinschaft.