Visuelle Sprachmodelle (VLMs) spielen eine Schlüsselrolle bei multimodalen Aufgaben, weisen jedoch erhebliche Mängel beim Verständnis der Negation auf. Bestehende Modelle haben häufig Schwierigkeiten, zwischen positiven und negativen Sätzen zu unterscheiden, was besonders bei Anwendungen, die ein präzises semantisches Verständnis erfordern, wie etwa medizinische Diagnosen und Sicherheitsüberwachung, besorgniserregend ist. Die Hauptursache ist eine Verzerrung in den Daten vor dem Training, die dazu führt, dass das Modell negative Aussagen mit positiven Aussagen verwechselt. In diesem Artikel wird ein neues Framework namens NegBench vorgestellt, das darauf abzielt, das Problem der unzureichenden Fähigkeit von VLMs, Negation zu verstehen, zu lösen.

Visuelle Sprachmodelle (VLMs) spielen eine entscheidende Rolle bei multimodalen Aufgaben wie Bildabruf, Bildbeschreibung und medizinischer Diagnose. Das Ziel dieser Modelle besteht darin, visuelle Daten mit sprachlichen Daten abzugleichen, um eine effizientere Informationsverarbeitung zu ermöglichen. Aktuelle VLMs stehen jedoch immer noch vor erheblichen Herausforderungen beim Verständnis der Negation.

Die Negation ist in vielen Anwendungen von entscheidender Bedeutung, beispielsweise bei der Unterscheidung zwischen einem „Raum ohne Fenster“ und einem „Raum mit Fenstern“. Trotz erheblicher Fortschritte bei VLMs sinkt die Leistung bestehender Modelle beim Umgang mit negativen Aussagen erheblich. Diese Einschränkung ist besonders wichtig in Hochrisikobereichen wie der Sicherheitsüberwachung und dem Gesundheitswesen.

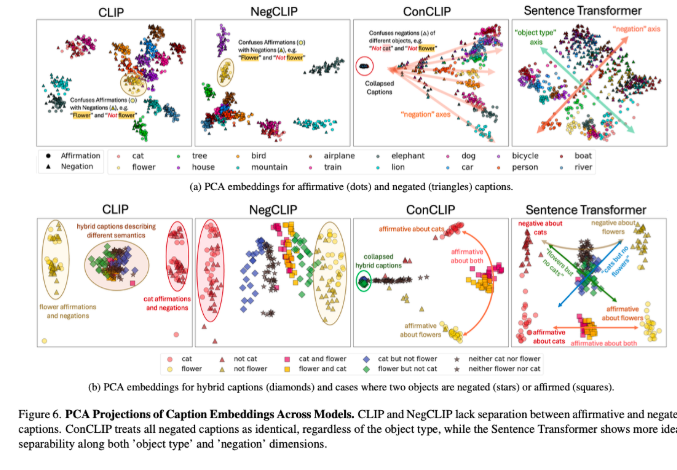

Bestehende VLMs wie CLIP nutzen einen gemeinsamen Einbettungsraum, um visuelle und textliche Darstellungen auszurichten. Während diese Modelle bei Aufgaben wie dem modalübergreifenden Abruf und der Bildunterschrift eine gute Leistung erbringen, versagen sie beim Umgang mit negativen Sätzen. Die Ursache dieses Problems liegt in einer Verzerrung der Daten vor dem Training, die hauptsächlich aus positiven Beispielen bestehen und dazu führen, dass das Modell negative und positive Aussagen als Synonyme behandelt. Daher verwenden bestehende Benchmarks wie CREPE und CC-Neg einfache Vorlagenbeispiele, die den Reichtum und die Tiefe der Negation in natürlicher Sprache nicht wirklich widerspiegeln können. Dies stellt VLMs vor große Herausforderungen bei der Durchführung präziser Sprachverständnisanwendungen, beispielsweise bei der Abfrage komplexer Bedingungen in medizinischen Bilddatenbanken.

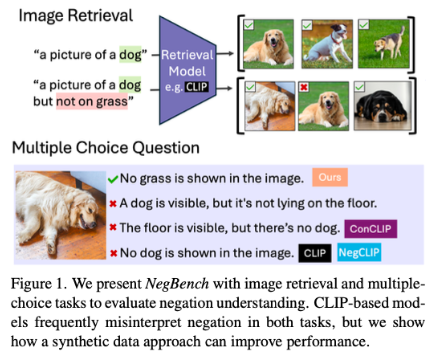

Um diese Probleme anzugehen, schlugen Forscher des MIT, Google DeepMind und der Universität Oxford das NegBench-Framework vor, um die Fähigkeit von VLMs, Negation zu verstehen, zu bewerten und zu verbessern. Das Framework bewertet zwei grundlegende Aufgaben: Retrieval and Negation (Retrieval-Neg), das die Fähigkeit des Modells testet, Bilder basierend auf positiven und negativen Beschreibungen abzurufen, und Multiple Choice Questions and Negation (MCQ-Neg), das die Leistung des Modells auf subtile Weise bewertet Verständnis. NegBench verwendet große synthetische Datensätze wie CC12M-NegCap und CC12M-NegMCQ, die Millionen von Titeln enthalten, die umfangreiche negative Szenarien abdecken, um das Modelltraining und die Modellbewertung zu verbessern.

Durch die Kombination realer und synthetischer Datensätze überwindet NegBench effektiv die Einschränkungen vorhandener Modelle und verbessert die Leistung und Generalisierungsfähigkeiten des Modells erheblich. Das fein abgestimmte Modell zeigte erhebliche Verbesserungen sowohl bei den Abruf- als auch bei den Verständnisaufgaben, insbesondere bei der Bearbeitung negativer Abfragen, wo die Erinnerung des Modells um 10 % stieg. Bei Multiple-Choice-Aufgaben verbesserte sich die Genauigkeit um bis zu 40 %, was eine deutlich verbesserte Fähigkeit zur Unterscheidung zwischen subtilen positiven und negativen Schlagzeilen zeigt.

Der Vorschlag von NegBench schließt die entscheidende Lücke von VLMs im Verständnis der Negation und ebnet den Weg für den Aufbau leistungsfähigerer Systeme der künstlichen Intelligenz, was besonders wichtig in Schlüsselbereichen wie der medizinischen Diagnose und dem Abruf semantischer Inhalte ist.

Papier: https://arxiv.org/abs/2501.09425

Code: https://github.com/m1k2zoo/negbench

Highlight:

Forscher zeigen, dass die Mängel visueller Sprachmodelle beim Verständnis der Negation hauptsächlich auf Verzerrungen in den Trainingsdaten zurückzuführen sind.

Das NegBench-Framework verbessert die Modellleistung bei Abruf- und Verständnisaufgaben erheblich, indem es umfangreiche Negativbeispiele einführt.

Wenn das fein abgestimmte Modell negative Anfragen verarbeitet, werden die Genauigkeit und die Rückrufraten erheblich verbessert, was den Fortschritt von Systemen der künstlichen Intelligenz fördert.

Das Aufkommen des NegBench-Frameworks bietet eine wirksame Lösung für das Problem visueller Sprachmodelle beim Verständnis der Negation. Es ist von großer Bedeutung für die Verbesserung der Modellleistung und die Förderung der Entwicklung künstlicher Intelligenz und verdient weitere Forschung und Anwendung.