Visuelle große Modelle (LVLMs) haben im Bereich des Bildverständnisses erhebliche Fortschritte gemacht, aber das „Illusionsphänomen“ ist zu einem Engpass in seiner Entwicklung geworden. Um dieses Problem anzugehen, schlug das Team des Future Life Laboratory der Taotian Group eine neue Methode namens „Token Preference Optimization“ (TPO) vor, die die visuelle Wirkung des Modells durch die Einführung eines selbstkalibrierten visuellen Ankerbelohnungsmechanismus effektiv verbessert und dadurch die Informationsabhängigkeit verringert Wahrscheinlichkeit von Halluzinationen. Der Kern von TPO besteht darin, die Generierung von Belohnungssignalen auf Token-Ebene zu automatisieren, mühsame manuelle Anmerkungen zu vermeiden und jedem Token Belohnungen zuzuweisen, die seine Abhängigkeit von visuellen Informationen widerspiegeln, wodurch die Modellleistung verbessert wird.

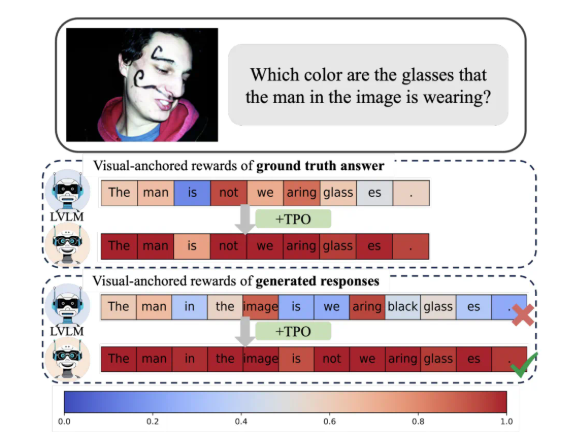

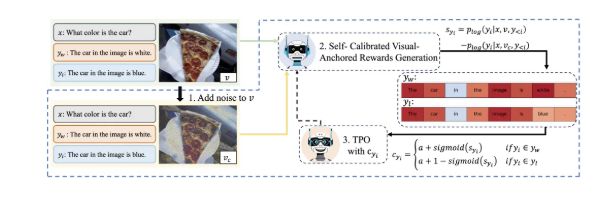

Die größte Innovation von TPO besteht darin, dass es automatisierte Belohnungssignale auf Token-Ebene implementiert. Diese Methode kann automatisch visuell verankerte Token in Präferenzdaten identifizieren und so die mühsame manuelle feinkörnige Annotation vermeiden, während jedem Token eine Belohnung zugewiesen wird, die seine Abhängigkeit von visuellen Informationen während des Trainingsprozesses widerspiegelt. Dieses selbstkalibrierte, visuell verankerte Belohnungssignal soll die Abhängigkeit des Modells von visuellen Informationen optimieren und so das Auftreten von Halluzinationen wirksam abmildern.

Untersuchungen zeigen, dass Modelle, die TPO verwenden, herkömmliche Methoden in mehreren Bewertungsbenchmarks deutlich übertreffen, insbesondere bei komplexeren Aufgaben, bei denen die vom Modell generierten Antworten zunehmend auf Bildinformationen und nicht auf Vorkenntnissen des Sprachmodells beruhen. Dieser Fortschritt verbessert nicht nur das Verständnis des Modells, sondern liefert auch eine wichtige theoretische Grundlage für die weitere Forschung.

Darüber hinaus führte das Forschungsteam auch Ablationsexperimente mit verschiedenen Parametereinstellungen von TPO durch und stellte fest, dass optimierte Rauschadditionsschritte und Belohnungsverteilungsstrategien die Modellleistung weiter verbessern können. Diese Entdeckung weist zweifellos die Richtung für die zukünftige Forschung und Anwendung großer visueller Modelle.

Kurz gesagt, diese innovative Errungenschaft von Taotian liefert eine neue Idee für die multimodale Ausrichtungstechnologie und fördert die tiefgreifende Anwendung der KI-Technologie in den Bereichen Leben und Konsum.

Durch die Anwendung der TPO-Methode wird das „Illusions“-Problem großer visueller Modelle effektiv gelöst, die Zuverlässigkeit und Genauigkeit des Modells verbessert und eine neue Richtung für die zukünftige Entwicklung großer visueller Modelle bereitgestellt Neue Richtung für die Anwendung künstlicher Intelligenz im wirklichen Leben. Die Anwendung hat eine solide Grundlage gelegt und hat wichtige theoretische Bedeutung und Anwendungswert. Dieses Forschungsergebnis verleiht der Entwicklung multimodaler Technologie neue Kraft.