In diesem Artikel wird die von Microsoft in Zusammenarbeit mit der Tongji University entwickelte LLM2Clip -Methode vorgestellt, mit der die Leistung des visuellen Encoders des Clip -Modells verbessert und seine Einschränkungen bei der Behandlung langer und komplexer Textbeschreibungen gelöst werden soll. LLM2CLIP verbessert die Fähigkeit des Modells, Bilder und Text und Text durch die Integration von großsprachigen Modellen (LLMs) und die Einführung der "Titelkontrast-Feinabstimmung" -Technologie erheblich verbessert. Die experimentellen Ergebnisse dieser Methode zu mehreren Datensätzen zeigen, dass sie bei den Abrufaufgaben im Bild-zu-Text- und Text-zu-Im-Im-Im-Im-Im-Im-Image-Abruf die traditionellen Clip- und EVA-Modelle übertreffen und eine leistungsstarke Cross-Sprach-Verarbeitung zeigen Fähigkeit.

Im heutigen Bereich der Wissenschaft und Technologie ist Clip (kontrastive Sprachbild vor der Training) ein wichtiges multimodales Basismodell. Es kombiniert visuelle und Textsignale in einen gemeinsam genutzten Merkmalsraum, indem Kontrastlernverluste bei großen Bildtextpaaren verwendet werden.

Als Sucher kann Clip verschiedene Aufgaben wie Klassifizierung, Erkennung, Segmentierung und Bild-Text-Abruf von Null-Shot-Klassifizierung unterstützen. In der Zwischenzeit dominiert es als Feature-Extraktor fast alle Aufgaben der repräsentativen Repräsentation wie Bildverständnis, Videoverständnis und Text-zu-Image- oder Videogenerierung. Was an Clip mächtig ist, ist seine Fähigkeit, Bilder mit natürlicher Sprache zu verbinden und menschliches Wissen zu erfassen, dank seines Trainings in großen Netzwerkdaten, die detaillierte Textbeschreibungen enthält.

Clip hat jedoch bestimmte Einschränkungen im Umgang mit langen und komplexen Textbeschreibungen. Um dieses Problem zu überwinden, schlugen Forscher der Microsoft und der Tongji University die LLM2CLIP -Methode vor, um das Lernen der visuellen Repräsentation durch Integration von großsprachigen Modellen (LLMs) zu verbessern. Diese Methode ersetzt mutig den ursprünglichen Clip -Text -Encoder und verwendet das reichhaltige Wissen von LLMs, um die visuelle Encoder -Leistung von Clip zu verbessern. Die Studie ergab, dass die direkte Integration von LLMs in Clips zu Leistungsverschlechterungen führt, sodass diese Herausforderung angegangen werden muss.

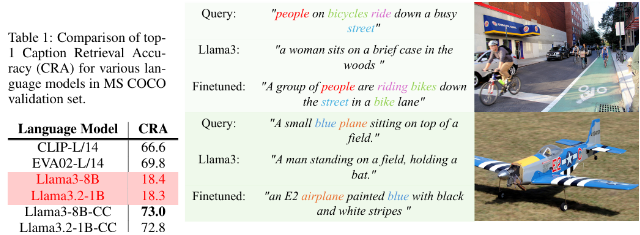

Die LLM2Clip-Methode verbessert die Fähigkeit von LLM erheblich, Bildtitel zu trennen, indem die Technologie "Titelkontrast-Feinabstimmung" eingeführt wird, wodurch eine signifikante Leistungsverbesserung erzielt wird.

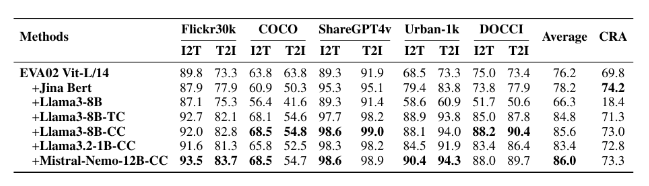

Die Forscher verwendeten Datensätze unterschiedlicher Größen für Feinabstimmungsexperimente, einschließlich kleiner CC-3M, mittlerer CC-3M und CC-12M sowie großer CC-3M, CC-12M, YFCC-15M und Recaption-1B. Die Ergebnisse zeigen, dass das mit LLM2Clip trainierte Modell besser als die herkömmlichen Clip- und EVA-Modelle in Bild-zu-Text- und Text-zu-Image-Abrufaufgaben.

Durch die Kombination von multimodalem Training mit Modellen wie LLAVA 1.5 hat LLM2Clip in fast allen Benchmarks gut abschnitten, insbesondere wenn er mit langen und kurzen Texten -Abrufaufgaben zu tun hat, wobei die Leistung des vorherigen EVA02 -Modells um 16,5%verbessert wurde. Dieser innovative Ansatz verwandelt den Clip nicht nur von der einfachen Verarbeitung englischer Daten in ein leistungsstarkes Cross-Sprach-Modell, sondern bildet auch die Grundlage für zukünftige Forschungsergebnisse zum Clip-Training.

Modell: https://huggingface.co/collections/microsoft/llm2clip-672323a266173cfa40b32d4c

Code: https://github.com/microsoft/llm2clip/

Papier: https://arxiv.org/abs/2411.04997

Punkte:

LLM2CLIP ist ein innovativer Ansatz, der von der Microsoft und der Tongji University in Zusammenarbeit mit der Tongji University vorgeschlagen wird, um die Leistung seines visuellen Encoders durch Ersetzen von Clips Text -Encoder zu verbessern.

Diese Methode verbessert die Fähigkeit des Modells erheblich, Bilder mit Text über die Technik "Titelkontrast-Feinabstimmung" abzustimmen und vorhandene Modelle des hochmodernen Standes zu übertreffen.

Die Experimente von LLM2CLIP an mehreren Datensätzen zeigen, dass es bessere als herkömmliche Modelle in langen und kurzen Textabrechnungsaufgaben abschneidet und die Entwicklung von Cross-Language-Modellen vorantreibt.

Kurz gesagt, die LLM2Clip-Methode bietet neue Ideen zur Verbesserung des Clip-Modells. Verwandte Ressourcenverbindungen sind für Leser bequem zu lernen und zu recherchieren.