Iflyteks Start des multimodalen Interaktionsmodells von Iflytek markiert einen neuen Meilenstein im Bereich der künstlichen Intelligenz. Dieses Modell durchbricht die Grenzen der Interaktion mit einer einzelnen Sprache in der Vergangenheit und erkennt eine nahtlose Integration von Sprach-, visuellen und digitalen und digitalen Interaktionsfunktionen und bringt Benutzern ein lebendigeres, realistischeres und bequemeres interaktiveres Erlebnis. Die superanthropomorphe digitale menschliche Technologie kann Sprachinhalte genau anpassen, um Ausdrücke und Aktionen zu erzeugen, und unterstützt die über-anthropomorphe Interaktion, die Klangparameter nach Anweisungen anpassen und personalisierte Dienste anbieten. Die multimodale visuelle Interaktionsfunktion gibt dem Modell die Fähigkeit, "die Welt zu verstehen und alles zu erkennen", Umweltinformationen genau wahrzunehmen und angemessenere Antworten zu erzielen.

Der Start des multimodalen Interaktionsmodells von Iflytek spiegelt nicht nur die führende Position von Iflytek in der multimodalen Interaktionstechnologie wider, sondern bietet auch neue Ideen für die zukünftige Entwicklungsrichtung künstlicher Intelligenzanwendungen. Durch die Integration mehrerer Interaktionsmethoden kann dieses Modell die Benutzerbedürfnisse besser verstehen und genauere und reichhaltigere Dienste anbieten. Sein offenes SDK bietet Entwicklern auch mehr Möglichkeiten, die Populalisierung und Anwendung der multimodalen Technologie für künstliche Intelligenz zu fördern. In Zukunft können wir innovativere Anwendungen erwarten, die auf diesem Modell basieren, um die Lebenseffizienz der Menschen weiter zu verbessern und Qualität zu erleben.

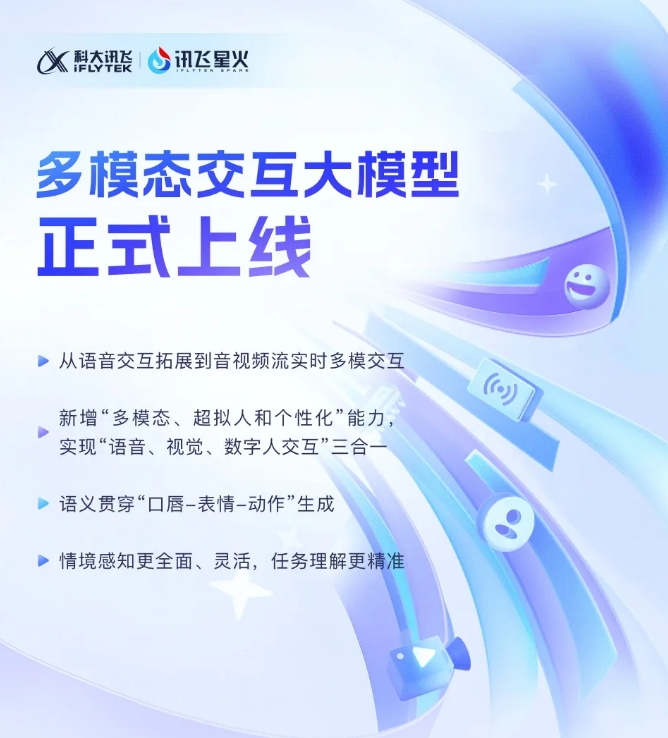

Iflytek kündigte kürzlich an, dass seine jüngste Entwicklung des multimodalen Interaktionsmodells von Iflytek offiziell in Betrieb genommen wurde. Dieser technologische Durchbruch markiert eine neue Bühne in der Expansion von Iflytek von einer einzigen Sprachinteraktionstechnologie zu einer neuen Stufe der multimodalen Echtzeit-Interaktion von Audio- und Video-Streams. Das neue Modell integriert Sprach-, visuelle und digitale Interaktionsfunktionen, und Benutzer können eine nahtlose Kombination der drei durch einen Klick-Aufruf erzielen.

Der Start des Multimodal-Interaktionsmodells von Iflytek hat erstmals die superanthropomorphe digitale menschliche Technologie eingeführt. real. Durch die Integration von Text, Sprache und Ausdrücken kann das neue Modell eine semantische Konsistenz der Kreuzmodal erreichen und emotionalen Ausdruck realistischer und kohärenter machen.

Darüber hinaus unterstützt Iflytek Spark die super-anthropomorphe superschnelle Interaktionstechnologie, wobei ein einheitliches neuronales Netzwerk verwendet wird, um die End-to-End-Modellierung von Voice to Voice direkt zu realisieren, wodurch die Reaktionsgeschwindigkeit schneller und reibungsloser wird. Diese Technologie kann emotionale Veränderungen stark wahrnehmen und den Rhythmus, die Größe und den Charakter des Klangs entsprechend den Anweisungen frei anpassen und ein persönlicheres interaktiveres Erlebnis bieten.

In Bezug auf die multimodale visuelle Interaktion kann Iflytek Spark "die Welt verstehen" und "alles erkennen" und spezifische Hintergrundszenen, den Logistikstatus und andere Informationen vollständig wahrnehmen, was das Verständnis der Aufgabe genauer macht. Durch die Integration verschiedener Informationen wie Sprach, Gesten, Verhaltensweisen und Emotionen kann das Modell geeignete Antworten machen und den Benutzern ein reichhaltigeres und genaueres interaktives Erlebnis bieten.

Multimodal Interaktion Big Model SDK: https://www.xfyun.cn/solutions/multimodel

Kurz gesagt, das Auftreten des multimodalen Interaktionsmodells von Iflytek hat eine neue Entwicklungsphase für die künstliche Intelligenz eingetragen. Ich freue mich auf Iflytek Spark wird in Zukunft weitere Überraschungen bringen.