Nvidia hat kürzlich die neue Blackwell -Plattform veröffentlicht und zeigte beeindruckende Leistungsverbesserungen im MLPERF -Training 4.1 Benchmark. Im Vergleich zu früheren Hopper -Plattformen verdoppelte Blackwell seine Leistung bei mehreren KI -Trainingsaufgaben, insbesondere bei LLM -Trainings für Großsprachenmodelle (LLM), und seine Effizienz wurde erheblich verbessert. Dieser Durchbruch zeigt einen weiteren Sprung in der AI -Computerleistung und bildet eine solide Grundlage für die weit verbreitete Implementierung von AI -Anwendungen in der Zukunft. Dieser Artikel wird eine eingehende Analyse der Leistung der Blackwell-Plattform durchführen und ihre technologische Innovation und zukünftige Entwicklung erörtern.

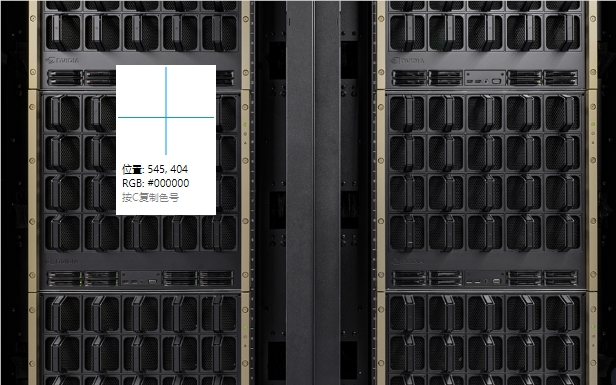

Kürzlich veröffentlichte Nvidia seine neue Blackwell -Plattform und demonstrierte vorläufige Leistung im MLPERF -Training 4.1 Benchmark. Laut den Testergebnissen hat sich die Leistung von Blackwell in einigen Aspekten im Vergleich zur vorherigen Generation von Hopper -Plattformen verdoppelt, und diese Leistung hat die Branche weit verbreitet.

Im MLPerf-Training4.1 Benchmark erzielte die Blackwell-Plattform das 2,2-fache der Leistung jeder GPU in der LLAMA270B-Feinabstimmungsaufgabe des LLM-Benchmarks (großer Sprachmodell) und zweifache Leistung jeder GPU in der Vorausbildung von Der GPT-3175B doppelt die Verbesserung. Darüber hinaus übertraf die neue Generation von Blackwell in anderen Benchmarks wie einem stabilen Diffusions -V2 -Training die vorherige Generation um das 1,7 -fache.

Es ist erwähnenswert, dass Hopper zwar weiterhin Verbesserungen zeigt, aber Hopper im Vergleich zur vorherigen Runde der MLPERF-Trainingsbenchmarks auch eine Leistungsverbesserung des Sprachmodells im Vergleich zur vorherigen Runde von MLPERF-Runde hat. Dies zeigt, dass sich die Technologie von Nvidia weiter verbessert. In der jüngsten Benchmark GPT-3175B reichte NVIDIA 11.616 Hopper GPUs ein und stellte einen neuen Expansionsrekord auf.

In Bezug auf die technischen Details von Blackwell sagte Nvidia, dass die neue Architektur optimierte Tensor -Kerne und schnellere Hochbandbreitengedächtnisse verwendet. Dies macht es nur 64 GPUs, den GPT-3175B-Benchmark auszuführen, während 256 GPUs mithilfe der Hopper-Plattform dieselbe Leistung erzielen.

NVIDIA betonte auch die Leistungsverbesserung der Produktionsprodukte von Hopper in Software- und Netzwerkaktualisierungen auf der Pressekonferenz, und es wird erwartet, dass sich Blackwell mit zukünftigen Einsendungen weiter verbessern wird. Darüber hinaus plant Nvidia, die nächste Generation von AI Accelerator Blackwell Ultra im nächsten Jahr auf den Markt zu bringen, was voraussichtlich mehr Speicher und stärkere Rechenleistung bietet.

Blackwell debütierte im vergangenen September auch im MLPerf Inference V4.1 Benchmark und erzielt in Bezug auf die KI -Inferenz 4 -mal mehr erstaunliche Leistung pro GPU als der H100, insbesondere mit einer niedrigeren Essenz der FP4 -Genauigkeit Dieser neue Trend soll mit der wachsenden Nachfrage nach Chatbots mit geringer Latenz und intelligentem Computing wie dem O1-Modell von OpenAI fertig werden.

Punkte:

- ** Nvidia Blackwell Platform verdoppelt seine Leistung im KI -Training, brechen die Industriestandards! **

- ** Blackwell benötigt nur 64 GPUs im GPT-3175B-Benchmark, was die Effizienz erheblich verbessert! **

- ** Blackwell Ultra wird nächstes Jahr gestartet, was voraussichtlich höhere Speicher- und Rechenleistung liefert! **

Kurz gesagt, die Entstehung der Blackwell -Plattform von Nvidia erzielt einen großen Durchbruch im Bereich AI Computing. Die erhebliche Leistungsverbesserung und die zukünftige Einführung von Blackwell Ultra werden die Entwicklung und Anwendung der KI -Technologie weiter fördern und mehr Möglichkeiten für alle Branchen bringen. Wir haben Grund zu erwarten, dass die Blackwell -Plattform in Zukunft eine größere Rolle spielt.