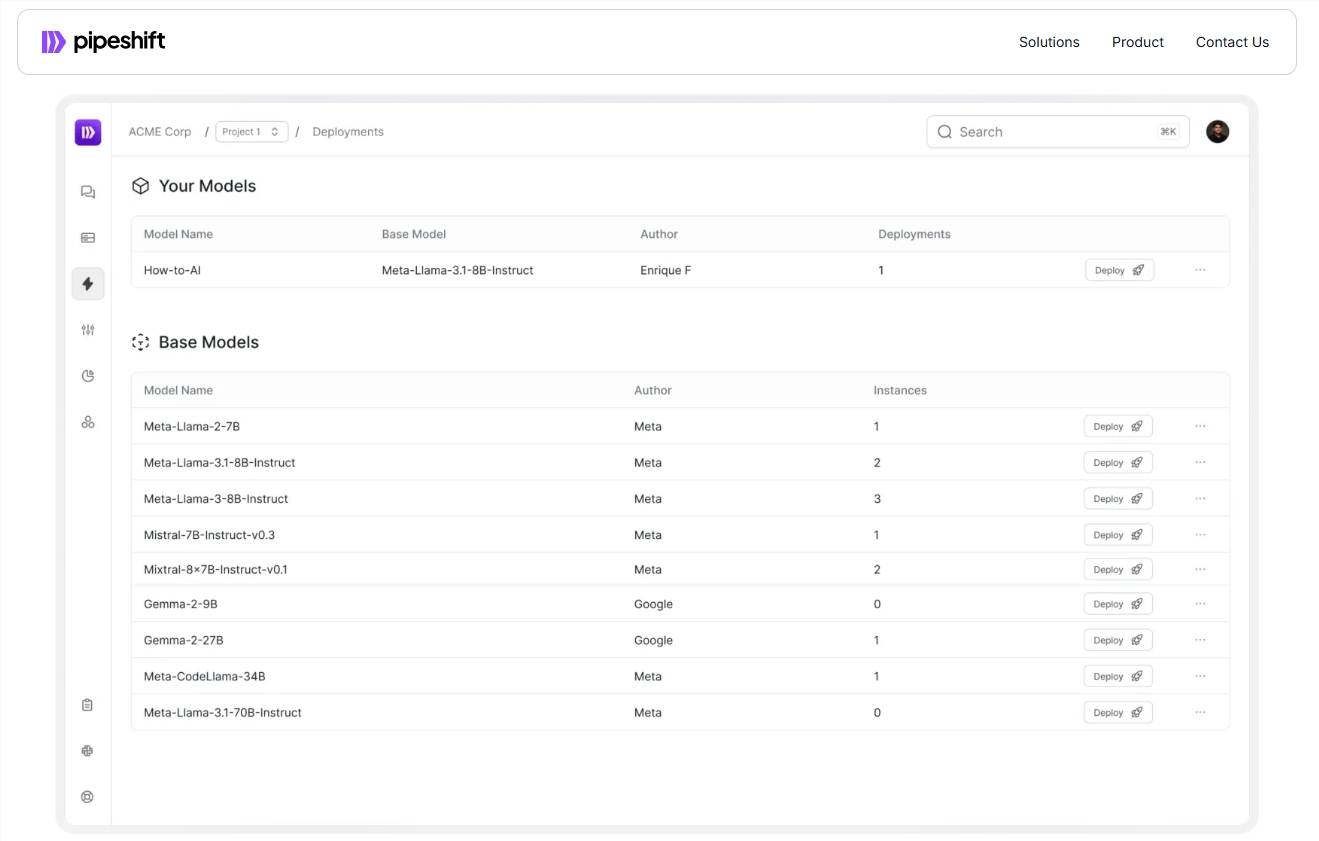

Startup Pipeshift hat eine neue End-to-End-Plattform auf den Markt gebracht, mit der Enterprises Open Source Generative KI-Modelle effizienter trainieren, bereitstellen und skalieren können. Die Plattform ist mit einer Vielzahl von Cloud-Umgebungen und einem lokalen GPUs kompatibel, wodurch die Inferenzgeschwindigkeit erheblich verbessert und die Kosten gesenkt, das Problem des effizienten Umschaltens zwischen mehreren Modellen durch Unternehmen gelöst wird. Es nimmt ein modulares Inferenzmotor -Magic -Framework an, mit dem eine flexible Kombination verschiedener Inferenzkomponenten ohne mühsame technische Arbeiten optimiert werden kann. Dies ist zweifellos ein großer Vorteil für Unternehmen, die vor Herausforderungen beim Bereitstellen und Verwalten von KI -Modellen stehen.

In letzter Zeit hat Startup Pipeshift eine neue End-to-End-Plattform gestartet, mit der Unternehmen das Trainer, die Bereitstellung und Skalierung von Open-Source-Generativen-KI-Modellen effizienter trainieren, einsetzen und skalieren können. Die Plattform läuft nicht nur in einer Cloud-Umgebung oder einer lokalen GPU, sondern verbessert auch erheblich die Inferenzgeschwindigkeit und senkt die Kosten.

Mit der schnellen Entwicklung der KI -Technologie stehen viele Unternehmen vor der Herausforderung, wie sie effizient zwischen mehreren Modellen wechseln können. Traditionell müssen Teams ein komplexes MLOPS-System erstellen, das mehrere Verbindungen wie die Erfassung von Computerressourcen, Modelltraining, Feinabstimmung und Bereitstellung auf Produktionsebene umfasst. an Infrastrukturmanagement.

Arko Chattopadhyay, Mitbegründer und CEO von Pipeshift, stellte fest, dass die Entwicklung eines flexiblen, modularen Argumentationsmotors häufig jahrelanger Erfahrung erfordert, und die Lösungen von Pipeshift sind so konzipiert, dass dieses Prozess mit seinem modularen Argumentationsmotor vereinfacht wird. Die Plattform nimmt ein Framework namens Magic (GPU Inference Cluster Modular Architecture) an, mit dem Teams verschiedene Inferenzkomponenten entsprechend den spezifischen Arbeitsbelastungsanforderungen flexibel kombinieren können, wodurch die Inferenzleistung optimiert wird, ohne dass umständliche Engineering erforderlich ist.

Beispielsweise integriert ein Fortune 500 -Einzelhandelsunternehmen nach Verwendung der Pipeshift -Plattform vier Modelle, für die ursprünglich vier unabhängige GPU -Instanzen auf eine einzelne GPU -Instanz ausgeführt wurden. Auf diese Weise erzielte das Unternehmen nicht nur eine fünffache Erhöhung der Argumentationsgeschwindigkeit, sondern reduzierte auch die Infrastrukturkosten um 60%. Diese Leistung ermöglicht es Unternehmen, in einem schnell wachsenden Markt wettbewerbsfähig zu bleiben.

Pipeshift hat jährliche Lizenzvereinbarungen mit 30 Unternehmen getroffen und plant, Tools zu starten, damit Teams in Zukunft Datensätze erstellen und skalieren können. Dies wird den experimentellen und Datenvorbereitungsprozess weiter beschleunigen und die Kundenproduktivität verbessern.

Offizieller Eingang: https://pipeshift.com/

Punkte:

Der modulare Inferenzmotor von PipeShift kann die GPU -Verwendung von KI -Inferenz erheblich reduzieren und die Kosten um bis zu 60%senken.

Durch das magische Framework können Unternehmen schnell Inferenzkomponenten kombinieren, die Inferenzgeschwindigkeit verbessern und die Engineering -Belastung reduzieren.

Pipeshift hat sich mit mehreren Unternehmen zusammengetan und wird in Zukunft mehr Tools auf den Markt bringen, damit Unternehmen AI -Workloads effizienter verwalten können.

Mit seinen effizienten, flexiblen und kostengünstigen Eigenschaften bietet die Pipeshift-Plattform Unternehmen eine effektive Lösung, um die Bereitstellung und das Management von KI-Modellen zu vereinfachen, die es wert sind, Aufmerksamkeit zu schenken. Die zukünftige Entwicklung und die Einführung neuer Tools sind sich ebenfalls gerne freuen.