Das Salesforce AI Research Team veröffentlichte das neueste multimodale Sprachmodell, Blip-3-Video, um die wachsenden Videodaten effizient zu verarbeiten. Das traditionelle Videoverständnismodell ist ineffizient. Dieser Schritt löst das Problem des Umgangs mit langen Videos und bietet stärkere Videoverständnisfunktionen für Branchen wie autonomes Fahren und Unterhaltung.

Kürzlich hat das Salesforce AI Research Team ein neues multimodales Sprachmodell auf den Markt gebracht-Blip-3-Video. Mit der raschen Zunahme des Videoinhalts ist die effiziente Verarbeitung von Videodaten zu einem dringenden Problem geworden. Die Entstehung dieses Modells soll die Effizienz und Effektivität des Videoverständnisses verbessern und für Branchen von autonomen Fahren bis hin zu Unterhaltung geeignet sind.

Herkömmliche Modelle für Videoverständnisse verarbeiten oft Videorahmen nach Frame und generieren eine große Menge an visuellen Informationen. Dieser Prozess verbraucht nicht nur viele Rechenressourcen, sondern schränkt auch die Fähigkeit, lange Videos zu verarbeiten. Da die Menge an Videodaten weiter wächst, wird dieser Ansatz immer ineffizienter, sodass es entscheidend ist, eine Lösung zu finden, die die kritischen Informationen des Videos erfasst und gleichzeitig die Rechenbelastung verringert.

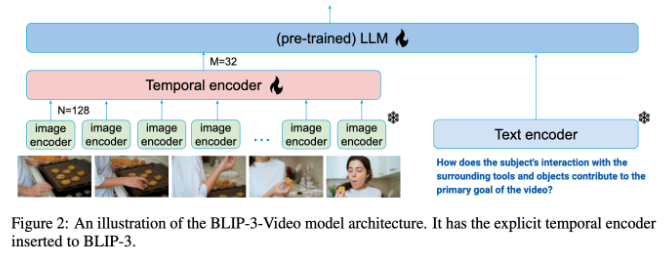

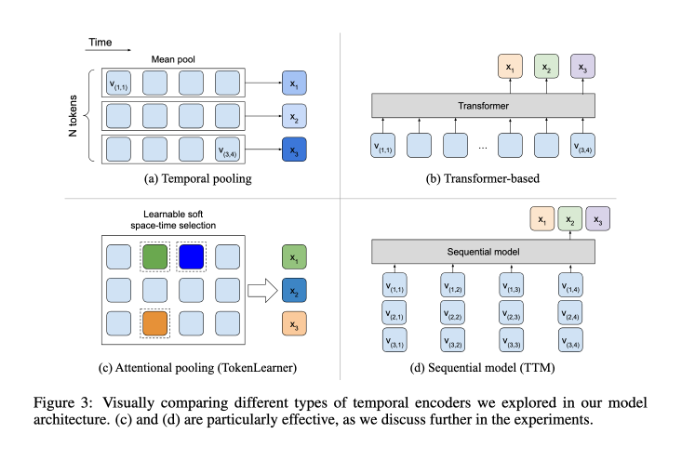

In dieser Hinsicht hat BLIP-3-VIDEO recht gut abgeschnitten. Durch die Einführung eines "Zeitsequenz -Encoders" reduzierte das Modell die Menge der im Video erforderlichen visuellen Informationen erfolgreich auf 16 bis 32 visuelle Markierungen. Dieses innovative Design verbessert die Recheneffizienz erheblich und ermöglicht es den Modellen, komplexe Videoaufgaben zu geringeren Kosten zu erledigen. Dieser Timing -Encoder verwendet einen mechanischen mechanischen Räumlichkeitsmechanismus, der die wichtigsten Informationen aus jedem Rahmen extrahiert und in einen kompakten Satz visueller Marker integriert.

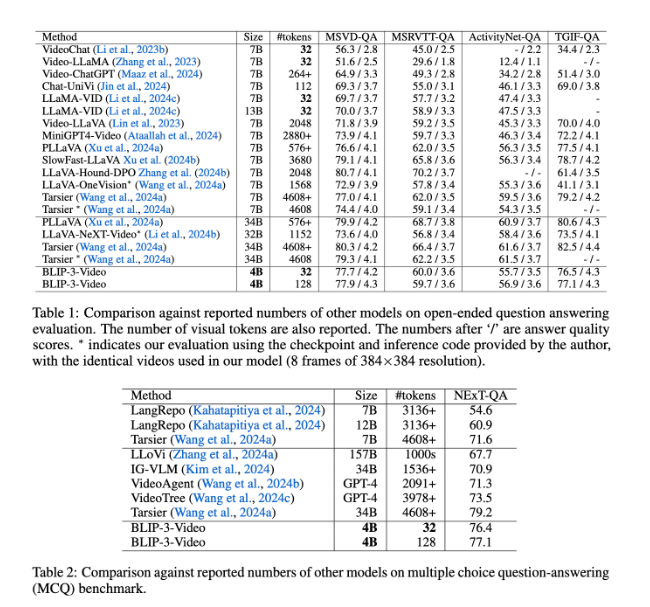

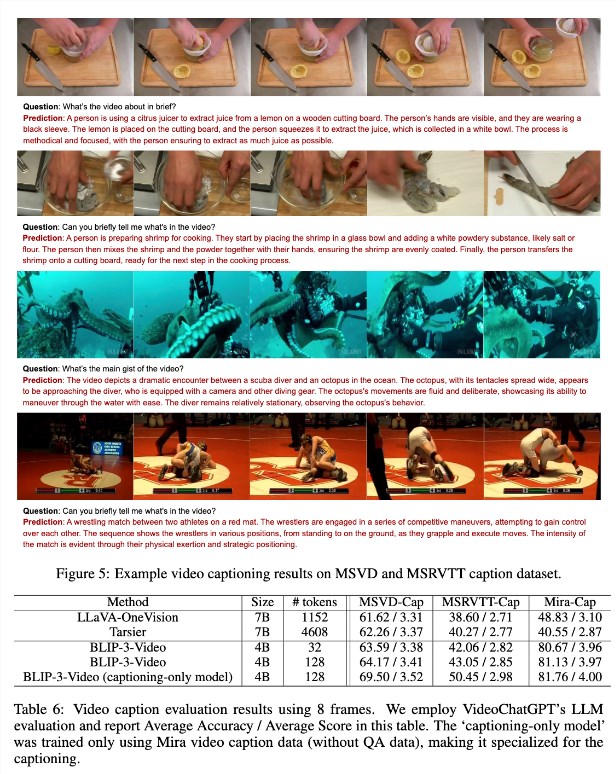

BLIP-3-VIDEO hat ebenfalls sehr gut gespielt. Im Vergleich zu anderen großen Modellen ergab die Studie, dass das Modell eine Genauigkeitsrate vergleichbarer Topmodelle in Video -Q & A -Aufgaben aufweist. Zum Beispiel erfordert das Tarsier-34B-Modell 4608 Mark, um 8 Video-Frames zu verarbeiten, während BLIP-3-VIDEO nur 32 Punkte benötigt, um einen 77,7% igen MSVD-QA-Benchmark-Score zu erzielen. Dies zeigt, dass BLIP-3-VIDEO den Ressourcenverbrauch erheblich reduziert und gleichzeitig eine hohe Leistung aufrechterhält.

Darüber hinaus sollte die Leistung von BLIP-3-VIDEO in Multiple-Choice-Fragen und-Antwort-Aufgaben nicht unterschätzt werden. Im Datensatz des nächsten QA erzielte das Modell einen hohen Wert von 77,1%, während es im TGIF-QA-Datensatz auch eine Genauigkeitsrate von 77,1%erreichte. Alle diese Daten weisen auf die Effizienz von BLIP-3-VIDEO hin, wenn es sich um komplexe Videoprobleme handelt.

BLIP-3-VIDEO eröffnet im Bereich der Videoverarbeitung neue Möglichkeiten durch innovative Timing-Encoder. Die Einführung dieses Modells verbessert nicht nur die Effizienz des Videoverständnisses, sondern bietet auch mehr Möglichkeiten für zukünftige Videoanwendungen.

Projekteingang: https://www.salesforceAresearch.com/opensource/xgen-mm-vid/index.html

Schlüsselpunkte:

.

- ** Effiziente Verarbeitung **: Die Verwendung eines Timing -Encoders reduziert die Anzahl der erforderlichen visuellen Markierungen erheblich und verbessert die Recheneffizienz erheblich.

.

Kurz gesagt, BLIP-3-VIDEO hat mit seinen effizienten Verarbeitungsfunktionen und hervorragenden Leistung erhebliche Fortschritte in das Gebiet des Videoverständnisses gebracht, und seine Anwendungsaussichten sind breit. Die Open Source dieses Modells bietet auch eine gute Grundlage für weitere Forschung und Anwendung.