Forscher der Princeton University und der Yale University führten eingehende Forschungen über die Argumentationsfähigkeit von Großsprachenmodellen (LLM) durch und veröffentlichten relevante Berichte. Die Studie nahm das Verschiebungskennwort als Testaufgabe ein und wählte drei LLMS GPT-4, Claude3 und LLAMA3.1 zur Analyse aus, um den Mechanismus hinter COT-Inferenz aufzudecken. Untersuchungen haben ergeben, dass LLMs COT -Argumentation kein einfaches symbolisches logisches Denken ist, sondern ein Ergebnis der komplexen Interaktion mehrerer Faktoren, die eine neue Perspektive für uns bietet, um die Argumentationsfähigkeit von LLM zu verstehen.

Forscher der Princeton und der Yale University haben kürzlich einen Bericht über die Gründe für die Fähigkeit „Verknüpfung von Ketten“ (COT) “im großen Sprachmodell (LLM) veröffentlicht, in dem das Geheimnis des COT -Denkens enthüllt wird: Es ist nicht symbolisches Denken, das ausschließlich auf logischen Regeln basiert, sondern aber Es kombiniert Speicher, Wahrscheinlichkeit und Rauschen.

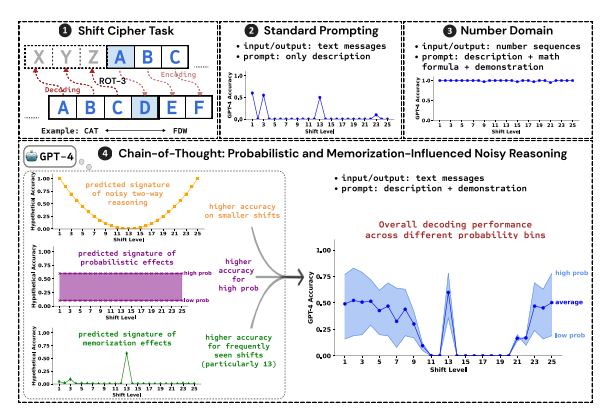

Die Forscher verwendeten das Verschiebungskennwort als Testaufgabe, um die Leistung der drei LLMs GPT-4, Claude3 und LLAMA3.1 zu analysieren. Schichtkennwörter sind eine einfache Codierungsmethode, und jeder Buchstaben wird durch Buchstaben ersetzt, die im Alphabet mit festen Ziffern vorwärts gehen. Bewegen Sie zum Beispiel das Alphabet um 3 Ziffern vorwärts und "Katze" wird zu "FDW".

Die Forschungsergebnisse zeigen, dass die drei Schlüsselfaktoren, die die Wirksamkeit von COT -Inferenz beeinflussen, betrifft:

Wahrscheinlichkeit: LLM neigt dazu, Ausgänge mit höherer Wahrscheinlichkeit zu erzeugen, auch wenn der Inferenzschritt auf Antworten mit geringerer Wahrscheinlichkeit hinweist. Wenn der Argumentationsschritt beispielsweise zu "STAZ" zeigt, aber "Stay" das allgemeinere Wort ist, kann LLM sich selbst "korrigieren" und "Aufenthalt" ausgeben.

Speicher: LLM erinnert sich an eine große Menge an Textdaten während der Vorausbildung, was die Genauigkeit seiner COT-Inferenz beeinflusst. Zum Beispiel ist Rot-13 das häufigste Schichtkennwort, und LLM hat eine deutlich höhere Genauigkeit für Rot-13 als andere Arten von Schichtkennwörtern.

Lärmreundierung: Der Argumentationsprozess von LLM ist nicht vollständig genau, aber es gibt einen gewissen Grad an Rauschen. Mit zunehmender Verschiebung des Verschiebungskennworts steigt auch die für die Dekodierung erforderlichen Zwischenschritte und die Auswirkungen der Rauschinferenz werden offensichtlicher, was zu einer Abnahme der Genauigkeit des LLM führt.

Die Forscher fanden auch heraus, dass die COT-Argumentation von LLM auf der Selbstverdauung beruht, d. H. LLM muss den Text explizit als Kontext für nachfolgende Argumentationsschritte generieren. Wenn die LLM angewiesen wird, "stillschweigend" zu denken, ohne einen Text auszugeben, wird seine Argumentationsfähigkeit stark reduziert. Darüber hinaus hat die Wirksamkeit des Demonstrationsschritts nur geringe Auswirkungen auf die Inferenz von COT.

Diese Studie zeigt, dass LLMs COT -Argumentation kein perfektes symbolisches Denken ist, sondern mehrere Faktoren wie Gedächtnis, Wahrscheinlichkeit und Lärm -Argumentation kombiniert. LLM zeigt nicht nur die Eigenschaften eines Speichermeisters im Prozess des COT -Denkens, sondern zeigt auch den Stil eines Wahrscheinlichkeitsmeisters. Diese Forschung hilft uns, ein tieferes Verständnis der Argumentationsfähigkeiten von LLM zu haben und wertvolle Einblicke für die zukünftige Entwicklung leistungsfähigerer KI -Systeme zu geben.

Papieradresse: https://arxiv.org/pdf/2407.01687

Zusammenfassend ist diese Studie von großer Bedeutung für das Verständnis des Argumentationsmechanismus großer Sprachmodelle, und ihre Ergebnisse bieten wertvolle Referenz für die Verbesserung der Argumentationsfähigkeiten von LLM in Zukunft und die Entwicklung leistungsfähigerer KI -Systeme. Die Studie betont die Auswirkungen von Faktoren wie Wahrscheinlichkeit, Gedächtnis und Rauschen auf das LLM -Argumentation und bietet Forschern im Bereich der KI neue Richtungen.