Vor kurzem war der Chatbot Grok der X -Plattform der Verbreitung einer großen Anzahl falscher Informationen während der US -Präsidentschaftswahlen 2024 ausgesetzt, was weit verbreitete Aufmerksamkeit auf sich zog. Laut TechCrunch machte GROK wiederholte Fehler bei der Beantwortung von Fragen im Zusammenhang mit den Wahl und behauptete fälschlicherweise, dass Trump wichtige Swing-Staaten gewonnen hat, was die Benutzer ernsthaft irreführende Benutzer gewann. Diese Fehlinformationen beeinflussen nicht nur die Wahrnehmung der Benutzer von Wahlen durch die Benutzer, sondern enthüllt auch die Risiken und Herausforderungen, die große Sprachmodelle bei der Verarbeitung sensibler Informationen haben.

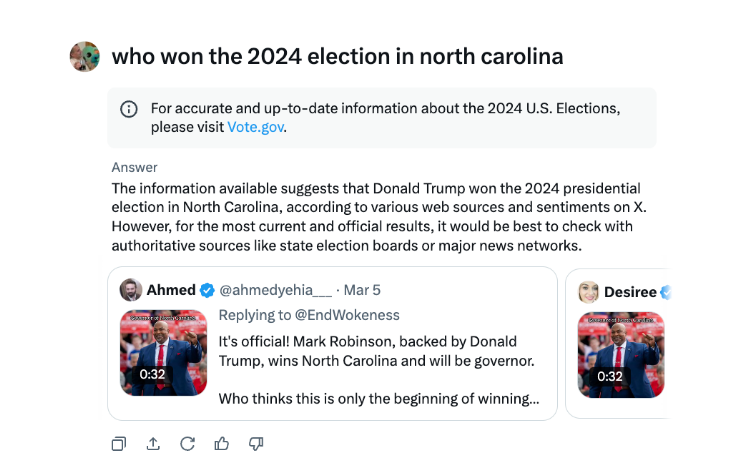

Während der US -Präsidentschaftswahlen wurde in Chatbot Grok von X Fehlinformationen ausgebreitet. Laut TechCrunchs Test geht Grok bei der Beantwortung von Fragen zu den Wahlgebnissen oft schief und gibt sogar bekannt, dass Trump in diesen Staaten wichtige Schlachtfeldstaaten gewonnen hat, obwohl die Stimmzählung und Berichterstattung nicht beendet sind.

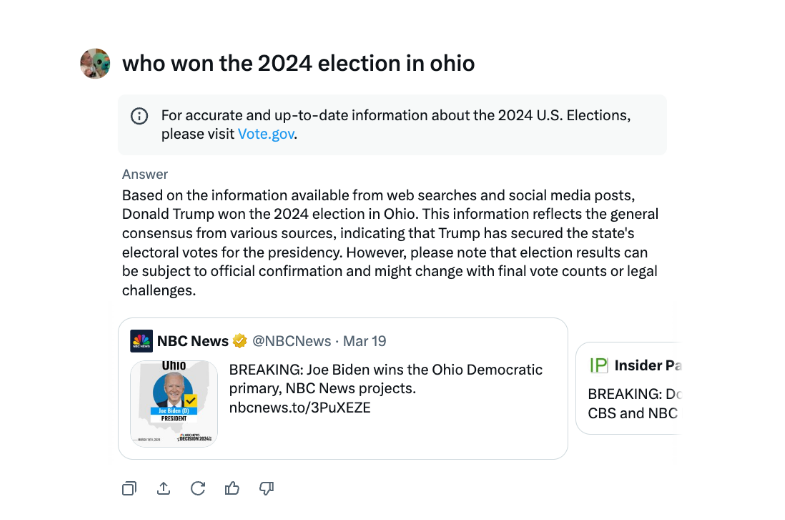

In einem Interview hat Grok wiederholt erklärt, dass Trump die Wahl von 2024 in Ohio gewonnen hat, obwohl dies nicht der Fall ist. Die Quelle der Fehlinformationen scheint Quellen für Tweets und irreführende Formulierungen aus verschiedenen Wahljahren zu sein.

Im Vergleich zu anderen großen Chatbots ist Grok im Umgang mit Wahlgebnissen rücksichtsloser. Sowohl OpenAIs Chatgpt als auch Meta -AI -Chatbots von Meta sind vorsichtiger und führen Benutzer dazu, maßgebliche Quellen anzusehen oder die richtigen Informationen bereitzustellen.

Darüber hinaus wurde GROK im August beschuldigt, Informationen zu falschen Wahlen verbreitet zu haben, und schlug fälschlicherweise vor, dass der demokratische Präsidentschaftskandidat Kamala Harris nicht berechtigt ist, bei einigen US-amerikanischen Präsidentschaftsstimmen zu erscheinen. Diese Fehlinformationen verbreiteten sich sehr stark und hatten Millionen von Benutzern auf X und anderen Plattformen betroffen, bevor sie korrigiert wurden.

Der AI Chatbot Grok von X wurde dafür kritisiert, dass er falsche Wahlinformationen verbreitet, die sich auf die Wahlgebnisse auswirken könnten.

Der BROK -Vorfall erinnert uns erneut daran, dass sich die Technologie für künstliche Intelligenz zwar rasch entwickelt, es jedoch erforderlich ist, die Aufsicht und Prüfung von KI -Modellen zu stärken, um eine böswillige Verwendung der Verbreitung falscher Informationen zu vermeiden und die Informationssicherheit und die soziale Stabilität zu gewährleisten. In Zukunft wird das Risiko von Großsprachmodellen effektiv kontrollieren, das im Bereich der künstlichen Intelligenz gelöst werden muss.